Bis ins kleinste Detail perfekte Hände, Gesichter und mehr verspricht Deepmind mit seinem neuen Bildgenerator Imagen 2. Dabei schließt Google auch Lücken, die die Konkurrenz bisher hatte.

Googles KI-Abteilung Deepmind hat mit Imagen 2 seinen neuesten KI-Bildgenerator vorgestellt, der auf der weit verbreiteten Diffusionstechnologie basiert. Imagen 2 soll die bis dato hochwertigsten und fotorealistischsten Bilder aller Google-Modelle erstellen und dabei streng die Prompts von Benutzer:innen befolgen.

Imagen 2 kann Prompts genauer befolgen

Imagen 2 hat sein Verständnis der Prompts durch die Verwendung zusätzlicher Beschreibungen in den Bildunterschriften seines Trainingsdatensatzes verbessert. Dadurch lernt Imagen 2 verschiedene Beschriftungsstile und entwickelt ein besseres Verständnis für eine Vielzahl von Prompts.

Die verbesserten Bild-Text-Beziehungen sollten das Verständnis von Kontext und Nuancen verbessern. OpenAI hat die Text-Bild-Beziehungen in DALL-E 3 auf ähnliche Weise verbessert.

Dank der Fortschritte bei Datensatz und Modell kann Imagen 2 laut Google Verbesserungen in vielen Bereichen erzielen, in denen Text-to-Image-Systeme oft Schwierigkeiten haben. Dazu gehören realistische menschliche Hände und Gesichter. Außerdem sollen Bildfehler weitgehend ausgemerzt sein.

Um die Bildqualität zu verbessern, wurde ein ästhetisches Modell entwickelt, das auf menschlichen Präferenzen für Qualitätsmerkmale wie gute Beleuchtung, Bildkomposition, Belichtung und Schärfe basiert. Jedes Bild erhielt eine ästhetische Bewertung, die Imagen 2 dabei half, die Bilder des Trainingsdatensatzes, die den menschlichen Präferenzen entsprachen, stärker zu gewichten.

Imagen 2 kommt mit Inpainting, Outpainting und flexibler Stilkontrolle

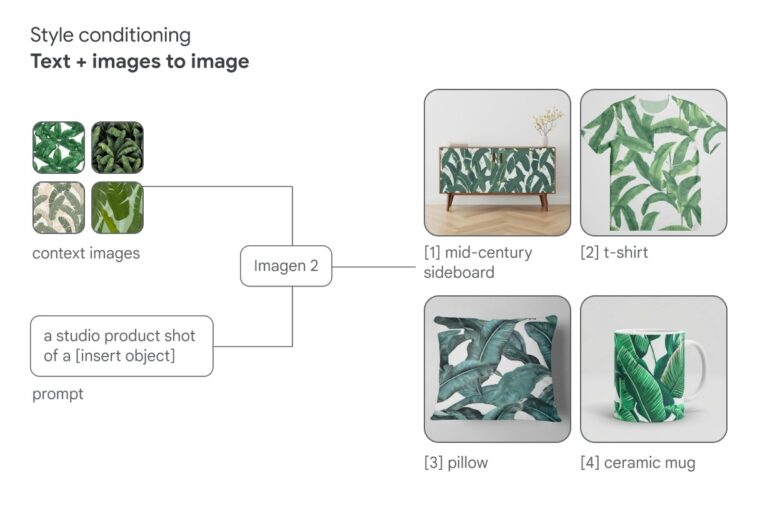

Die Diffusionstechnik von Imagen 2 bieten laut Google ein hohes Maß an Flexibilität, das es erleichtert, den Stil eines Bildes zu kontrollieren und anzupassen, z. B. durch die Verwendung von Referenzbildern zusätzlich zum Text.

Imagen 2 ermöglicht von Beginn an Bildbearbeitungsfunktionen wie "Inpainting" und "Outpainting". Mit diesen Techniken können Benutzer neue Inhalte direkt in das Originalbild einfügen oder das Originalbild über seine Grenzen hinaus erweitern. Solche Funktionen sind dringend notwendig, um mit Generative Fill von Adobe Firefly oder dem Zoom-Out von Midjourney mithalten zu können.

Googles neue Bild-KI ist zunächst für Entwickler und Cloud-Kunden über die Imagen-API in Google Cloud Vertex AI verfügbar. Das Google Arts and Culture Team nutzt die Technologie in seinem Cultural Icons Experiment, um kulturelles Wissen mithilfe von Google-KI zu vermitteln.

Imagen 2 ist bisher nicht sicher genug für den Privatgebrauch

Auch Endnutzer:innen sollen in Zukunft Zugriff auf Imagen 2 erhalten. Zunächst will Google jedoch "mögliche Risiken und Herausforderungen" der Technologie minimieren. Von der Entwicklung bis zur Implementierung hat Google dafür laut eigenen Angaben strenge Sicherheitsvorkehrungen in seinen Produkten getroffen.

Eine davon ist SynthID, ein Toolkit zur Markierung und Identifizierung von KI-generierten Inhalten. Damit können autorisierte Google Cloud-Kunden ein unsichtbares digitales Wasserzeichen direkt in die Bildpixel einfügen, ohne die Bildqualität zu beeinträchtigen. Das Wasserzeichen bleibt für SynthID auch nach dem Filtern, Beschneiden oder Komprimieren beim Speichern erhalten.

Darüber hinaus hat Google laut eigenen Angaben von Anfang an in die Datensicherheit von Imagen 2 investiert und technische Schutzmaßnahmen eingeführt, um problematische Ausgaben wie gewalttätige, anstößige oder sexuell explizite Inhalte zu begrenzen. Sicherheitstests wurden sowohl für die Trainingsdaten als auch für die Prompts und die vom System generierten Ausgaben während der Generierung durchgeführt.

Imagen 2 ist als Antwort auf das jüngste Bildmodell DALL-E 3 von OpenAI zu verstehen, das neben der Bildqualität vor allem auch durch die einfache Zugänglichkeit über ChatGPT punktet. Wie Google Imagen 2 unter die Leute bringen will, hat das Unternehmen bisher nicht verraten. Eine Integration in Bard erscheint jedoch logisch.

Die neue Version knüpft an die erste Imagen-Generation an, die im Mai 2022 angekündigt wurde. Damals hatte Google noch einen kleinen technologischen Vorsprung gegenüber OpenAI, den der Konkurrent inzwischen längst aufgeholt hat.

Spannend bleibt auch die Frage, inwieweit Imagen 2 den Weg für weitere Video-KIs von Google ebnet. Hier hatten Meta und das Start-up Pika Labs zuletzt große Fortschritte gemacht. Allerdings zeigte auch Google mit Phenaki und Imagen Video schon qualitativ hochwertige Text-zu-Bild-Videogenerierung.