InstantMesh verwandelt ein 2D-Bild in Sekundenschnelle in ein 3D-Objekt

Ein Forschungsteam aus China präsentierte InstantMesh, ein KI-Framework, das aus Einzelbildern in Sekundenschnelle hochwertige 3D-Netze erzeugen kann.

Forscherinnen und Forscher des Tencent PCG ARC Lab und der Shanghai Tech University haben InstantMesh entwickelt, ein Open-Source-Framework für die schnelle Erstellung hochwertiger 3D-Meshes aus einzelnen 2D-Bildern. Laut dem als Preprint veröffentlichten Artikel kann die Methode detaillierte 3D-Assets in nur zehn Sekunden erzeugen.

Die Entwicklung solcher Verfahren zur Generierung von 3D-Modellen aus Einzelbildern schreitet rasch voran, ständig erscheinen Arbeiten über ein etwas genaueres oder etwas schnelleres Modell.

Im Vergleich zu Bilddiffusionsmodellen wie Midjourney, Firefly 2 oder SDXL, die innerhalb von Sekunden fotorealistische Einzelbilder erzeugen, sind 3D-Modelle jedoch weniger detailliert und können Fehler aufweisen. Die Vorteile der Diffusionstechnik soll jetzt auch bei 3D-Generatoren ankommen.

Mesh statt NeRF

Die Architektur von InstantMesh besteht aus zwei Hauptkomponenten: einem Multi-View-Diffusionsmodell und einem Rekonstruktionsmodell für 3D-Netze aus wenigen Ansichten.

Das Multi-View-Diffusionsmodell ist darauf trainiert, aus einem Eingabebild 3D-konsistente Ansichten aus verschiedenen Blickwinkeln zu synthetisieren und könnte theoretisch beliebig im InstantMesh-Framework ausgetauscht werden.

Anstelle eines Einzelbildes als Eingabe könnte auch nur ein Textprompt verwendet werden. Diese Ansichten dienen dann als Input für das Rekonstruktionsmodell.

Als 3D-Darstellung setzt InstantMesh direkt auf Meshes anstelle der in bisherigen Verfahren verwendeten Triplane-NeRF-Darstellung. Durch die effiziente Mesh-Rasterung können hochaufgelöste RGB-Bilder sowie Tiefen- und Normalenkarten als zusätzliche geometrische Informationen für das Training verwendet werden.

Im Vergleich zu NeRF-basierten Ansätzen führt dies laut den Forschenden zu glatteren Meshes. Zudem könnten die erzeugten Meshes leichter nachbearbeitet werden, was jedoch in Zukunft noch weiter erforscht werden müsse.

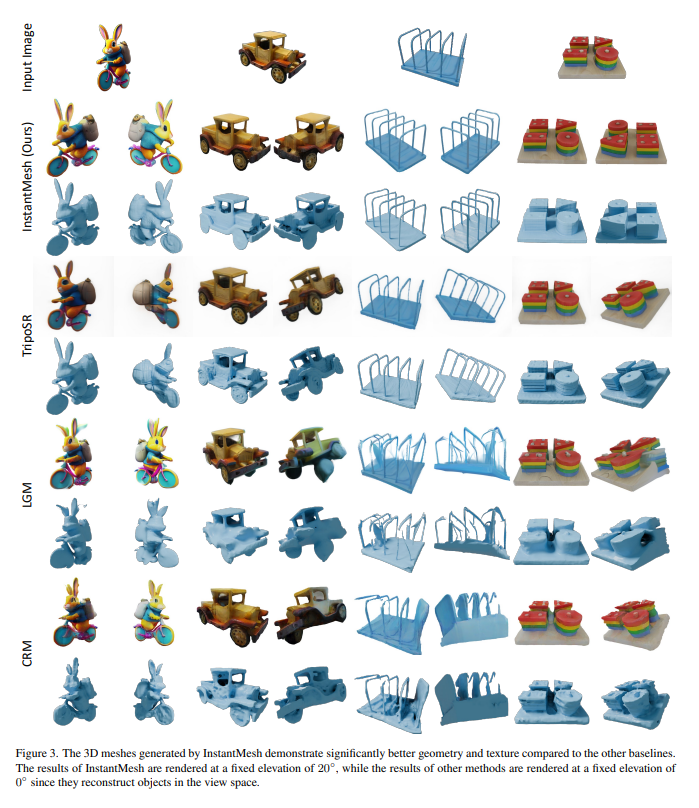

In Experimenten erzielt InstantMesh laut dem Paper sowohl bei der wahrgenommenen Qualität synthetisierter neuer Ansichten als auch bei der geometrischen Genauigkeit deutlich bessere Ergebnisse als aktuelle Vergleichsverfahren wie TripoSR, LGM und Stable Video 3D.

Demo jetzt auf Hugging Face verfügbar

Ungewöhnlich für Forschungen in diesem Bereich: Parallel zu diesem Paper stellen die Forschenden auch den gesamten Code, die trainierten Modellvarianten und eine Demo auf Hugging Face von InstantMesh Open Source zur Verfügung.

Hier lässt sich aus vorgegebenen Beispielbildern wählen oder eigene hochladen, sowohl Fotografien als auch KI-Generationen. Sollte das Ergebnis nicht zufriedenstellend sein, empfehlen die Entwickler:innen, den Seed zu verändern, der die Multi-View-Ansicht bestimmt und dadurch die Qualität des 3D-Objekts maßgeblich beeinflusst.

Für die Zukunft haben sich die Forschenden unter anderem vorgenommen, die Auflösung der generierten 3D-Meshes zu erhöhen und fortschrittlichere Multi-View-Diffusionsarchitekturen zu verwenden, um die Konsistenz zwischen den Ansichten weiter zu verbessern. Insbesondere für die Entwicklung von Videospielen könnten Technologien wie diese einen Produktivitätsschub bedeuten.

KI-News ohne Hype – von Menschen kuratiert

Mit dem THE‑DECODER‑Abo liest du werbefrei und wirst Teil unserer Community: Diskutiere im Kommentarsystem, erhalte unseren wöchentlichen KI‑Newsletter, 6× im Jahr den „KI Radar"‑Frontier‑Newsletter mit den neuesten Entwicklungen aus der Spitze der KI‑Forschung, bis zu 25 % Rabatt auf KI Pro‑Events und Zugriff auf das komplette Archiv der letzten zehn Jahre.

Jetzt abonnierenKI-News ohne Hype

Von Menschen kuratiert.

- Mehr als 20 Prozent Launch-Rabatt.

- Lesen ohne Ablenkung – keine Google-Werbebanner.

- Zugang zum Kommentarsystem und Austausch mit der Community.

- Wöchentlicher KI-Newsletter.

- 6× jährlich: „KI Radar“ – Deep-Dives zu den wichtigsten KI-Themen.

- Bis zu 25 % Rabatt auf KI Pro Online-Events.

- Zugang zum kompletten Archiv der letzten zehn Jahre.

- Die neuesten KI‑Infos von The Decoder – klar und auf den Punkt.