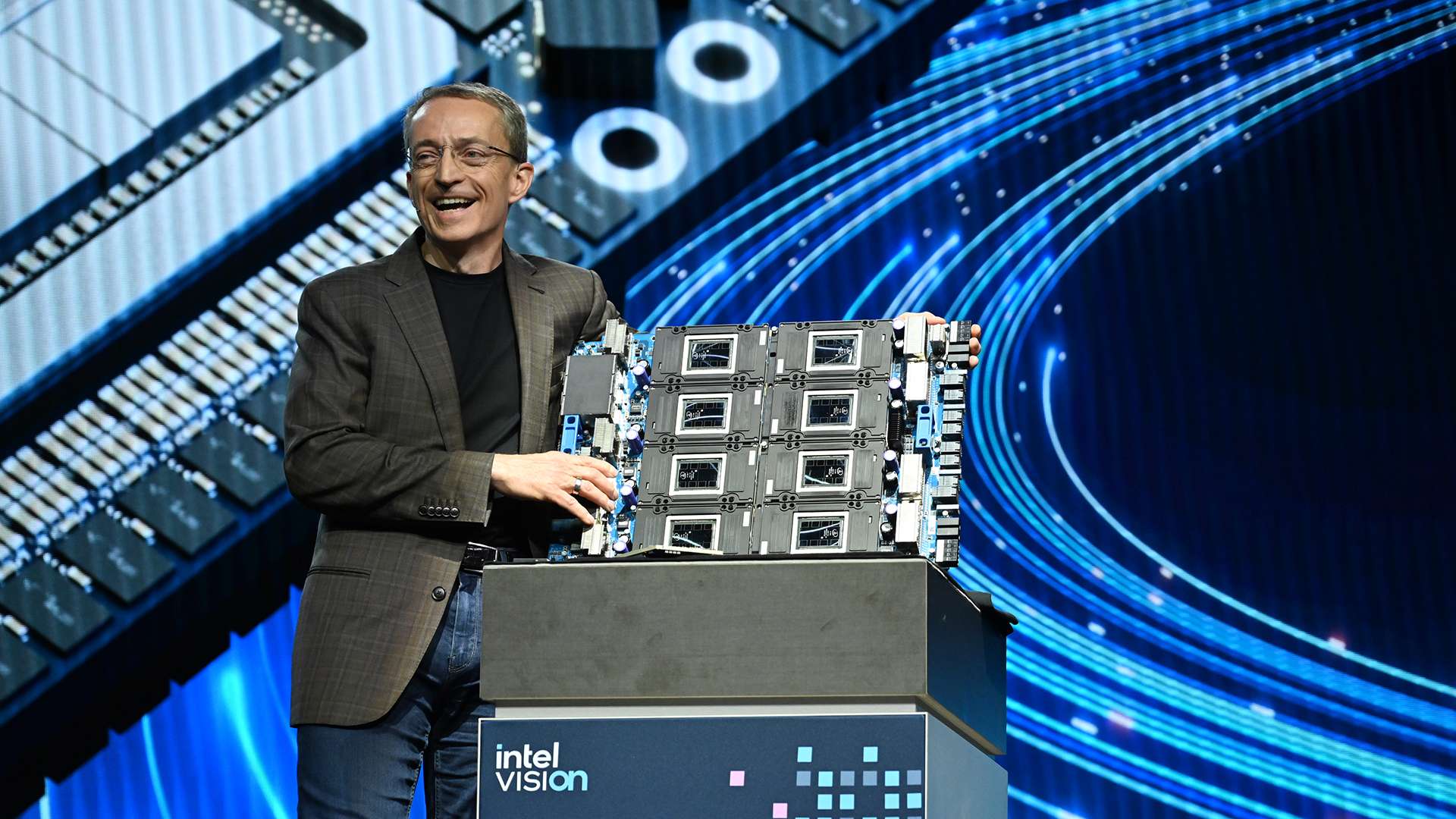

Intel stellt neuen KI-Chip "Gaudi 3" vor

Intel hat auf der Vision 2024 seinen neuen KI-Beschleuniger Gaudi 3 offiziell vorgestellt.

Nach Angaben des Unternehmens soll Gaudi 3 die Trainingszeit bei Llama2-Modellen mit 7B- und 13B-Parametern sowie beim GPT-3-Modell mit 175B-Parametern im Vergleich zur Nvidia H100 um etwa 50 % verkürzen. Auch beim Inferenzdurchsatz soll Gaudi 3 die GPUs H100 und H200 je nach Modell um durchschnittlich etwa 50 % bzw. 30 % übertreffen.

In der Standardversion verfügt Gaudi 3 über 96 MB integrierten SRAM-Cache mit 12,8 TB/s Bandbreite und 128 GB HBM2e-Speicher mit 3,7 TB/s Spitzenbandbreite. Laut Intel bietet der Chip die doppelte FP8- und die vierfache BF16-Rechenleistung sowie die doppelte Netzwerkbandbreite und die 1,5-fache Speicherbandbreite seines Vorgängers. Der im 5nm-Prozess gefertigte KI-Beschleuniger soll zudem deutlich günstiger sein als Nvidias H100. Allerdings hat die Konkurrenz mit der Blackwell-Architektur bereits ein neues Angebot.

Intel plant offene Plattform für KI

Gaudi 3 soll Unternehmen erlauben, KI-Systeme mit bis zu Zehntausenden Beschleunigern flexibel zu skalieren - von einzelnen Knoten bis hin zu Mega-Clustern. Dabei setzt Intel auf offene, Community-basierte Software und standardisiertes Ethernet-Networking. Ab dem 2. Quartal 2024 ist Gaudi 3 für OEMs wie Dell, HPE, Lenovo und Supermicro verfügbar. Neue Kunden und Partner für den Intel Gaudi Accelerator wie Airtel, Bosch, IBM, NAVER und SAP wurden ebenfalls vorgestellt.

Intel plant zudem zusammen mit Partnern wie SAP, RedHat und VMware eine offene Plattform für Enterprise KI zu schaffen. Ziel ist es, die Einführung von sicheren GenAI-Systemen zu beschleunigen, die auf dem RAG-Ansatz (Retrieval-Augmented Generation) basieren. Dieser ermöglicht es, firmeneigene Datenquellen mit Open-Source-Sprachmodellen zu kombinieren.

KI-News ohne Hype – von Menschen kuratiert

Mit dem THE‑DECODER‑Abo liest du werbefrei und wirst Teil unserer Community: Diskutiere im Kommentarsystem, erhalte unseren wöchentlichen KI‑Newsletter, 6× im Jahr den „KI Radar"‑Frontier‑Newsletter mit den neuesten Entwicklungen aus der Spitze der KI‑Forschung, bis zu 25 % Rabatt auf KI Pro‑Events und Zugriff auf das komplette Archiv der letzten zehn Jahre.

Jetzt abonnierenKI-News ohne Hype

Von Menschen kuratiert.

- Mehr als 20 Prozent Launch-Rabatt.

- Lesen ohne Ablenkung – keine Google-Werbebanner.

- Zugang zum Kommentarsystem und Austausch mit der Community.

- Wöchentlicher KI-Newsletter.

- 6× jährlich: „KI Radar“ – Deep-Dives zu den wichtigsten KI-Themen.

- Bis zu 25 % Rabatt auf KI Pro Online-Events.

- Zugang zum kompletten Archiv der letzten zehn Jahre.

- Die neuesten KI‑Infos von The Decoder – klar und auf den Punkt.