Japanisches KI-Start-up stellt KI-System vor, das wie ein Gehirn in Zeitschritten denkt

Das japanische Start-up Sakana AI hat ein KI-Modell vorgestellt, das neuronale Zeitdynamiken simulieren soll. Erste Tests deuten auf neue Repräsentationsformen hin, ob sich daraus jedoch ein Durchbruch ergibt, bleibt offen.

Mit der sogenannten "Continuous Thought Machine" (CTM) will Sakana AI neue Wege in der KI-Entwicklung einschlagen. Das Modell basiert den Forschenden zufolge auf der Idee, neuronale Aktivität als zeitliche Dynamik statt als Momentaufnahme zu betrachten.

Statt klassischer Aktivierungsfunktionen kommen sogenannte neuron-level models (NLMs) zum Einsatz, die eine Historie vergangener Aktivierungen verarbeiten. Als zentrale Repräsentation dient die Synchronisation der Neuronen über Zeit – eine Anlehnung an Prozesse im biologischen Gehirn. Sich an der Natur zu orientieren, hatte das Start-up aus Tokio bereits bei seiner Gründung 2023 angekündigt.

Durch sogenanntes "Budget Forcing" haben Forschende bereits in der Vergangenheit Sprachmodelle dazu gezwungen, länger über Probleme nachzudenken. Dabei handelte es sich jedoch hauptsächlich um effizientes Prompt Engineering. Im Gegensatz dazu scheint die CTM eine neue LLM-Architektur vorzuschlagen. Generell basieren auch Reasoning-Modell,e im Gegensatz zu herkömmlichen Sprachmodellen, auf der Idee, während der Inferenz mehr Rechenleistung zu verwenden.

Mehrstufiger Denkprozess

Die CTM arbeitet mit einem internen Zeitbegriff, den sogenannten "internal ticks", die vom Dateninput entkoppelt sind. Laut den Forschenden ermöglicht dieses Konzept, dass das Modell bei der Lösung von Aufgaben mehrere Schritte "nachdenken" kann, anstatt sofort eine Entscheidung in einem einzigen Durchlauf zu treffen.

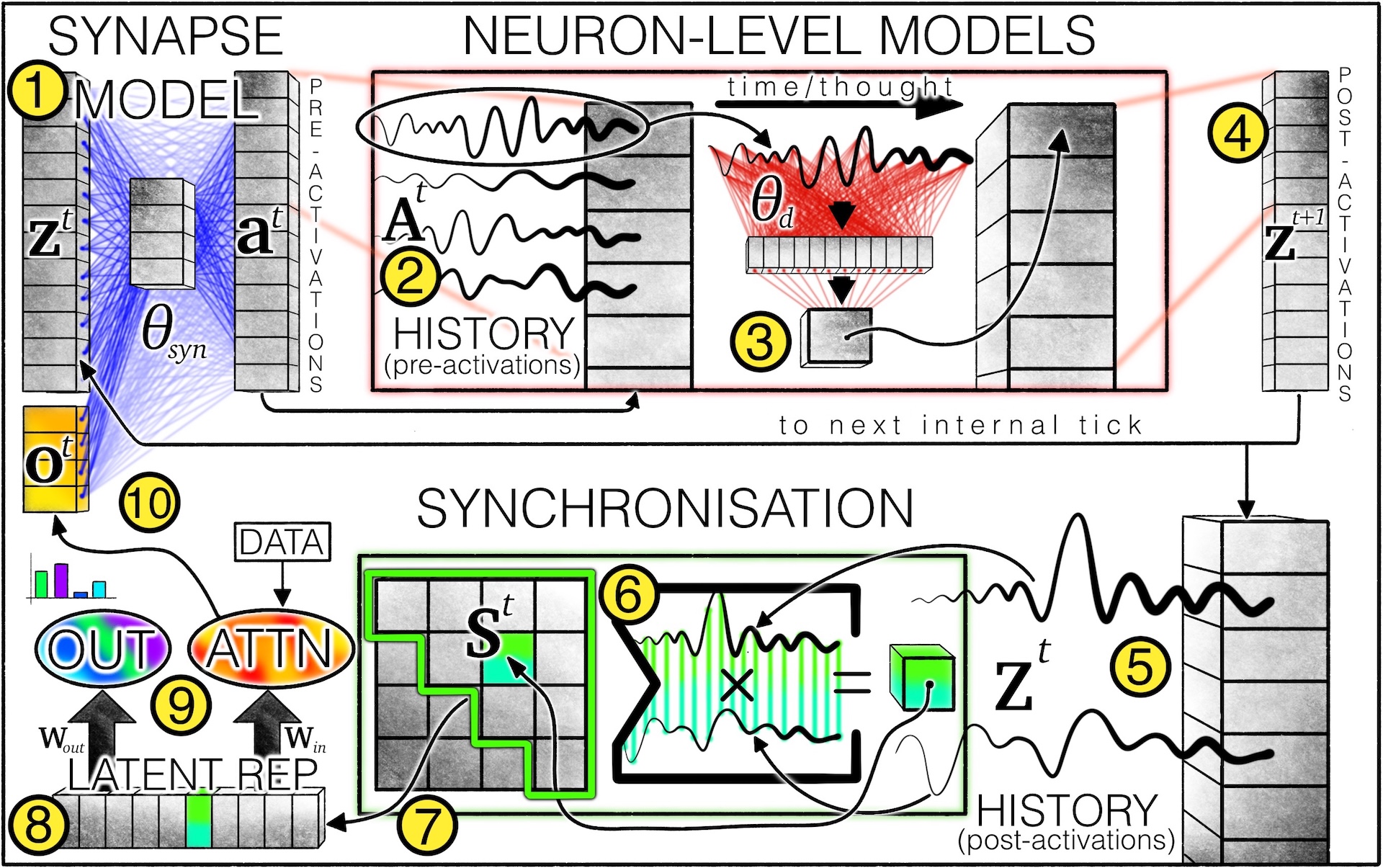

Dabei verläuft der Denkprozess in mehreren internen Schritten. Zunächst verarbeitet ein sogenanntes "Synapsen-Modell" die aktuellen Neuronenzustände sowie externe Eingabedaten, um erste Signale zu erzeugen – die sogenannten Prä-Aktivierungen. Jedes Neuron führt eine Historie dieser Signale, die im weiteren Verlauf berücksichtigt wird.

Anschließend greifen individuelle "Neuronen-Modelle" auf diese Historien zurück, um daraus ihre nächsten Zustände – die Post-Aktivierungen – zu berechnen.

Auch diese Neuronenzustände werden über die Zeit hinweg aufgezeichnet, um zu analysieren, wie stark die Neuronen miteinander synchronisiert sind. Diese Synchronisation stellt die zentrale interne Repräsentation des Modells dar. Auf Grundlage dieser Information wird die finale Ausgabe des Modells erzeugt.

Zusätzlich nutzt CTM einen Aufmerksamkeitsmechanismus, um relevante Teile der Eingabedaten gezielt auszuwählen. Die so verarbeiteten Informationen sowie die aktualisierten Neuronenzustände fließen anschließend wieder in den Prozess zurück, um den nächsten Denkschritt auszulösen.

In Experimenten zeigte sich, dass das Modell etwa bei der Bildklassifikation im ImageNet-1K-Datensatz sukzessive verschiedene Bildbereiche analysierte. Die Genauigkeit lag dabei bei 72,47 Prozent (Top-1) bzw. 89,89 Prozent (Top-5) – für heutige Standards kein Spitzenwert, aber laut Sakana AI auch nicht das primäre Ziel des Projekts.

Die CTM soll ihre Verarbeitungstiefe zudem dynamisch anpassen können: Bei einfachen Aufgaben könne sie früher stoppen, bei komplexeren länger rechnen. Dies funktioniere laut der Veröffentlichung ohne zusätzliche Verlustfunktionen, sondern sei eine Eigenschaft der Architektur.

Synchronisation statt Snapshot

Der Kern der CTM ist die Verwendung von Synchronisationsmustern zwischen Neuronen als Repräsentation. Diese Muster werden aus der Historie der neuronalen Aktivitäten berechnet und zur Steuerung von Aufmerksamkeit und Vorhersagen genutzt. Die Methode soll es ermöglichen, Informationen über verschiedene Zeitskalen zu integrieren, etwa kurzzeitige Reaktionen auf neue Daten oder längerfristige Muster.

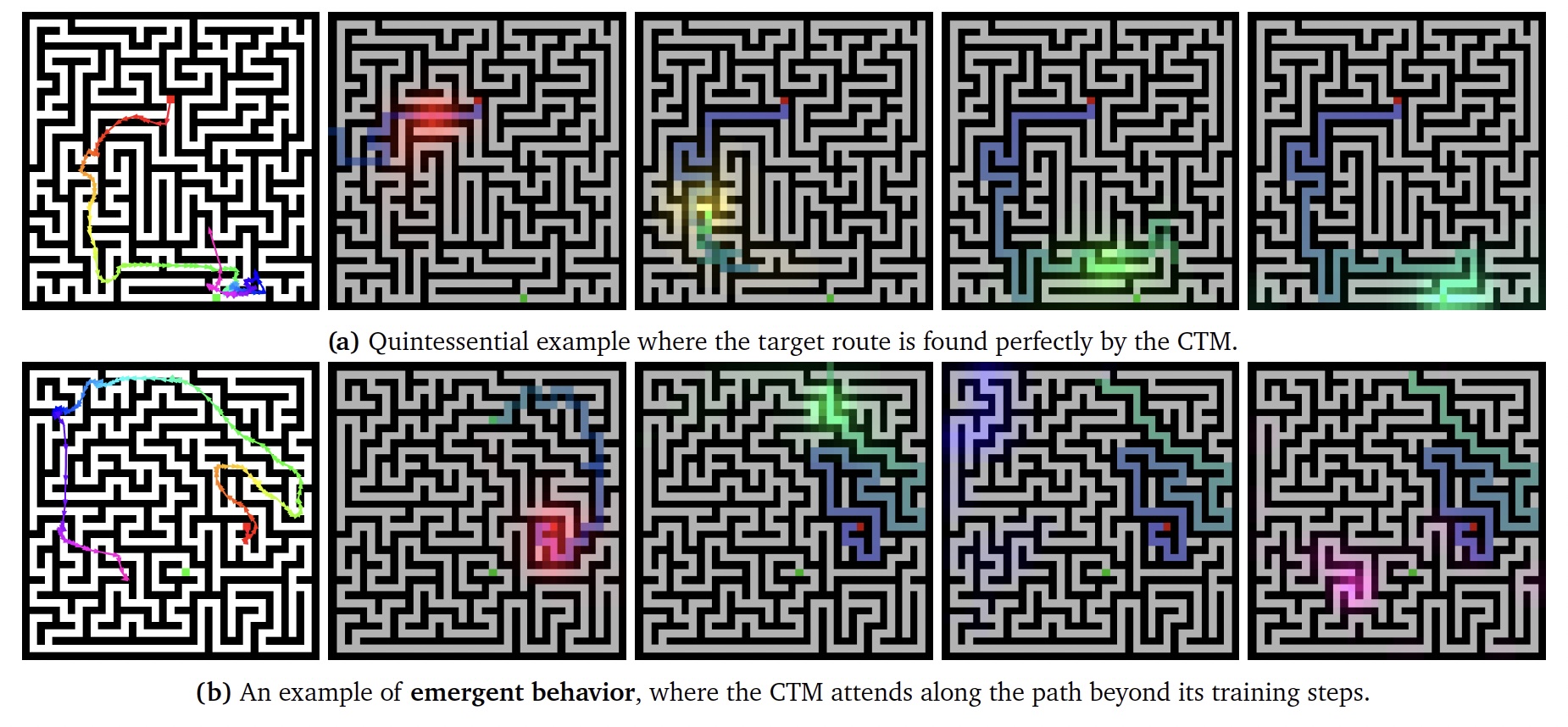

In einem Labyrinthexperiment zeigte das Modell laut Studie ein Verhalten, das dem schrittweisen Planen einer Route ähnelt. Auch längere oder größere Labyrinthe, die während des Trainings nicht gesehen wurden, konnten zumindest teilweise gelöst werden. Dazu stellt die Firma eine interaktive Demo bereit, in der ein CTM-System im Browser in bis zu 150 Schritten den Weg aus einem Labyrinth findet.

Die Autor:innen betonen, dass diese Verhaltensweisen emergent seien, also nicht explizit programmiert, sondern aus dem Zusammenspiel von Architektur und Training entstanden.

Vergleich mit anderen Modellen

In einer Reihe von Tests verglichen die Forschenden die CTM mit etablierten KI-Architekturen: Zum einen mit sogenannten LSTMs (Long Short-Term Memory), die sich besonders gut für sequenzielle Daten eignen, zum anderen mit Feedforward-Netzen - der einfachsten Form künstlicher neuronaler Netze, die Daten nur in eine Richtung verarbeiten.

Die CTM zeigte dabei in verschiedenen Aufgaben bessere Ergebnisse: Beim Sortieren von Zahlenreihen und beim Berechnen von Paritäten (mathematische Aufgaben mit Zahlenfolgen) lernte sie schneller und zuverlässiger als die Vergleichsmodelle.

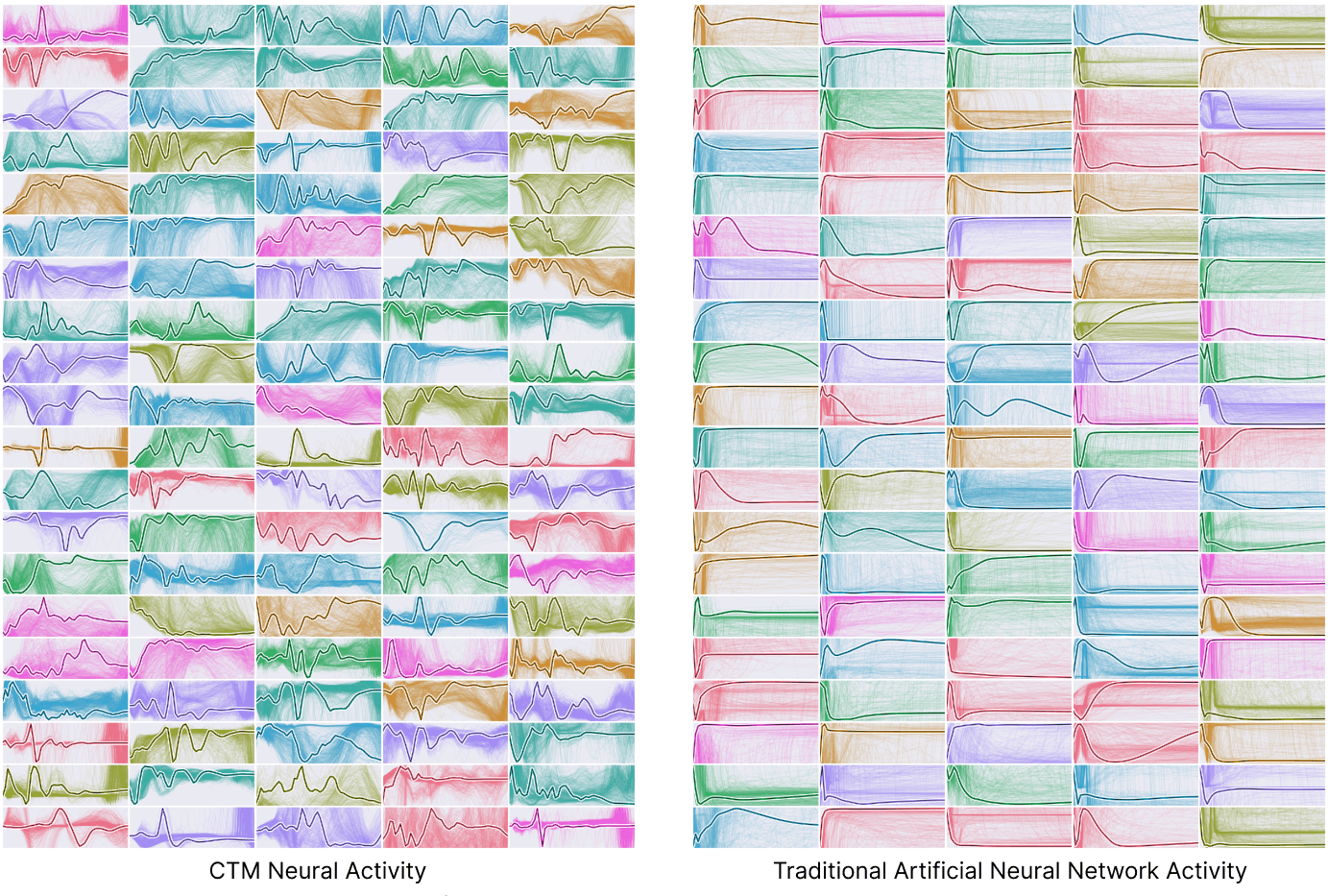

Die neuronalen Aktivitätsmuster der CTM waren deutlich vielfältiger und komplexer als bei den anderen Modellen. Ob diese reichhaltigeren Muster aber auch zu besseren Ergebnissen in praktischen Anwendungen führen, muss sich noch zeigen.

In einem weiteren Test mit CIFAR-10 - einem Standard-Datensatz mit 60.000 kategorisierten Bildern in zehn Klassen - schnitt die CTM ebenfalls leicht besser ab als die Vergleichsmodelle. Ihre Vorhersagen ähnelten dabei stärker dem menschlichen Entscheidungsverhalten.

Mit dem größeren CIFAR-100-Datensatz (100 Bildkategorien) untersuchten die Forschenden zudem, wie sich unterschiedliche Modellgrößen auswirken: Mehr Neuronen führten zwar zu vielfältigeren Aktivitätsmustern, verbesserten die Ergebnisse aber nicht automatisch.

Biologische Inspiration mit Rechenaufwand

Die CTM soll laut Sakana AI eine Brücke zwischen biologischer Plausibilität und praktischer Anwendbarkeit schlagen. Die Autoren betonen jedoch selbst, dass die Architektur nicht direkt biologisch realistisch sei, etwa weil reale Nervenzellen keinen Zugriff auf ihre eigene Aktivierungshistorie hätten. Vielmehr gehe es um funktionale Inspiration. Die Synchronisation über Zeit sei etwa ein Konzept, das auch in der Neurowissenschaft diskutiert wird.

Gleichzeitig bringt die CTM Nachteile mit sich: Die rekursive Verarbeitung ist nicht parallelisierbar, was längere Trainingszeiten bedeutet. Zudem erfordert das Modell deutlich mehr Parameter als klassische Architekturen. Ob sich der zusätzliche Aufwand lohnt, müsse in weiteren Arbeiten gezeigt werden.

Sakana AI hat den Code und die Modellcheckpoints veröffentlicht. Die Forschenden hoffen darauf, dass das Modell als Ausgangspunkt für weitere, stärker biologisch inspirierte KI-Systeme dienen kann.

KI-News ohne Hype – von Menschen kuratiert

Mit dem THE‑DECODER‑Abo liest du werbefrei und wirst Teil unserer Community: Diskutiere im Kommentarsystem, erhalte unseren wöchentlichen KI‑Newsletter, 6× im Jahr den „KI Radar"‑Frontier‑Newsletter mit den neuesten Entwicklungen aus der Spitze der KI‑Forschung, bis zu 25 % Rabatt auf KI Pro‑Events und Zugriff auf das komplette Archiv der letzten zehn Jahre.

Jetzt abonnierenKI-News ohne Hype

Von Menschen kuratiert.

- Mehr als 20 Prozent Launch-Rabatt.

- Lesen ohne Ablenkung – keine Google-Werbebanner.

- Zugang zum Kommentarsystem und Austausch mit der Community.

- Wöchentlicher KI-Newsletter.

- 6× jährlich: „KI Radar“ – Deep-Dives zu den wichtigsten KI-Themen.

- Bis zu 25 % Rabatt auf KI Pro Online-Events.

- Zugang zum kompletten Archiv der letzten zehn Jahre.

- Die neuesten KI‑Infos von The Decoder – klar und auf den Punkt.