Äußere Merkmale allein sollen nicht über das Geschlecht Auskunft geben, findet Google, und deaktiviert die entsprechende Funktion in einer KI-Entwicklerschnittstelle.

Künstliche Intelligenz verleiht unseren Maschinen Augen: Durch Kameras betrachtet, können Objekte und Menschen gleichermaßen analysiert und identifiziert werden. Googles KI-Kamera Lens beispielsweise erkennt laut des Unternehmens schon mehr als eine Milliarde Objekte.

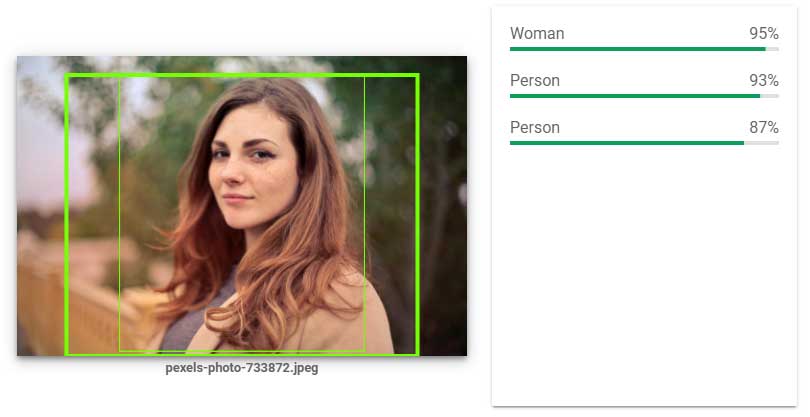

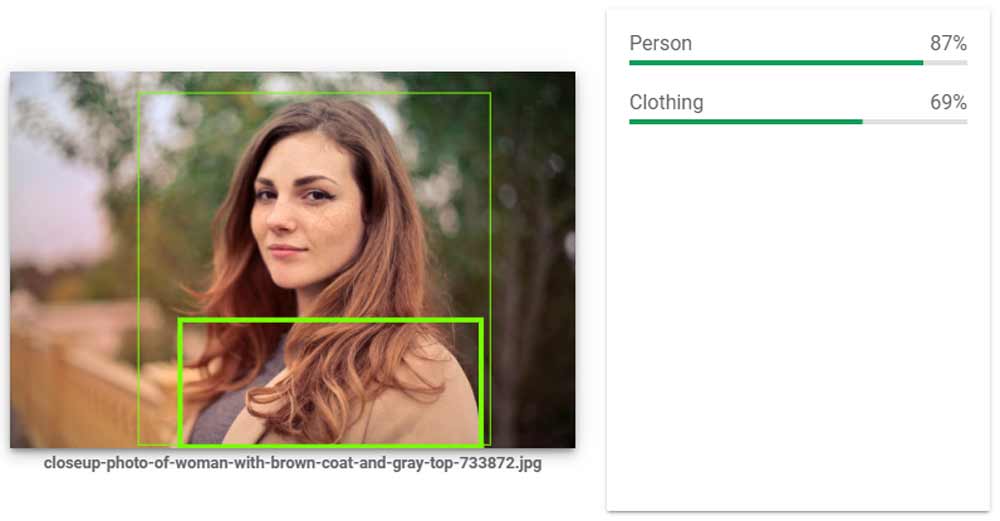

Eines sollen Googles Bildanalyse-Systeme in Zukunft jedoch nicht mehr unterscheiden: Das Geschlecht einer Person. Die entsprechende Schnittstelle von Googles Bildanalyse-KI "Cloud Vision" gibt ab sofort nicht mehr aus, ob eine identifizierte Person eher Mann oder eher Frau ist. Stattdessen soll die Zuweisung "Person" genügen.

Aussehen ungleich Geschlecht

Laut Google wurde die Anpassung vorgenommen, da es nicht möglich sei, allein aufgrund des äußeren Erscheinungsbilds auf das Geschlecht einer Person zu schließen. Die Entscheidung sei entlang der eigenen KI-Prinzipien getroffen worden, die laut Regel #2 vorurteilsbehaftete Künstliche Intelligenz verhindern sollen.

"KI-Algorithmen und -Datensätze können unfaire Verzerrungen widerspiegeln, verstärken oder reduzieren. Wir sind uns bewusst, dass die Unterscheidung zwischen fairen und unfairen Vorurteilen nicht immer einfach ist und sich von Kultur zu Kultur und Gesellschaft unterscheidet. Wir werden versuchen, ungerechte Auswirkungen auf Menschen zu vermeiden, insbesondere solche, die mit sensiblen Merkmalen wie Rasse, Ethnizität, Geschlecht, Nationalität, Einkommen, sexueller Orientierung, Fähigkeiten und politischer oder religiöser Überzeugung zusammenhängen."

Google verzichtete schon zuvor auf ein KI-Feature, um Geschlechtervorurteile zu vermeiden: Die Gmail-Funktion "Smart Compose", die automatisch Sätze vervollständigt, hatte versteckte geschlechtsspezifische Vorurteile übernommen. Beispielsweise wurde bei der Autovervollständigung der Investor automatisch als "er" bezeichnet, obwohl es auch eine Investorin hätte sein können.

Da solche Vorurteile nicht nachträglich aus den Daten entfernt werden konnten, schlägt Smart Compose keine geschlechtsspezifischen Pronomen mehr vor.

Via: Twitter

Weiterlesen über KI-Vorurteile:

- Amazons KI-Forscher erklärt, weshalb menschliche Vorurteile schwerer wiegen als maschinelle

- KI: Untersuchung zeigt maschinelle Vorurteile

- Google erklärt, wie Computer Vorurteile entwickeln können

- Googles KI-Chef warnt vor digitalen Vorurteilen

- Google-Werkzeug zeigt, wie Bildanalyse-KI Entscheidungen trifft