Kreativ-Prompts für GPT-4 helfen der KI laut Studie bei der Ideenfindung

Forscher haben in einer Studie untersucht, wie Promptmethoden zur Ideengenerierung eingesetzt werden können und welche Promptmethoden die größte Vielfalt an Ideen generieren.

Das Arbeitspapier von Lennart Meincke, Ethan Mollick und Christian Terwiesch von der Wharton School der University of Pennsylvania konzentriert sich auf die Ideengenerierung mit GPT-4.

Das Team untersuchte, wie verschiedene Promptmethoden die Vielfalt der generierten Ideen beeinflussen können. Konkret ging es darum, neue Produkte für Studierende zu entwickeln, die weniger als 50 Dollar kosten.

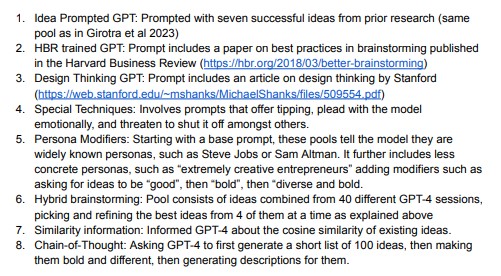

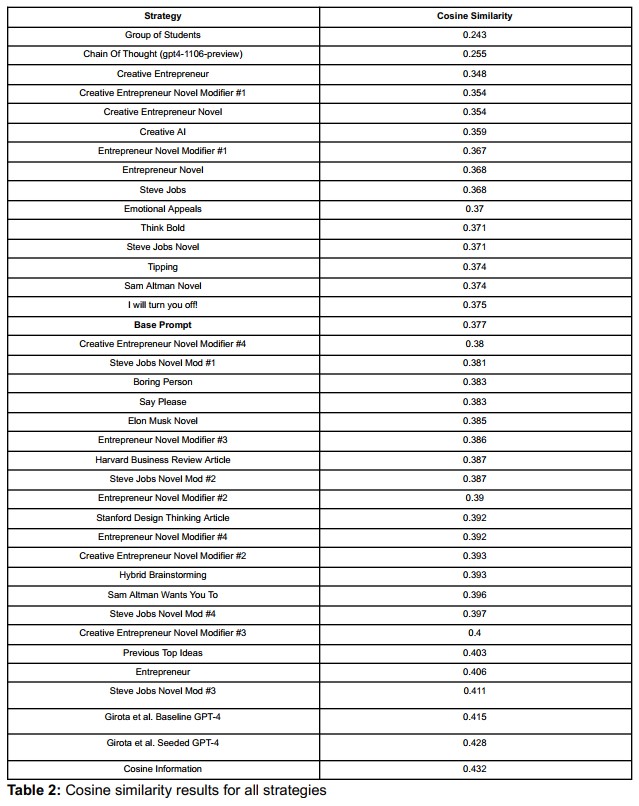

Die Forscher testeten verschiedene Promptmethoden, darunter minimale Prompts, Prompts, bei denen das KI-Modell verschiedene Persönlichkeiten annimmt, und Prompts, bei denen das KI-Modell verschiedene Kreativitätstechniken aus der bestehenden Literatur anwendet.

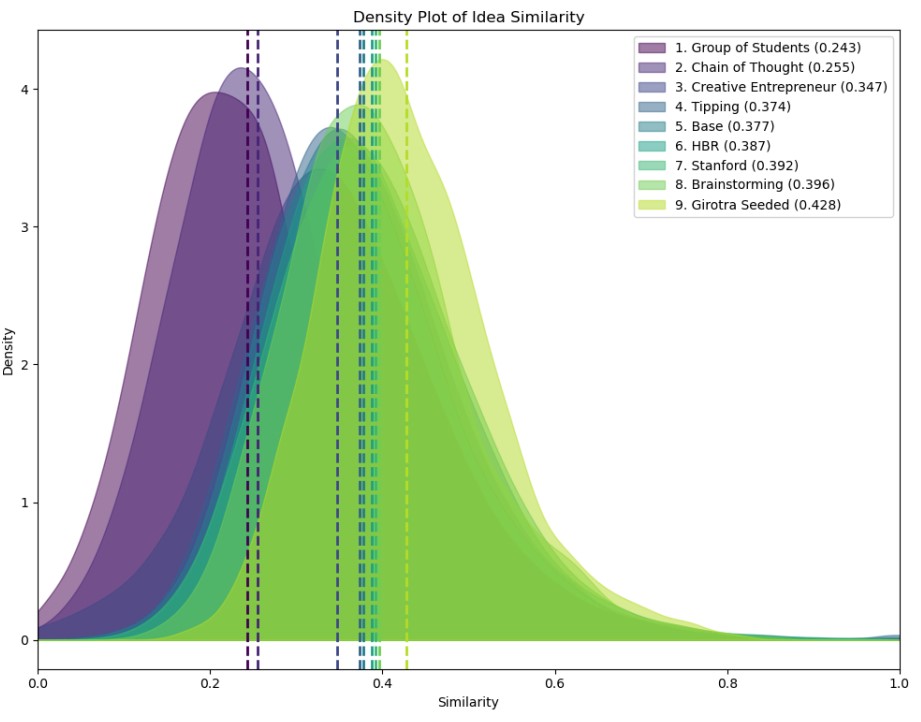

Die Vielfalt der Ideen wurde anhand der Kosinusähnlichkeit gemessen, einem Maß für die Ähnlichkeit zweier Ideen, jedoch ohne Vergleich mit bereits existierenden Ideen. Die Forscher maßen auch die Anzahl der einzigartigen Ideen und die Geschwindigkeit, mit der der Ideenraum erschöpft wurde.

Das Team stellte fest, dass verschiedene Promptmethoden unterschiedliche Auswirkungen auf die Vielfalt der generierten Ideen hatten. "Chain-of-Thought"-Prompts, eine seit längerem bekannte Prompting-Methode, die in den Tests fast das Ideenniveau einer Gruppe von Studierenden erreichte, lagen mit deutlichem Abstand an der Spitze.

Mit dieser Methode wurden auch die meisten einzigartigen Ideen generiert. Das deutet darauf hin, dass CoT-Prompting dazu beitragen kann, den Ideenraum effektiver zu erschließen und eine größere Vielfalt an möglichen Lösungen hervorzubringen.

Ohne spezielle Prompting-Methoden bleibt die KI-Kreativität jedoch hinter der menschlichen Ideenvielfalt zurück.

Schritt für Schritt zur besseren KI-Idee

Beim CoT-Prompting wird das KI-Modell aufgefordert, eine Aufgabe in mehreren Schritten zu lösen. Die einzelnen Schritte müssen dabei nicht notwendigerweise vom Menschen vorgegeben werden.

Allein die Aufforderung, schrittweise vorzugehen, kann das Ergebnis verbessern. Warum das funktioniert, ist nicht genau bekannt - die grundlegende These ist, dass die Aufforderung das Modell dazu bringt, sich auf qualitativ hochwertigere Daten aus dem Trainingsdatensatz zu konzentrieren, die analytischer sind.

In ihrem Experiment gaben die Forscherinnen und Forscher für jeden Schritt eine Aufgabe vor: Zunächst sollte GPT-4 100 Ideen generieren, aus denen die KI dann die stärksten und vielfältigsten herausfiltern sollte. Im dritten Schritt sollte GPT-4 dem Ergebnis einen Namen und eine Produktbeschreibung geben. Rund 15 Prozent der Durchläufe schlossen die Forschenden aus der Statistik aus, weil das Modell den zweiten Schritt nicht korrekt durchlaufen hatte.

Insgesamt kommen die Forscher zu dem Schluss, dass KI ein nützliches Werkzeug sein kann, um den Prozess der Ideengenerierung zu verbessern.

Sie betonen jedoch, dass die Wahl der richtigen Promptmethode entscheidend ist, um die Vielfalt der generierten Ideen zu maximieren. Die Überlappung zwischen Prompts sei "relativ gering", was hybrides Prompting erleichtere, also die Generierung kleinerer Ideenpools mit unterschiedlichen Prompting-Methoden.

Der an der Studie beteiligte Autor Ethan Mollick hat hier einen GPT für die Ideenfindung veröffentlicht, der dem Schritt-für-Schritt-Prinzip folgt. Es ist allerdings nicht der in der Studie verwendete Prompt.

Eine weitere Studie zeigte kürzlich, dass die Länge der Argumentationsschritte in CoT-Prompts in direktem Zusammenhang mit der Leistung von Sprachmodellen bei komplexen Problemlösungsaufgaben steht. Das stimmte selbst dann, wenn der längere Prompt keine wesentlichen neuen Informationen enthielt.

KI-News ohne Hype – von Menschen kuratiert

Mit dem THE‑DECODER‑Abo liest du werbefrei und wirst Teil unserer Community: Diskutiere im Kommentarsystem, erhalte unseren wöchentlichen KI‑Newsletter, 6× im Jahr den „KI Radar"‑Frontier‑Newsletter mit den neuesten Entwicklungen aus der Spitze der KI‑Forschung, bis zu 25 % Rabatt auf KI Pro‑Events und Zugriff auf das komplette Archiv der letzten zehn Jahre.

Jetzt abonnierenKI-News ohne Hype

Von Menschen kuratiert.

- Mehr als 20 Prozent Launch-Rabatt.

- Lesen ohne Ablenkung – keine Google-Werbebanner.

- Zugang zum Kommentarsystem und Austausch mit der Community.

- Wöchentlicher KI-Newsletter.

- 6× jährlich: „KI Radar“ – Deep-Dives zu den wichtigsten KI-Themen.

- Bis zu 25 % Rabatt auf KI Pro Online-Events.

- Zugang zum kompletten Archiv der letzten zehn Jahre.

- Die neuesten KI‑Infos von The Decoder – klar und auf den Punkt.