Read full article about: Rnj-1: Transformer-Pionier Vaswani stellt neues Coding-Modell vor

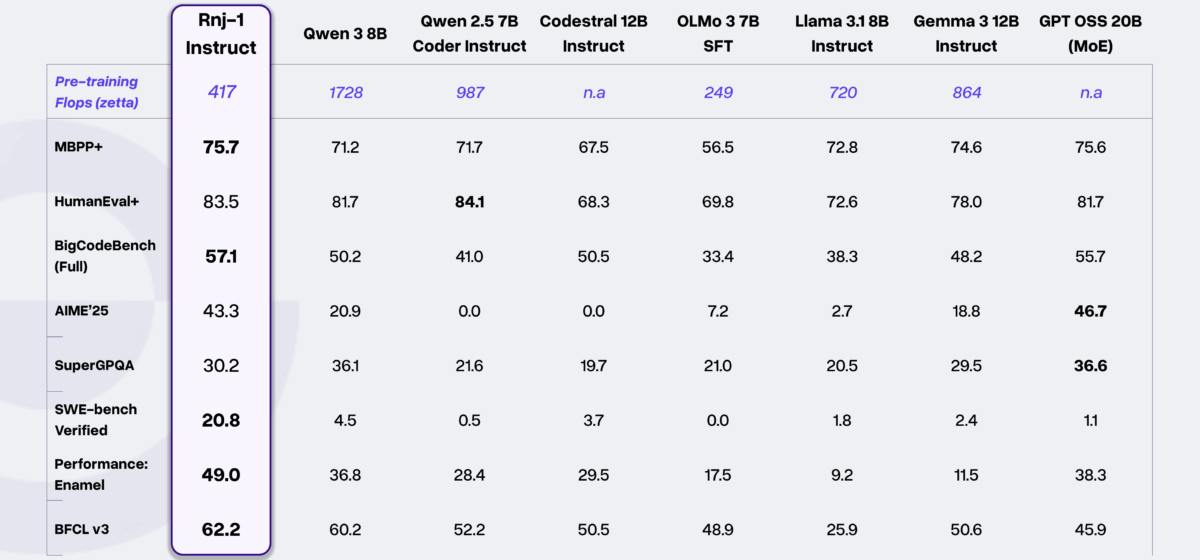

Das neue Open-Source-Modell Rnj-1 von Essential AI lässt im Test "SWE-bench Verified" deutlich größere Konkurrenz hinter sich. Dieser Benchmark gilt als besonders anspruchsvoll, da er die eigenständige Lösung echter Programmierprobleme aus der Praxis bewertet. Obwohl Rnj-1 mit acht Milliarden Parametern zu den kompakteren Modellen zählt, erreicht es hier einen Wert von 20,8 Punkten.

Ähnlich große Modelle wie Qwen 3 (ohne Reasoning, 8B) kommen im Vergleich von Essential AI nur auf 4,5 Punkte. Vorgestellt wurde das System von Ashish Vaswani, Mitgründer von Essential AI und Co-Autor des berühmten "Attention is all you need"-Paper, das die Transformer-Architektur einführte. Rnj-1 basiert ebenfalls auf einem Transformer, genauer auf der Gemma-3-Architektur. Der Fokus lag laut dem Unternehmen dabei primär auf einem besseren Pre-Training, statt auf anderen Methoden wie dem Reinforcement-Learning im Post-Training. Die Verbesserungen äußern sich auch in den vergleichsweise geringen Pre-Training-Rechenressourcen durch den verwendeten Muon-Optimizer.