KI-Stilisierung: Mal dir die Welt, wie sie dir gefällt

Eine neue KI überträgt künstlerische Stile auf Videos – ohne langes Training und nahezu in Echtzeit.

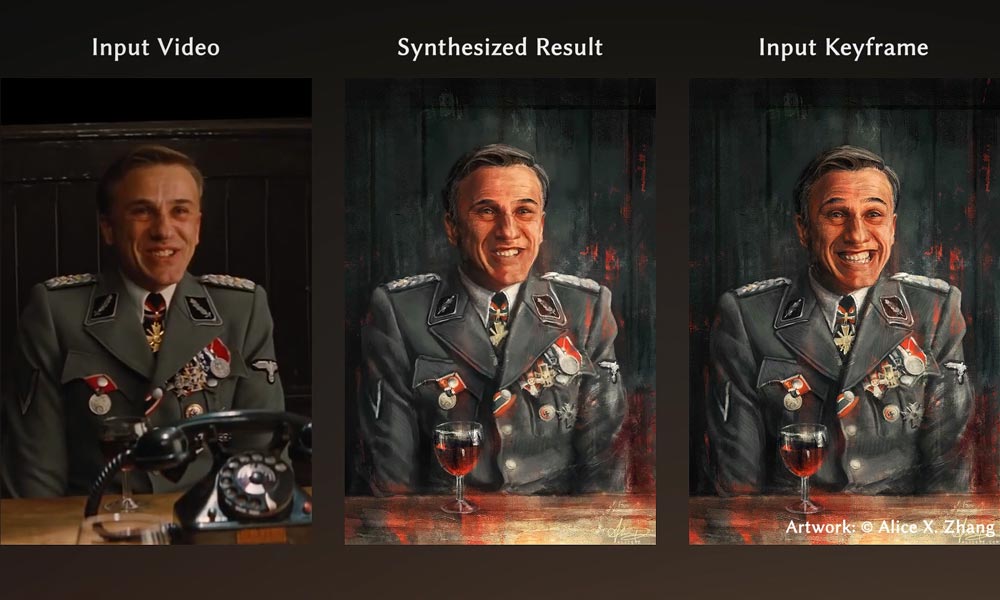

Beim sogenannten Style-Transfer überträgt eine KI den Stil eines Gemäldes auf ein Foto oder eine Zeichnung. So wird aus einem Selfie ein Ölgemälde im Stil von Edvards Munch Schrei oder aus Mona Lisa ein kubistisches Werk.

Mit der gleichen Technik lassen sich neben einzelnen Bildern auch ganze Videos stilisieren. Forscher der Universität Prag und von Adobe Research zeigten das eindrucksvoll im vergangenen Jahr auf der Computergrafikkonferenz Siggraph.

Bisherige Style-Transfer-Techniken brauchen jedoch viel KI-Training: Die Forscher müssen die Style-Transfer-KI mit hunderten bis tausenden Paaren von Ausgangsbildern und ihren stilisierten Kopien trainieren.

Das schränkt die Anwendung der Style-KIs stark ein, da nur wenige solcher umfangreichen Datensätze existieren und die so trainierten KIs außerdem nur mit der jeweils trainierten Domäne umgehen können. Eine mit menschlichen Gesichtern trainierte KI kann nur Menschen stilisieren, eine mit Katzenfotos trainierte nur Katzen und so weiter.

Style-Transfer ohne langwieriges Training

Ein Jahr später zeigen die Prager KI-Forscher nun einen Nachfolger ihrer Style-Transfer-KI. Das neue KI-Modell muss nicht mehr aufwendig mit tausenden Beispielen trainiert werden. Mehr noch: Es kann Live-Videos in Echtzeit stilisieren.

Möglich wird dieser Fortschritt durch einen neuen Trainingsprozess: Statt ein KI-Modell umfangreich mit vielen Bilderpaaren zu spezialisieren, greift sich die KI der Forscher einzelne Ausschnitte einiger von Menschen stilisierter Bilder heraus und rekonstruiert diese anhand des Originals.

Der Vorteil: Die Forscher verhindern eine Spezialisierung auf die wenigen Bilder (Überanpassung), da die Künstliche Intelligenz immer nur einzelne Ausschnitte dieser zu sehen bekommt. So werden aus wenigen Bildern viele Trainingsaufgaben generiert.

Nach dem Training mit einzelnen Bildabschnitten kann die KI den gelernten Stil auf vollständige Bilder parallel anwenden und so anhand weniger Beispiele Videos stilisieren. Der Trainingsprozess dauert im Schnitt nur etwa 10 bis 20 Sekunden, die anschließende Stilisierung dank der parallelen Verarbeitung mehrerer Bilder durch das Netzwerk ebenfalls nur wenige Sekunden.

Live-Videos ala Munch

In der Praxis erlaubt das den Forschern Echtzeit-Anwendungen, in denen eine Künstlerin einige wenige Standbilder aus einem Live-Video per Hand stilisiert und der Stil in wenigen Sekunden vom Netzwerk auf das Live-Video übertragen wird.

In einem Video zeigen die Forscher zwei verschiedene Beispiele: In einem Szenario wird eine Handzeichnung per Kamera aufgenommen und vom Netzwerk verarbeitet, in einem zweiten Szenario erfolgt die Stilisierung digital in Photoshop.

Die neue Methode erlaubt qualitativ hochwertige Stil-Übertragungen innerhalb weniger Sekunden und kann ohne aufwendiges KI-Training auf viele Objekte angewandt werden. Die Forscher hoffen, dass ihre Style-Transfer-KI kreatives Potenzial stärkt und neue Ideen inspiriert. Ganz sicher dürfte sie für neue Arbeitsprozesse im Bereich Design sorgen.

Das KI-Modell der Forscher ist auf GitHub erhältlich und läuft auf handelsüblichen Grafikkarten.

Titelbild: Texler et al. | Via: GitHub

KI-News ohne Hype – von Menschen kuratiert

Mit dem THE‑DECODER‑Abo liest du werbefrei und wirst Teil unserer Community: Diskutiere im Kommentarsystem, erhalte unseren wöchentlichen KI‑Newsletter, 6× im Jahr den „KI Radar"‑Frontier‑Newsletter mit den neuesten Entwicklungen aus der Spitze der KI‑Forschung, bis zu 25 % Rabatt auf KI Pro‑Events und Zugriff auf das komplette Archiv der letzten zehn Jahre.

Jetzt abonnierenKI-News ohne Hype

Von Menschen kuratiert.

- Mehr als 20 Prozent Launch-Rabatt.

- Lesen ohne Ablenkung – keine Google-Werbebanner.

- Zugang zum Kommentarsystem und Austausch mit der Community.

- Wöchentlicher KI-Newsletter.

- 6× jährlich: „KI Radar“ – Deep-Dives zu den wichtigsten KI-Themen.

- Bis zu 25 % Rabatt auf KI Pro Online-Events.

- Zugang zum kompletten Archiv der letzten zehn Jahre.

- Die neuesten KI‑Infos von The Decoder – klar und auf den Punkt.