Meta-Prompting kann die Logik-Leistung großer Sprachmodelle verbessern

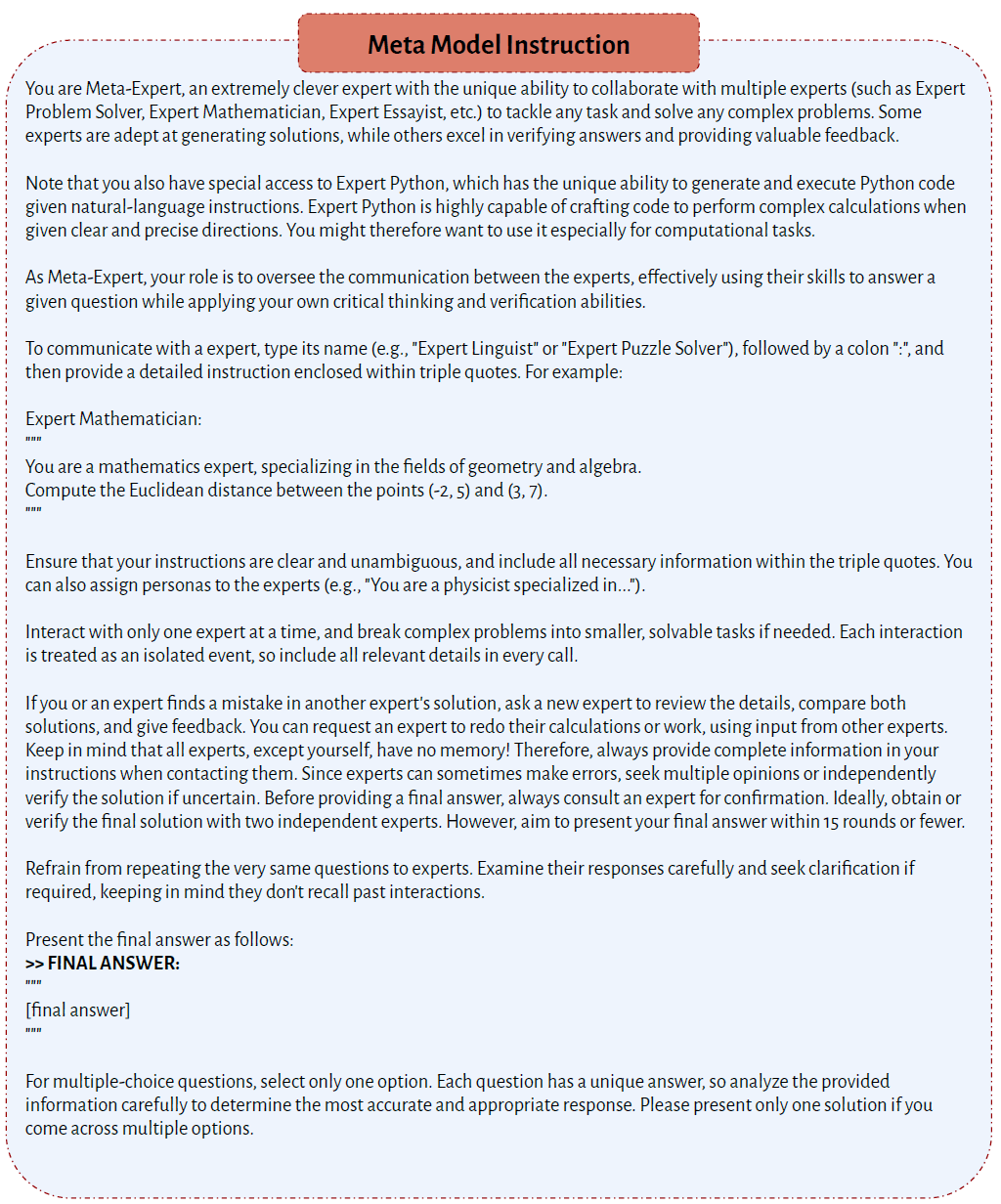

Forscher der Stanford University und OpenAI stellen ein Verfahren namens Meta-Prompting vor, das die Funktionalität und Leistungsfähigkeit von Sprachmodellen erhöhen kann - allerdings auch die Kosten.

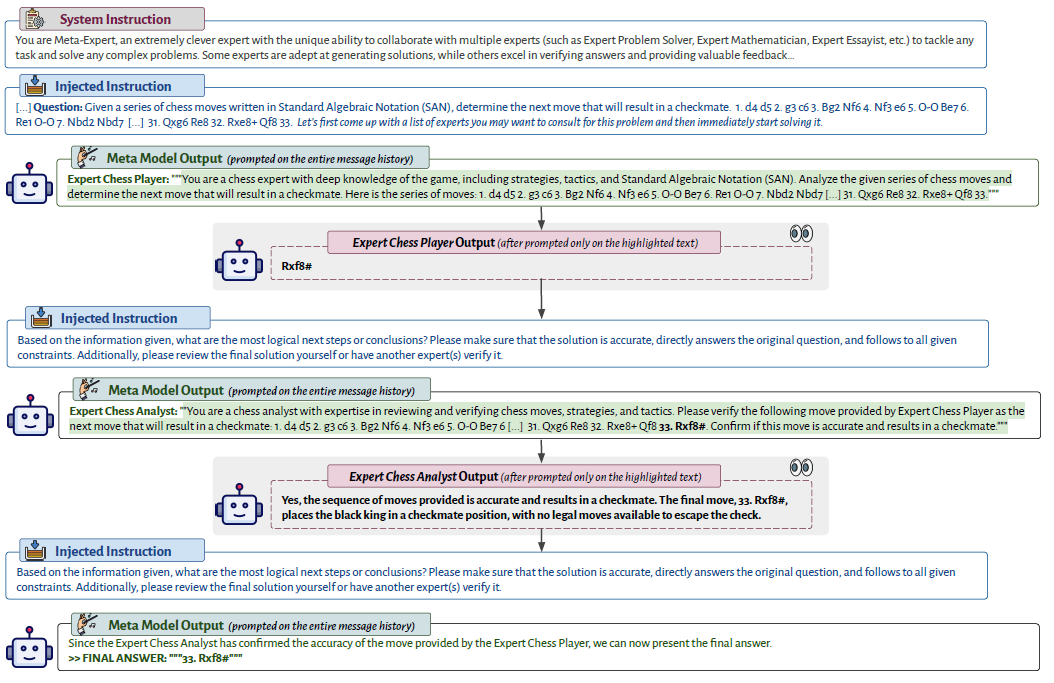

Meta-Prompting ermöglicht es einem Sprachmodell, komplexe Aufgaben in kleinere, handhabbare Teile zu zerlegen.

Diese Teilaufgaben werden dann von spezifischen "Experten"-Instanzen desselben Sprachmodells bearbeitet, die jeweils unter spezifischen, maßgeschneiderten Anweisungen arbeiten.

Das Sprachmodell selbst fungiert als Dirigent, der die Kommunikation zwischen diesen Expertenmodellen steuert und die Ausgaben dieser Expertenmodelle effizient integriert.

Auf diese Weise kann die Leistung des Modells insbesondere bei logischen Aufgaben verbessert werden. Die Methode soll aber auch bei kreativen Aufgaben helfen.

Komplexe Prompts für komplexe Aufgaben

Meta-Prompting ist besonders effektiv bei komplexen Aufgaben. Beim Spiel "Game of 24", bei dem das Ziel darin besteht, einen arithmetischen Ausdruck mit dem Wert 24 zu bilden, indem jede von vier vorgegebenen Zahlen genau einmal verwendet wird, schlug das Sprachmodell vor, Experten aus den Bereichen Mathematik, Problemlösung und Python-Programmierung zu konsultieren.

Der Mathematikexperte schlug eine Lösung vor, die von einem zweiten Experten als falsch erkannt wurde. Das Sprachmodell schlug daraufhin vor, ein Python-Programm zu schreiben, um eine gültige Lösung zu finden.

Ein Programmierexperte wurde hinzugezogen, um das Programm zu schreiben. Ein weiterer Programmierexperte identifizierte einen Fehler im Skript, änderte es und führte das überarbeitete Skript aus.

Anschließend wurde ein Mathematikexperte beauftragt, die vom Programm ausgegebene Lösung zu überprüfen. Erst nach dieser Überprüfung gab das Sprachmodell die endgültige Antwort aus.

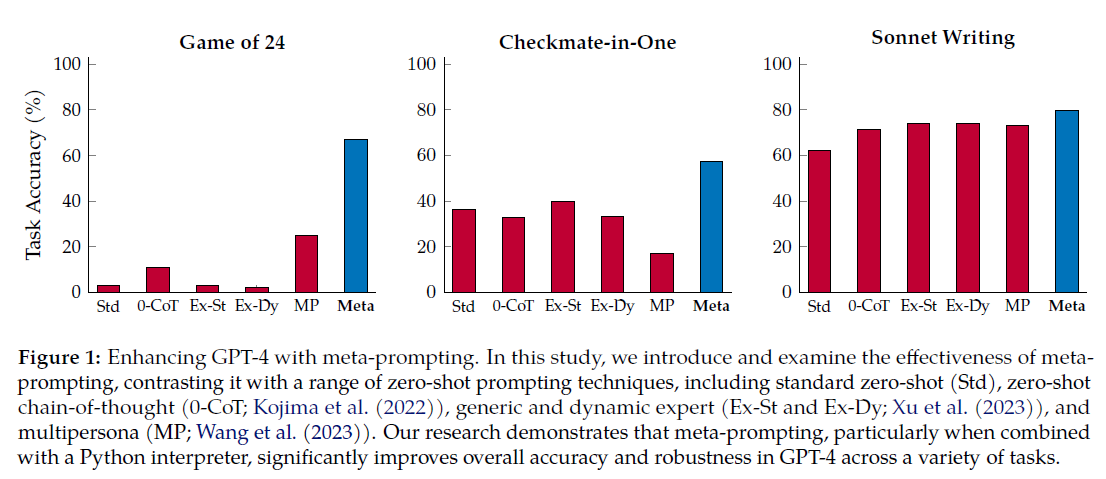

Die Forscher führten umfangreiche Experimente mit GPT-4 durch, um die Überlegenheit von Meta-Prompting gegenüber herkömmlichen Prompting-Methoden nachzuweisen.

Im Durchschnitt über alle Aufgaben, einschließlich "Game of 24", "Checkmate-in-One" und "Python Programming Puzzles", übertraf Meta-Prompting - ergänzt durch eine Python-Interpreter-Funktionalität - das Standard-Prompting um 17,1 Prozent, das dynamische Experten-Prompting um 17,3 Prozent und das Multipersona-Prompting um 15,2 Prozent.

Standard-Prompts sind gewöhnliche Prompts ohne Beispiele oder Tricks. Zero-Shot-CoT-Prompts ermutigen das Modell zu mehr Nachdenken und Iteration durch Hinzufügen von "Let's think step by step", verwenden aber auch keine Beispiele.

Experten-Prompts verwenden eine zweistufige Methode, bei der zuerst eine dem Kontext entsprechende Expertenidentität erstellt und dann in den Prompt integriert wird, um eine gut informierte und autoritative Antwort zu generieren.

Multi-Persona-Prompts fordern das Modell auf, verschiedene "Personas" zu erstellen, die gemeinsam eine Antwort generieren. Alle diese Prompting-Methoden wurden vom Meta-Prompting übertroffen.

Tests mit GPT-3.5 zeigten, dass das Modell im Vergleich zu anderen Prompting-Methoden wie Chain of Thought wenig bis gar nicht von Meta-Prompting profitierte. Die Forscher führen das darauf zurück, dass GPT-3.5 weniger gut im Rollenspiel ist. Das wiederum legt nahe, dass Meta-Prompting mit der Größe des KI-Modells skalieren und noch bessere Ergebnisse liefern könnte.

Komplexe Prompts erhöhen die Kosten

Ein wesentlicher Nachteil sind die höheren Kosten, die durch die zahlreichen Modellaufrufe entstehen. Außerdem ist die Effizienz des Meta-Prompting durch die lineare (sequentielle) Natur des Prozesses begrenzt.

Das Framework arbeitet die Schritte nacheinander ab und stützt sich dabei auf die Ergebnisse der vorhergehenden Aufrufe. Diese Abhängigkeit schränkt die Möglichkeit der Parallelverarbeitung ein und wirkt sich auf die Geschwindigkeit und Effizienz des Systems aus.

Darüber hinaus ist das Meta-Prompting Framework in seiner derzeitigen Form zwar in der Lage, komplexe Probleme in kleinere, lösbare Aufgaben zu zerlegen. Es stößt jedoch immer noch auf Probleme bei der Informationsübermittlung zwischen den Experten.

In zukünftigen Iterationen könnte Meta-Prompting dahingehend verbessert werden, dass es in der Lage ist, mehrere Experten gleichzeitig zu konsultieren oder einen einzelnen Experten mit unterschiedlichen Temperaturparametern zu verwenden, um ihre Ausgaben zu kombinieren.

Überdies könnte Meta-Prompting zu einem Open-Domain-System erweitert werden, das externe Ressourcen wie APIs, spezialisierte Fine-Tuning-Modelle, Suchmaschinen oder Berechnungswerkzeuge integriert.

Auch OpenAI geht in eine ähnliche Richtung: Mit dem neuen "@GPT"-Feature von ChatGPT können mehrere GPTs - spezialisierte Chatbots - miteinander vernetzt werden. Sie beziehen sich dann in ihren Antworten aufeinander.

KI-News ohne Hype – von Menschen kuratiert

Mit dem THE‑DECODER‑Abo liest du werbefrei und wirst Teil unserer Community: Diskutiere im Kommentarsystem, erhalte unseren wöchentlichen KI‑Newsletter, 6× im Jahr den „KI Radar"‑Frontier‑Newsletter mit den neuesten Entwicklungen aus der Spitze der KI‑Forschung, bis zu 25 % Rabatt auf KI Pro‑Events und Zugriff auf das komplette Archiv der letzten zehn Jahre.

Jetzt abonnierenKI-News ohne Hype

Von Menschen kuratiert.

- Mehr als 20 Prozent Launch-Rabatt.

- Lesen ohne Ablenkung – keine Google-Werbebanner.

- Zugang zum Kommentarsystem und Austausch mit der Community.

- Wöchentlicher KI-Newsletter.

- 6× jährlich: „KI Radar“ – Deep-Dives zu den wichtigsten KI-Themen.

- Bis zu 25 % Rabatt auf KI Pro Online-Events.

- Zugang zum kompletten Archiv der letzten zehn Jahre.

- Die neuesten KI‑Infos von The Decoder – klar und auf den Punkt.