Metas Chef-KI-Wissenschaftler Yann LeCun stellt Metas Pläne für eine Künstliche Intelligenz vor, die wie Tiere und Menschen lernen und denken soll.

Im Januar sprach Metas Chef-KI-Wissenschaftler Yann LeCun mit Podcaster Lex Fridman über den aktuellen Stand Künstlicher Intelligenz und die drei großen Herausforderungen auf dem Weg zur nächsten KI-Generation. Aktuelle KI-Systeme seien trotz vieler Milliarden Parameter immer noch weit hinter den kognitiven Fähigkeiten etwa einer Katze, so der Turing-Preisträger.

Den Grund für diesen Vorsprung biologischer Intelligenz sieht LeCun vorwiegend in ihrem hoch entwickelten Weltverständnis. Dieses Verständnis läge begründet in abstrakten Repräsentationen der Umwelt, die Mensch und Tier die Fähigkeit gebe, Modelle zu bilden, die etwa Handlungen und ihre Konsequenzen vorhersagen. Die Fähigkeit, solche Modelle der Umwelt zu lernen, sei daher zentral für die nächste KI-Generation.

LeCun konkretisiert die Architektur autonomer KI

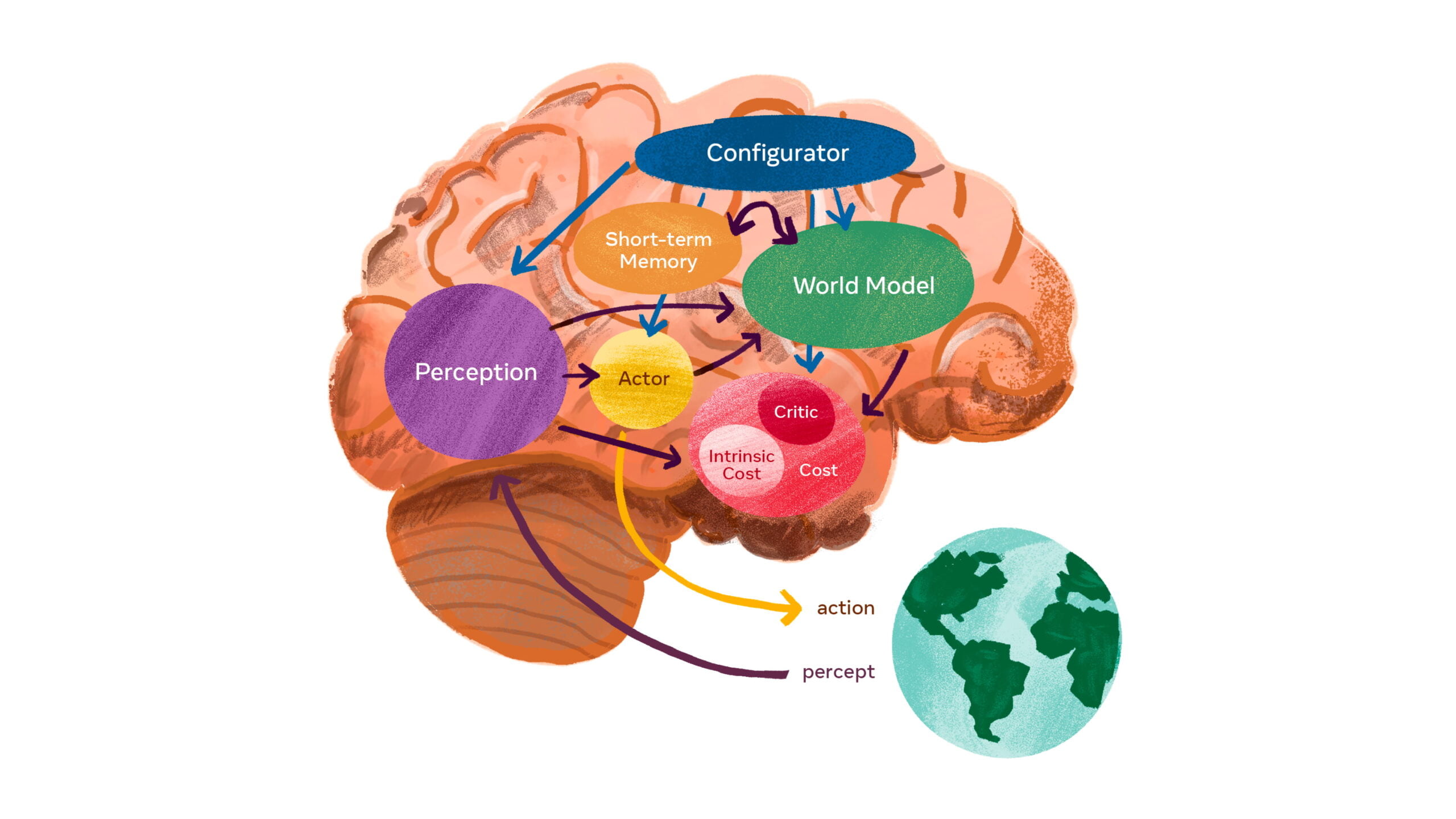

In einem Blog-Beitrag stellt Meta nun neue Details zu LeCuns Vision vor, darunter ist auch ein Einblick in eine mögliche Architektur einer "autonomen" Künstlichen Intelligenz. Diese nimmt ihre Umwelt wahr, plant entsprechend und führt Handlungen aus.

Die Architektur setzt sich aus sechs Modulen zusammen:

- Das Konfiguratormodul konfiguriert die anderen Module für die gewünschte Aufgabe. Vorstellbar sei etwa eine Anpassung der Parameter der anderen Module.

- Das Wahrnehmungsmodul verarbeitet Sensorsignale und soll so den aktuellen Zustand der Welt einschätzen. Da für bestimmte Aufgaben nur eine Teilmenge der verfügbaren Sensorinformationen relevant ist, soll das Konfiguratormodul das Wahrnehmungsmodul entsprechend auf die Extraktion der benötigten Informationen einstellen.

- Das Weltmodellmodul hat zwei Aufgaben: Es soll für die Lösung der Aufgabe notwendige Informationen über den Zustand der Welt, die die Wahrnehmung nicht liefert, bereitstellen, und plausible zukünftige Zustände der Welt vorhersagen. Das Weltmodell soll so als eine Art Simulator für die relevanten Teile der Welt dienen. Es ist der komplexeste Teil der Architektur.

- Das Kostenmodul berechnet die Kosten bestimmter geplanter Handlungen für die KI, etwa Schäden an einem Roboter, Energieverbrauch oder den Bruch festgelegter Verhaltensregeln. Das Ziel der KI ist, die Kosten möglichst gering zu halten. Laut LeCun stellt das Modul die grundlegenden Verhaltensantriebe und intrinsischen Motivationen bereit.

- Das Akteursmodul berechnet Vorschläge für Handlungen und sucht nach einer optimalen Sequenz, die die geschätzten Kosten minimiert. Am Ende steht eine optimale Handlungssequenz, die die Aufgabe erfüllt und die Kosten gering hält.

- Das Kurzzeitgedächtnismodul speichert den aktuellen und den voraussichtlichen Zustand der Welt sowie die damit verbundenen Kosten.

Jedes Modul soll mit dem gradientbasierten Lernen kompatibel sein - die Methode, die aktuelles Deep Learning ermöglicht.

Weltmodell durch Abstraktionen von Abstraktionen

Kernstück der vorgestellten Architektur ist das Weltmodellmodul, das ausgehend von den Informationen des Wahrnehmungsmoduls die Welt vorhersagen soll. Wohin bewegt sich eine wahrgenommene Person? Biegt ein Auto ab - oder fährt es weiter geradeaus?

Die echte Welt ist jedoch nur bedingt vorhersagbar. Jede Situation kann in zahlreichen Varianten verlaufen und viele wahrgenommenen Details sind für die jeweilige Aufgabe irrelevant. Ein autonomes Auto muss etwa nicht wissen, wohin sich hunderte Blätter eines Baumes bewegen, aber sehr wohl, wohin sich die umgebenden Autos bewegen.

Das Weltmodell muss daher abstrakte Repräsentationen der Welt lernen, die wichtige Details erhalten und unwichtige Details ignorieren. Dann muss es Vorhersagen auf der zur Aufgabe passenden Abstraktionsebene liefern.

LeCun schlägt vor, dass sogenannte "Joint Embedding Predictive Architectures (JEPA)" zur Lösung dieser Herausforderung beitragen können. JEPA ermögliche unüberwachtes Lernen mit großen Mengen komplexer Daten bei der gleichzeitigen Generierung abstrakter Repräsentationen.

Im Kern lernt JEPA die Abhängigkeiten zwischen zwei Eingaben, x und y, etwa einem Videoausschnitt und folgenden Bildern. Neue Lernmethoden in Kombination mit JEPA ermöglichen laut Meta das Training mit hochdimensionalen Datensätzen wie Videos.

Ein großer Vorteil von JEPA: Bei dem Verfahren können mehrere Module übereinander geschaltet werden, die so auf Grundlage der Vorhersage niedriger angesiedelter Module Vorhersagen auf einer höheren Abstraktionsebene treffen. Ein Beispiel: Das Szenario "Ein Koch bereitet Crêpes zu" kann auf mehreren Abstraktionsebenen beschrieben werden.

- Auf einer hohen Abstraktionsebene mischt der Koch Mehl, Milch, Eier, schöpft den Teig in die Pfanne, lässt den Teig braten, dreht ihn um und brät erneut.

- Auf einer niedrigeren Ebene bedeutet "schöpft den Teig in die Pfanne", dass der Koch etwas Teig schöpft und ihn in der Pfanne verteilt.

So lassen sich abstrakte Beschreibungen auf immer niedrigere Ebenen herunterbrechen, bis hin zu präzisen Handbewegungen von Millisekunde zu Millisekunde. Auf dieser niedrigen Ebene soll das Weltmodell kurzfristige Vorhersagen treffen, während es auf höherer Abstraktionsebene langfristige Vorhersagen trifft.

Weltmodell soll KI näher an menschliche Intelligenz bringen

Sollte der hierarchische JEPA-Aufbau ein ausreichend umfassendes Weltmodell ermöglichen, könne das einem KI-Agenten helfen, komplexe Handlungen hierarchisch zu planen, in dem er komplexe Aufgaben in weniger komplexe und abstrakte Teilaufgaben zerlegt. Auf der niedrigsten Ebene könnten diese Handlungen dann etwa die Effektoren eines Roboters ansteuern.

LeCuns übergeordnete Vision lässt viele Fragen offen, etwa Details zur Architektur und Trainingsmethode des Weltmodells. Meta bezeichnet das Training des Weltmodells daher auch als die wesentliche Herausforderung für echte Fortschritte in der KI-Forschung der nächsten Jahrzehnte. Auch andere Aspekte der Architektur müssten noch genauer definiert werden, so Meta.

Die Entwicklung von Maschinen, die so effizient wie Menschen lernen und verstehen, sei ein langfristiges wissenschaftliches Unterfangen ohne Erfolgsgarantie. Die hier vorgestellte Grundlagenforschung werde jedoch weiter zu einem tieferen Verständnis von Geist und Maschine und zu KI-Fortschritten führen, die Künstlicher Intelligenz und damit dem Menschen zugutekämen.