Nvidia zeigt neue Demo für KI-generierte Videospiele

Nvidia forscht weiter an KI-generierten Videospielen. Eine neue KI kann Videos und 3D-Welten texturieren – und sich danach auch noch daran erinnern.

Im September 2018 veröffentlichte Nvidia in Kooperation mit dem Massachusetts Institute of Technology (MIT) eine Künstliche Intelligenz, die die sogenannte Video-zu-Video-Synthese beherrscht.

Solche KIs können bestimmte Inhalte oder Bewegungsmuster eines Videos ändern oder auf ein anderes Video übertragen. Das Prinzip erinnert an die weit verbreiteten Deepfakes, die Technik kann aber mehr: Nvidias KI tauscht Straßenbeläge, Häuserschluchten, Bäume oder Wetter aus. Oder sie lässt eine Statue tanzen.

Blick in die Vergangenheit

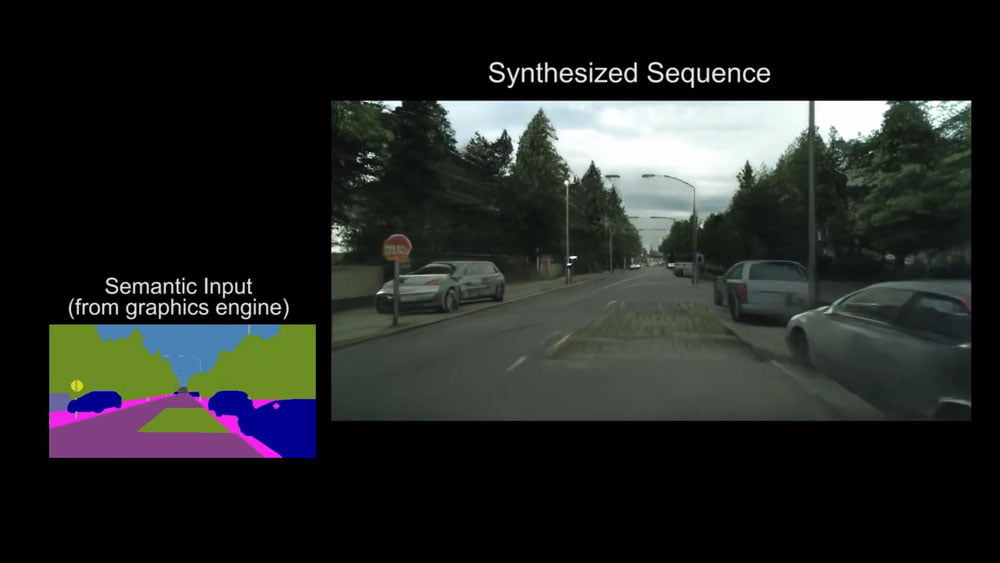

Mit Video-zu-Video-Synthese sollen KIs langfristig in der Lage sein, ausgehend von ausreichend Informationen über den Inhalt einer Szene, ein fotorealistisches Video oder eine 3D-Welt zu generieren.

Dafür erstellen die Forscher zuerst eine sogenannte semantische Maske, mit der Objekte wie Häuser, Bäume oder Autos im Ausgangsmaterial klassifiziert werden. Die KI liest diese Informationen aus und generiert passende Oberflächen und Farben.

Das Ergebnis ist interessant, aber fehlerhaft: Fehlende Details, geometrische Artefakte oder zeitliche Ungereimtheiten wie ein Auto, das seine Farbe ändert. Viele dieser Fehler treten auf, da die KI vergesslich ist: Sie vergisst Autofarben, Gesichter oder Häuserfronten. Bei Objekten, die ununterbrochen im Fokus des Videos stehen oder mehrfach vorkommen, ist das ein Problem.

Konsistente Welt, glaubwürdige Videos?

Nvidia hat jetzt eine neue Variante der Video-KI veröffentlicht. In einer wissenschaftlichen Arbeit mit dem Titel „World-Consistent Video-to-Video Synthesis“ zeigen die Nvidia-Forscher beeindruckende Ergebnisse.

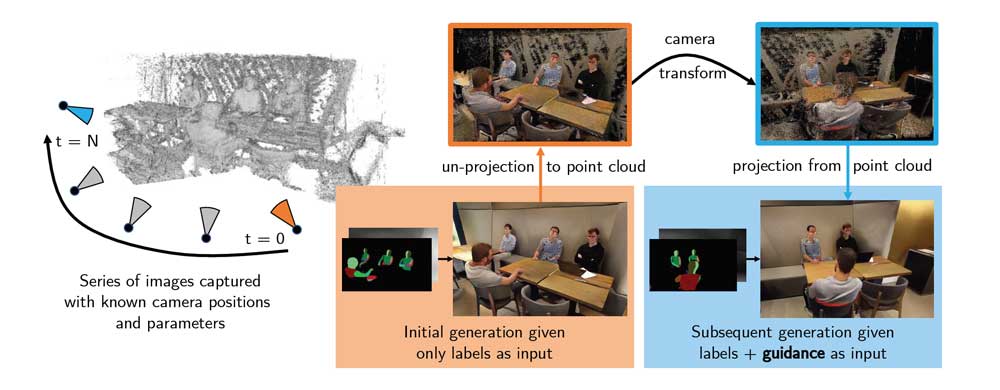

Das bisherige Problem sei, dass der KI „das Wissen über die dreidimensionale Welt fehlt, die gerendert wird, und sie jedes Bild nur auf Basis des letzten Bildes generiert“, schreiben die Forscher.

In einem Beispiel zeigen sie ein Auto, das zweimal die gleiche Stelle passiert und jedes Mal unterschiedlichen Straßenschildern oder Mittelstreifensituationen begegnet.

Nvidia führt daher die Idee sogenannter Leitbilder ein, die die Texturierung des jeweils nächsten Bildes beeinflussen. Das Ziel der Leitbilder ist es, für konsistente Farben und Oberflächen im Video zu sorgen.

Dafür enthalten sie Tiefen- und Inhaltsinformationen aller bisher bekannten Bilder. Für das nächste generierte Bild dienen die Informationen des Leitbildes dann als Anhaltspunkt für Farben und Oberflächen.

Leitbilder helfen Konsistenz

Nvidias neue KI erzielt im direkten Vergleich zur Vorgängerin wesentlich konsistentere Ergebnisse. Die Variation in Farben und Oberflächen in den Testvideos ist zwar noch auffällig, aber viel näher an der erhofften Gleichmäßigkeit.

Oben die neue, unten die alte Methode. | Bild: Nvidia

Als Trainingsmaterial nutzten die Nvidia-Forscher Straßenaufnahmen, Videos von Innenräumen und Videos der Mannequin Challenge, bei der Menschen wie Puppen stillhalten. Die KI schafft es, Details wie Gesichter und Farben relativ stabil zu halten.

Forscher wollen die Technik in Videospielen testen

Der neue Ansatz sei mit einiger Verbesserung tauglich für den Einsatz in Videospielen, so die Forscher. Dort könnte die KI etwa ganze Welten realistisch in Echtzeit texturieren. Bereits Ende 2018 demonstrierte Nvidia dieses Vorhaben mit einem KI-generierten Straßenzug.

In einer Testfahrt durch einen Unreal-Engine-Straßenzug zeigt die neue KI dann auch klare Verbesserungen gegenüber ihrer Vorgängerin: Auch nach einer Umrundung bleiben die Details dieselben.

Via: GitHub NVlabs

KI-News ohne Hype – von Menschen kuratiert

Mit dem THE‑DECODER‑Abo liest du werbefrei und wirst Teil unserer Community: Diskutiere im Kommentarsystem, erhalte unseren wöchentlichen KI‑Newsletter, 6× im Jahr den „KI Radar"‑Frontier‑Newsletter mit den neuesten Entwicklungen aus der Spitze der KI‑Forschung, bis zu 25 % Rabatt auf KI Pro‑Events und Zugriff auf das komplette Archiv der letzten zehn Jahre.

Jetzt abonnierenKI-News ohne Hype

Von Menschen kuratiert.

- Mehr als 20 Prozent Launch-Rabatt.

- Lesen ohne Ablenkung – keine Google-Werbebanner.

- Zugang zum Kommentarsystem und Austausch mit der Community.

- Wöchentlicher KI-Newsletter.

- 6× jährlich: „KI Radar“ – Deep-Dives zu den wichtigsten KI-Themen.

- Bis zu 25 % Rabatt auf KI Pro Online-Events.

- Zugang zum kompletten Archiv der letzten zehn Jahre.

- Die neuesten KI‑Infos von The Decoder – klar und auf den Punkt.