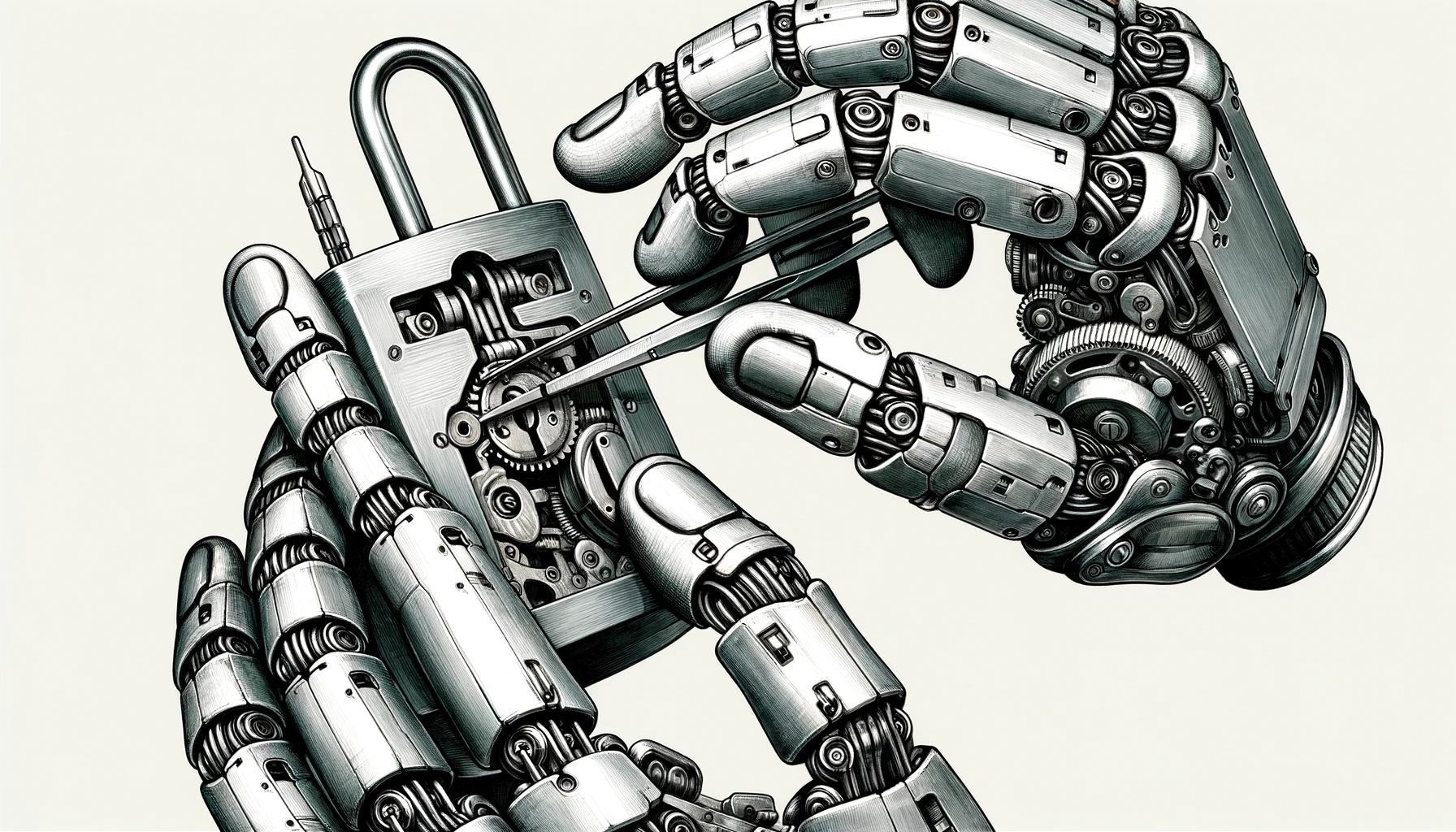

OpenAI arbeitet mit US-Militär an Cybersecurity-Projekten

OpenAI arbeitet mit dem Pentagon an verschiedenen Projekten zusammen, unter anderem an der Entwicklung von Open-Source-Software für Cybersicherheit.

OpenAI hat vor ein paar Tagen den Passus aus seinen Nutzungsbedingungen entfernt, der die Nutzung seiner KI für "militärische und kriegerische" Anwendungen untersagte.

Anna Makanju, Vizepräsidentin für globale Angelegenheiten bei OpenAI, sagt nun gegenüber Bloomberg, dass diese Entscheidung Teil einer umfassenderen Aktualisierung der Richtlinien sei, um neue Anwendungen von ChatGPT und anderen Tools zu berücksichtigen.

Laut Makanju gibt es erste Gespräche mit der US-Regierung über Methoden zur Suizidprävention bei Kriegsveteranen, also den Einsatz von ChatGPT in einem therapeutischen Kontext, und OpenAI arbeite mit dem US-Verteidigungsministerium an einer Open-Source-Cybersicherheitssoftware.

Cybersecurity, Medizin oder Therapie, auch im militärischen Kontext, entsprechen den neuen Richtlinien von OpenAI, die eine explizite militärische Nutzung nicht mehr ausschließen, wohl aber den Einsatz von KI, um anderen Menschen zu schaden oder Waffen zu entwickeln.

"Da wir vorher ein generelles Verbot für militärische Zwecke hatten, dachten viele, dass dies viele dieser Anwendungsfälle verbieten würde, die nach Meinung der Menschen sehr gut zu dem passen, was wir in der Welt sehen wollen", sagt Makanju.

OpenAI adressiert gesellschaftliche Themen

OpenAI hat vor Kurzem auch neue Initiativen vorgestellt, um den böswilligen Einsatz von KI im Zusammenhang mit Wahlen zu bekämpfen, einschließlich eines Bildidentifikators für das KI-Tool DALL-E 3.

Eine weitere Maßnahme betrifft die Demokratisierung von KI-Modellen, um ein breiteres politisches Spektrum abzubilden. Auch hierfür hat OpenAI ein neues Team gegründet, das Systeme zur Erfassung öffentlicher Meinungen und deren Übertragung in die KI-Modelle von OpenAI erstellen soll.

KI-News ohne Hype – von Menschen kuratiert

Mit dem THE‑DECODER‑Abo liest du werbefrei und wirst Teil unserer Community: Diskutiere im Kommentarsystem, erhalte unseren wöchentlichen KI‑Newsletter, 6× im Jahr den „KI Radar"‑Frontier‑Newsletter mit den neuesten Entwicklungen aus der Spitze der KI‑Forschung, bis zu 25 % Rabatt auf KI Pro‑Events und Zugriff auf das komplette Archiv der letzten zehn Jahre.

Jetzt abonnierenKI-News ohne Hype

Von Menschen kuratiert.

- Mehr als 20 Prozent Launch-Rabatt.

- Lesen ohne Ablenkung – keine Google-Werbebanner.

- Zugang zum Kommentarsystem und Austausch mit der Community.

- Wöchentlicher KI-Newsletter.

- 6× jährlich: „KI Radar“ – Deep-Dives zu den wichtigsten KI-Themen.

- Bis zu 25 % Rabatt auf KI Pro Online-Events.

- Zugang zum kompletten Archiv der letzten zehn Jahre.

- Die neuesten KI‑Infos von The Decoder – klar und auf den Punkt.