OpenAI-CTO dämpft Erwartungen an radikal verbesserte KI-Modelle in naher Zukunft

Laut Mira Murati, Chief Technology Officer von OpenAI, sind die internen KI-Modelle des Unternehmens technisch nicht weit von den öffentlich zugänglichen Systemen entfernt. Das lässt darauf schließen, dass zeitnah keine großen Leistungssprünge bei den öffentlichen Modellen zu erwarten sind.

Immer wieder kursieren Spekulationen, dass OpenAI hinter verschlossenen Türen bereits weit fortgeschrittene KI-Modelle entwickelt und gar mit Regierungen über deren Sicherheit diskutiert. CTO Mira Murati dämpft diese Erwartungen.

In einem Interview stellt OpenAIS CTO klar, dass die KI-Systeme in den Forschungslabors von OpenAI derzeit nicht wesentlich leistungsfähiger sind als die öffentlich verfügbaren Modelle. Es gebe keinen großen technologischen Vorsprung.

Murati sagt das vor dem Hintergrund der KI-Sicherheitsstrategie von OpenAI, die vorsieht, die Öffentlichkeit an der Entwicklung von KI-Systemen zu beteiligen. Das würde den Menschen ein intuitives Verständnis für die Möglichkeiten und Risiken der Technologie vermitteln und sie in die Lage versetzen, sich auf die Einführung fortschrittlicher KI vorzubereiten.

Diese Situation sei im Vergleich zu früheren technologischen Entwicklungen einzigartig: "In den Labors haben wir diese leistungsfähigen Modelle und wissen, dass sie nicht weit von dem entfernt sind, was die Öffentlichkeit kostenlos nutzen kann", sagt Murati in einem Interview mit Fortune. Das sei eine gänzlich andere Entwicklung als bei früheren Technologien.

Die Aussage impliziert auch, dass ein signifikanter Leistungssprung der öffentlich verfügbaren KI-Modelle von OpenAI bald nicht zu erwarten ist. Denn wenn die internen Systeme kaum besser sind, ist es unwahrscheinlich, dass in den nächsten Monaten dramatisch verbesserte Modelle veröffentlicht werden.

Der Prozess von der Entwicklung eines neuen Modells bis zu seiner Markteinführung ist langwierig. Die Feinabstimmung und die umfangreichen Sicherheitstests nehmen in der Regel viele Monate in Anspruch. Es ist daher unwahrscheinlich, dass OpenAI zeitnah deutlich leistungsfähigere Systeme veröffentlichen kann, wenn diese intern bisher nicht existieren oder noch im Training sind.

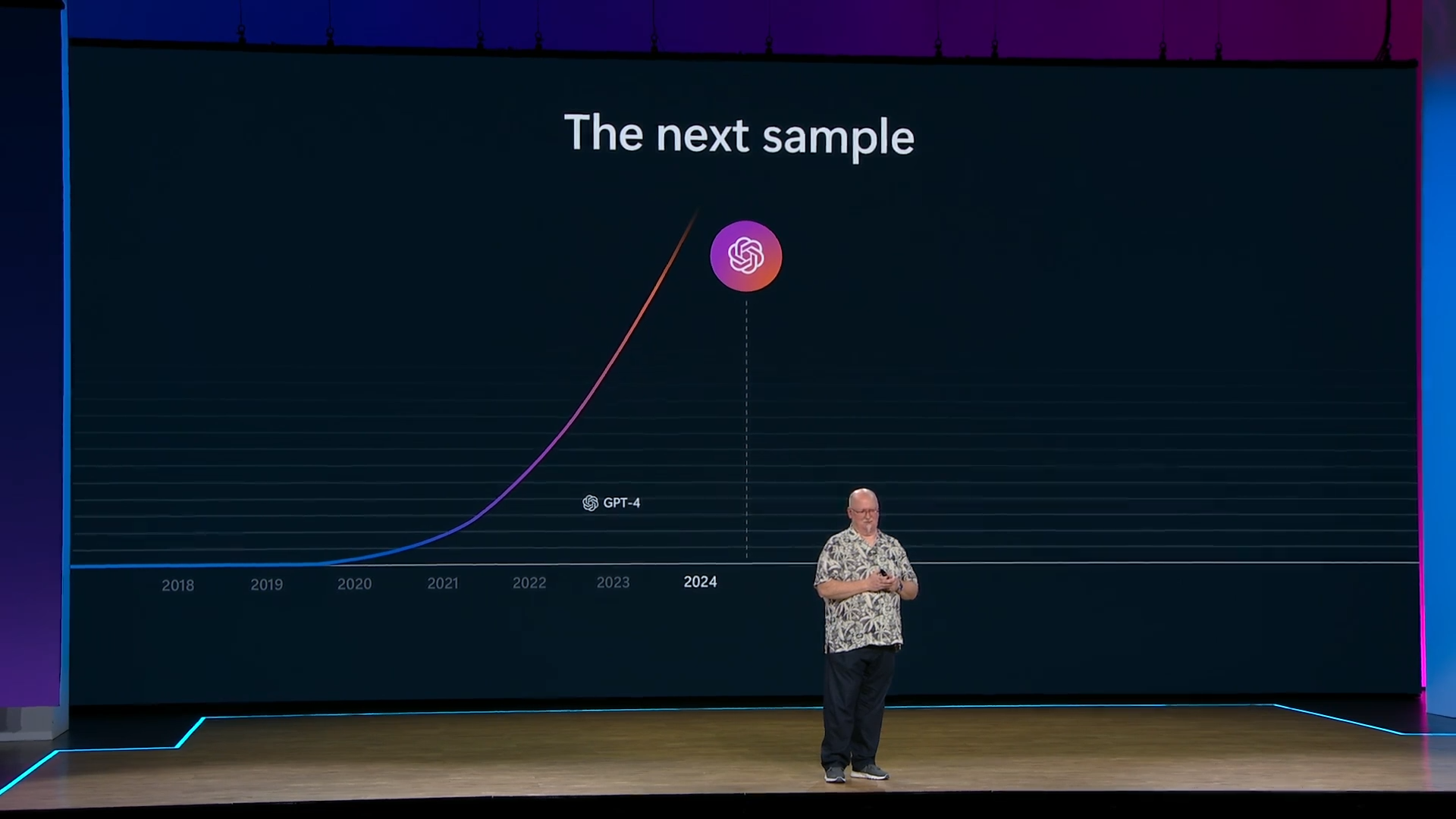

LLM-Kritiker wie Gary Marcus sehen darin eine Bestätigung ihrer These, dass die Skalierung dieser Art von KI-Technologie bereits ein Plateau erreicht hat. Marcus wirft OpenAI vor, nur zu bluffen. Auch Microsoft-Gründer Bill Gates sagte, er erwarte einen geringeren Sprung von GPT-4 zu GPT-5 als von GPT-2 zu GPT-4.

Demgegenüber stehen der CEO von OpenAI, Sam Altman, oder jüngst der CTO von Microsoft, Kevin Scott, die weiterhin große Entwicklungssprünge in Aussicht stellen - im Falle von Scott sogar noch für dieses Jahr.

Tatsache ist, dass es seit der Veröffentlichung von GPT-4 keine wesentlichen Fortschritte bei den Grundfähigkeiten von LLMs, insbesondere im Bereich der Logik, gegeben hat.

Ein Leistungssprung allein durch Skalierung könnte durch Multimodalität erreicht werden - KI-Modelle lernen und verknüpfen Wissen aus vielen verschiedenen Daten statt nur aus Text, vor allem Video. OpenAIs neues Modell GPT-4 omni ist dafür ein Beispiel. Aber auch hier gibt es keinen wissenschaftlichen Konsens.

KI-News ohne Hype – von Menschen kuratiert

Mit dem THE‑DECODER‑Abo liest du werbefrei und wirst Teil unserer Community: Diskutiere im Kommentarsystem, erhalte unseren wöchentlichen KI‑Newsletter, 6× im Jahr den „KI Radar"‑Frontier‑Newsletter mit den neuesten Entwicklungen aus der Spitze der KI‑Forschung, bis zu 25 % Rabatt auf KI Pro‑Events und Zugriff auf das komplette Archiv der letzten zehn Jahre.

Jetzt abonnierenKI-News ohne Hype

Von Menschen kuratiert.

- Mehr als 20 Prozent Launch-Rabatt.

- Lesen ohne Ablenkung – keine Google-Werbebanner.

- Zugang zum Kommentarsystem und Austausch mit der Community.

- Wöchentlicher KI-Newsletter.

- 6× jährlich: „KI Radar“ – Deep-Dives zu den wichtigsten KI-Themen.

- Bis zu 25 % Rabatt auf KI Pro Online-Events.

- Zugang zum kompletten Archiv der letzten zehn Jahre.

- Die neuesten KI‑Infos von The Decoder – klar und auf den Punkt.