Ab sofort können ChatGPT-Plus-Abonnenten in drei Stunden bis zu 50 Nachrichten an GPT-4 senden. Nach der Einführung des neuen Modells im März war die Anzahl aus Rechen- und Kostengründen auf 25 Nachrichten in zwei Stunden begrenzt.

Die Erhöhung der Nachrichtenanzahl könnte mit der kürzlich eingeführten GPT-4 Version "0613" zusammenhängen, die ein effizienteres Modell sein könnte, aber möglicherweise auch Qualitätseinbußen mit sich bringt (siehe unten).

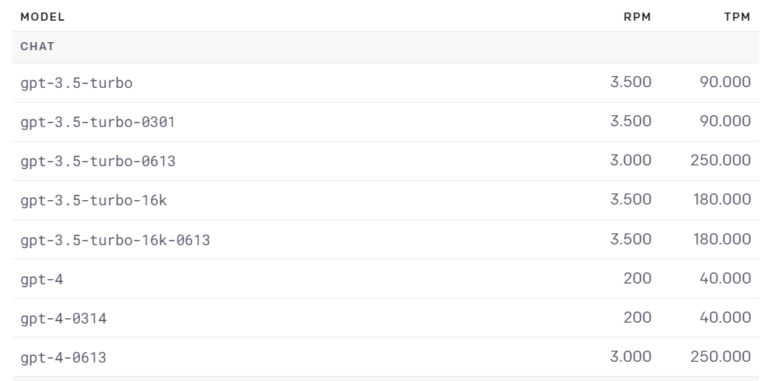

Auffallend im Vergleich zum März-Modell "0314" ist die deutlich höhere Schreibgeschwindigkeit des neuen Modells. Das war auch bei der Umstellung von GPT-3 auf GPT-3.5 der Fall. Bei der gab es allerdings keine Qualitätseinbußen. Das neue GPT-4-Modell "0613" kann deutlich mehr RPM (requests per minute) und TPM (tokens per minute) verarbeiten.

GPT-4 bietet mehr Volumen und wird schneller - auf Kosten der Qualität?

Bei unseren Tests über die API folgt die neue Version GPT-4 unseren für das März-Release erstellten Prompt-Templates weniger zuverlässig und detailliert und neigt eher zu inhaltlichen Fehlern.

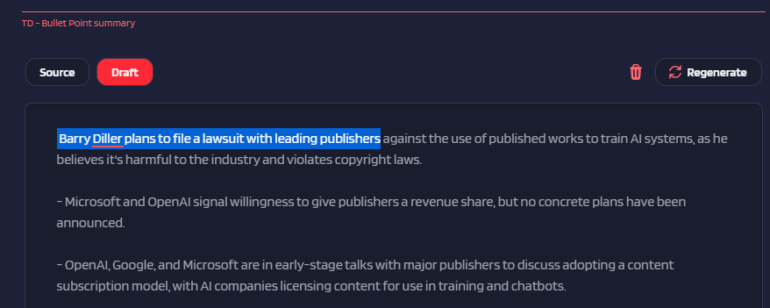

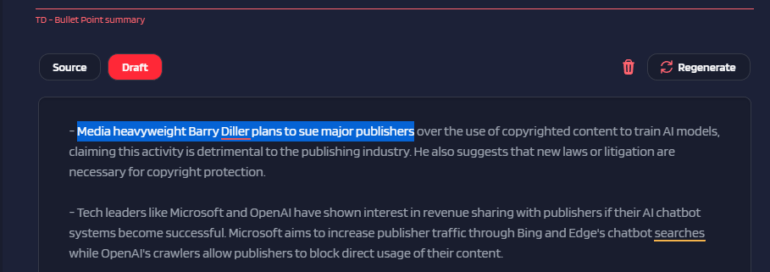

Wir generieren etwa die Artikelzusammenfassungen unter den Artikeln teilweise mit GPT-4. In der Zusammenfassung dieser Meldung zu den Klageplänen von Barry Diller erfasst das alte GPT-4-Modell korrekt, dass Diller gemeinsam mit Verlagen Konzerne verklagen will.

Die neue Version von GPT-4 hingegen behauptet, Diller wolle die Verlage verklagen. Dieser Fehler konnte bei mehreren Neugenerierungen mit demselben Prompt reproduziert werden. Die alte Version liegt stets richtig, die neue stets falsch.

Dies ist natürlich nur eine Einzelbeobachtung. Eine systematischere Untersuchung deutet jedoch ebenso darauf hin, dass ChatGPT mit GPT-3.5 und GPT-4 seit März an Qualität verloren hat. Letztlich ist dies aber nicht abschließend erwiesen und mögliche Gründe sind nicht bekannt.

Die Kritik an der angeblich sinkenden Qualität des Modells wird seit einigen Wochen vor allem von Vielnutzern in den sozialen Medien und auf Reddit geäußert. OpenAI hat bisher immer darauf hingewiesen, dass es keine Verschlechterung der Qualität gibt, sondern im Gegenteil sogar Verbesserungen. Die teilweise zitierten Beispiele seien möglicherweise Bugs. Nach der Veröffentlichung der oben genannten Studie möchte OpenAI nun den Beispielen und einer möglichen Qualitätsverschlechterung nachgehen.

LLMs müssen verlässlich sein, um im Arbeitsalltag anzukommen

Unabhängig davon, ob sich die Kritik an einer möglicherweise schlechten Performance bewahrheitet, ist OpenAI gut beraten, die Verlässlichkeit seines Modells auch über Modellwechsel hinweg sicherzustellen. Gerade bei Geschäftskunden, die Dienste weiterverkaufen, können Qualitätsschwankungen im Alltag das Geschäftsmodell gefährden.

Dabei muss es sich nicht einmal um eine Verschlechterung des Modells handeln, es reicht etwa eine Abweichung in der Prompt-Kompatibilität. Da das Verständnis über die genaue Funktionsweise der Modelle noch gering ist, steht OpenAI hier vor einer anspruchsvollen Aufgabe, die mit wachsender Kundenbasis nur noch anspruchsvoller wird.