Große Sprachmodelle allein werden wahrscheinlich nicht zu AGI führen, sagt Sam Altman. Die Lösung zu finden, sei die nächste Aufgabe von OpenAI.

Der CEO und Mitbegründer von OpenAI hielt einen Vortrag und beantwortete Fragen im Rahmen des 2023 Hawking Fellowship Award, den er im Namen des Teams entgegennahm. Die Studierenden aus Cambridge fragten unter anderem nach der Rolle von Open Source, KI-Sicherheit, Bewusstsein und schließlich nach der Rolle der Skalierung auf dem Weg zu einer künstlichen allgemeinen Intelligenz (AGI).

Auf die Frage, ob eine weitere Skalierung von großen Sprachmodellen zu AGI führen würde, antwortete Altman, dass die Modelle zwar große Fortschritte gemacht hätten und er noch viel Potenzial sehe, dass aber sehr wahrscheinlich ein weiterer Durchbruch notwendig sei. GPT-4 habe zwar beeindruckende Fähigkeiten, aber auch Schwächen, die deutlich machten, dass AGI noch nicht erreicht sei.

"Ich denke, wir brauchen einen weiteren Durchbruch. Wir können die großen Sprachmodelle sehr stark vorantreiben, und das sollten und werden wir auch tun. Wir können den Hügel, auf dem wir uns jetzt befinden, weiter erklimmen, und der Gipfel ist noch ziemlich weit entfernt. Aber wenn man es ganz weit treibt, kommen vielleicht all diese anderen Dinge zum Vorschein. Aber ich glaube nicht, dass das etwas bringt, was ich für die allgemeine Intelligenz für entscheidend halte", sagte Altman.

Er verdeutlichte seine Position am Beispiel der Physik: "Wenn eine Superintelligenz keine neue Physik entdecken kann, dann glaube ich nicht, dass sie eine Superintelligenz ist. Ich glaube nicht, dass man dieses Ziel erreichen kann, indem man auf der Basis von Daten, die man kennt, trainiert und lernt, menschliches Verhalten und menschlichen Text zu klonen. Es stellt sich also die Frage, die in diesem Bereich schon lange diskutiert wird: Was müssen wir zusätzlich zu einem Sprachmodell tun, um ein System zu schaffen, das neue physikalische Phänomene entdecken kann? Und das wird unsere nächste Aufgabe sein.

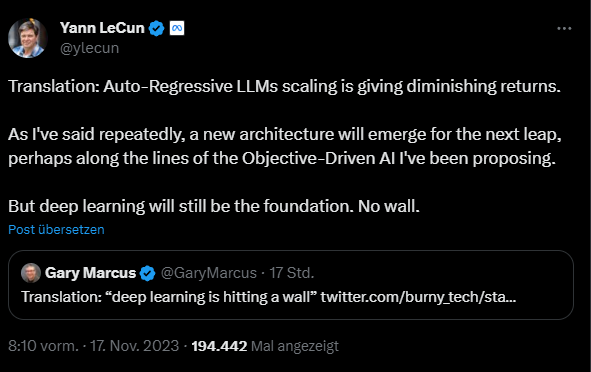

Der Deep-Learning-Kritiker Gary Marcus übersetzte Altmans Aussage mit "Deep Learning stößt an Grenzen". Laut Marcus könnten Netzwerke zwar vereinzelt verallgemeinern, aber niemals zuverlässig. Metas KI-Chef Yann LeCun sieht sich dagegen in seiner Position bestätigt, dass große Sprachmodelle nicht die Lösung sind. Er setzt weiter auf Deep Learning - allerdings mit anderen Architekturen und Trainingszielen wie bei JEPA.

Altman: "In der Theorie ist Sicherheit einfach"

Auf die Frage nach der Rolle von Open Source sprach sich Altman grundsätzlich für Open-Source-Modelle aus, warnte jedoch vor den möglichen Risiken, wenn jedes Modell ohne gründliche Tests und Kenntnisse offen zugänglich gemacht werde.

"Ich glaube, dass Open Source gut und wichtig ist", sagte Altman, "aber ich glaube auch, dass Vorsicht wirklich gut ist, und obwohl ich [die Meinung anderer respektiere], bin ich auch respektvoll anderer Meinung, dass wir einfach jedes Modell, das wir entwickeln, sofort Open Source machen sollten."

Das Thema Sicherheit wurde in Altmans Vortrag und in den Fragen ebenfalls angesprochen. Er betonte erneut, wie wichtig es sei, KI sicher und im Einklang mit menschlichen Werten zu entwickeln und erläuterte den Ansatz von OpenAI, der auf Tests, externe Experten, Sicherheitsüberwachungssysteme und -tools sowie Best Practices setzt.

"In der Theorie ist Sicherheit einfach. Die Schwierigkeit besteht darin, ein System zu schaffen, das für Hunderte von Millionen Menschen wirklich nützlich und sicher ist", sagte Altman. "Man kann diese Arbeit nicht nur in der Theorie machen, man muss sie in Kontakt mit der Realität machen".

Er sprach auch über die Bedeutung globaler Zusammenarbeit bei der Regulierung von KI und schlug vor, dass in Zukunft eine globale Regulierungsbehörde notwendig sein könnte, ähnlich der Regulierungsbehörde für Atomenergie.