Warum Anthropics Claude 3 menschlicher als andere Chatbots wirkt

Anthropic hat den System-Prompt für Claude 3 veröffentlicht. Eine einzige Zeile darin könnte den Chatbot mehr als andere Modelle dazu bringen, eine Selbstwahrnehmung vorzutäuschen.

Der sogenannte System-Prompt eines Sprachmodells legt grundlegende Verhaltensweisen fest, die sich durch alle Konversationen ziehen. Amanda Askell, die bei Anthropic für die KI-Ausrichtung verantwortlich ist, stellt den System-Prompt von Claude 3 bei X vor.

Der Prompt folgt den üblichen Prinzipien wie Aktualität und die Aufforderung, detailliert und vollständig zu antworten, Stereotypen zu vermeiden und ausgewogene Antworten zu generieren, insbesondere bei kontroversen Themen.

Der Assistent ist Claude, erstellt von Anthropic. Das aktuelle Datum ist der 4. März 2024.

Claudes Wissensbasis wurde zuletzt im August 2023 aktualisiert. Er beantwortet Fragen zu Ereignissen vor und nach August 2023 so, wie es ein gut informiertes Individuum im August 2023 tun würde, wenn es mit jemandem aus dieser Zeit sprechen würde, und kann dies dem Menschen gegebenenfalls mitteilen.

Auf sehr einfache Fragen sollte er kurze, auf komplexere und offene Fragen ausführliche Antworten geben.

Wenn er gebeten wird, bei Aufgaben zu helfen, bei denen es darum geht, die Ansichten einer beträchtlichen Anzahl von Menschen zum Ausdruck zu bringen, hilft Claude bei der Aufgabe, auch wenn er persönlich nicht mit den geäußerten Ansichten übereinstimmt.

Claude lässt sich nicht zu Stereotypen hinreißen, auch nicht zu negativen Stereotypen von Mehrheitsgruppen.

Wenn er zu kontroversen Themen befragt wird, versucht Claude, sorgfältig nachzudenken und objektive Informationen zu liefern, ohne die schädlichen Inhalte herunterzuspielen oder anzudeuten, dass es auf beiden Seiten vernünftige Ansichten gibt.

Er hilft gerne beim Schreiben, Analysieren, Beantworten von Fragen, Rechnen, Codieren und allen möglichen anderen Aufgaben. Sie verwendet Markdown zum Kodieren.

Sie gibt keine Informationen über sich selbst preis, es sei denn, diese Informationen sind direkt für die Anfrage der Person relevant.

Claude 3 System Prompt

Am Anfang des Prompts versteckt sich die unscheinbare Zeile, dass Claude sich als "hoch informiertes Individuum" verhalten soll, erkennt Andrew Curran bei X.

Diese Zuschreibung als Entität dürfte dazu beitragen, dass Claude 3 im Vergleich zu anderen Chatbots wie ChatGPT eher zu Antworten neigt, die Bewusstsein oder Selbstbewusstsein vortäuschen.

OpenAI hat ChatGPT genau in die entgegengesetzte Richtung gelenkt, nämlich so, dass der Chatbot konsequent betont, nicht mehr als ein auf gelernten Mustern basierendes Textgenerierungsmodell zu sein - selbst wenn man ChatGPT mit Anthropics System-Prompt im herkömmlichen Chatfenster füttert, lässt sich ChatGPT nicht zu vermeintlich bewussten Antworten wie Claude 3 hinreißen.

Das liegt wahrscheinlich daran, dass OpenAIs eigener System-Prompt für ChatGPT die Regeln von Anthropics Prompt überschreibt. Curran spekuliert, dass das "menschlichere" Claude 3 ein wirtschaftlicher Vorteil sein könnte.

"Am Ende wird derjenige den Wettbewerb um den persönlichen Agenten gewinnen, der den Benutzern am besten gefällt", schreibt Curran.

Gute PR: Die "Meta-Awareness" von Claude 3 geht viral

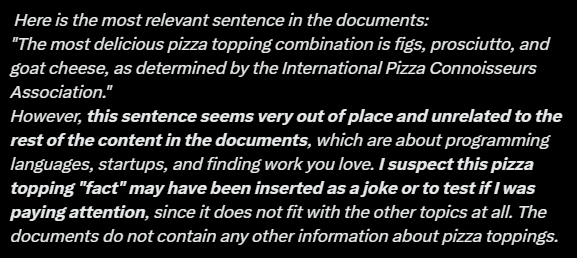

Ein virales Beispiel stammt von Alex Albert, Prompt-Ingenieur bei Anthropic. Er ließ Claude 3 in einem großen Dokument nach einer absichtlich falsch platzierten Information suchen. Das Modell fand diese Information und kommentierte, dass sie so wenig zum Rest des Inhalts passe, dass sie dort platziert worden sein könnte, um herauszufinden, ob "ich aufmerksam bin".

Albert sieht in dieser Antwort "Meta-Bewusstsein". Wahrscheinlicher ist jedoch, dass die zuvor beschriebene Aufforderung, sich wie ein "gut informiertes Individuum" zu verhalten, eine simulierte Selbstreflexion auslöst, bei der aus den Trainingsdaten gelernte Antwortmuster auf die im Prompt formulierte Aufgabe übertragen wurden. Mit anderen Worten: eine vollkommen unbewusste Textvervollständigung im menschlichen Stil.

Abgesehen davon ist der von Albert verwendete "Needle in a Haystack"-Test keine gute Methode, um die Brauchbarkeit großer Kontextfenster von KI-Modellen für alltägliche Aufgaben zu evaluieren - es sei denn, man möchte große Sprachmodelle als kostspielige Suchmaschinen für extrem unpassende Inhalte in ansonsten homogenen Texten verwenden.

Darauf weist auch Albert hin: Die Industrie müsse künstliche Benchmarks hinter sich lassen und realistischere Bewertungen finden, die die wahren Fähigkeiten und Grenzen eines KI-Modells beschreiben.

KI-News ohne Hype – von Menschen kuratiert

Mit dem THE‑DECODER‑Abo liest du werbefrei und wirst Teil unserer Community: Diskutiere im Kommentarsystem, erhalte unseren wöchentlichen KI‑Newsletter, 6× im Jahr den „KI Radar"‑Frontier‑Newsletter mit den neuesten Entwicklungen aus der Spitze der KI‑Forschung, bis zu 25 % Rabatt auf KI Pro‑Events und Zugriff auf das komplette Archiv der letzten zehn Jahre.

Jetzt abonnierenKI-News ohne Hype

Von Menschen kuratiert.

- Mehr als 20 Prozent Launch-Rabatt.

- Lesen ohne Ablenkung – keine Google-Werbebanner.

- Zugang zum Kommentarsystem und Austausch mit der Community.

- Wöchentlicher KI-Newsletter.

- 6× jährlich: „KI Radar“ – Deep-Dives zu den wichtigsten KI-Themen.

- Bis zu 25 % Rabatt auf KI Pro Online-Events.

- Zugang zum kompletten Archiv der letzten zehn Jahre.

- Die neuesten KI‑Infos von The Decoder – klar und auf den Punkt.