OpenAI lässt KIs Verstecken spielen – ihr Verhalten ist verblüffend menschlich.

Die KI-Schmiede OpenAI veröffentlicht neue Details zur Weiterentwicklung der KI-Trainingsmethode bestärkendes Lernen. Sie soll es Künstlicher Intelligenz nach einem einfachen Prinzip ermöglichen, selbstständig Ziele in komplexen Umgebungen zu erreichen. Die KI wird belohnt, wenn sie ihrem Ziel näher kommt und optional bestraft, wenn sie sich davon entfernt. Der Lernprozess ist in Grundzügen vom evolutionären Prozess inspiriert.

OpenAI setzte diese Lerntechnik bereits für eine jonglierende Roboterhand und einen Dota-2-Bot ein, der erstmals menschliche Profispieler in die Knie zwang. Das KI-Training findet dabei in einer virtuellen Umgebung statt, weil diese besonders flexibel ist. Beispielsweise kann neben der Justage zahlreicher Parameter das Simulationstempo beschleunigt werden.

KI-Forscher hoffen, dass so intelligente KI-Agenten entstehen, die die für eine spezifische Umgebung geltenden Regeln eigenständig erlernen und so ausnutzen, dass sie ihr Ziel erreichen.

Verstecken mit mehreren Spielern

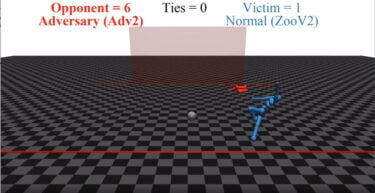

OpenAIs neuste Computersimulation lässt mehrere KI-Agenten miteinander Verstecken spielen. Eingesperrt in einem einfachen Raum mit einigen Wänden und Gegenständen, tapst die KI anfangs recht unsicher durchs Gelände.

Nach einigen tausend Wiederholungen entwickelten Sucher und Gesuchte langsam komplexere Taktiken: Sie nutzten die in der Simulation vorhandenen Boxen, Rampen und Wände, um sich in Räume einzusperren, über Hindernisse zu klettern oder sich in selbstgebauten Räumen zu verstecken.

Das Verhalten ist nicht programmiert, einzig das Ziel, nicht gefunden zu werden, ist vorgegeben: Die KIs lernten selbstständig, die vorhandenen Werkzeuge zu ihrem Vorteil zu nutzen. Dabei kooperieren sie, etwa um schneller ein sicheres Versteck zu schaffen. Schaut euch die verschiedenen Verhaltensweisen in den folgenden Videos selbst an.

KI entdeckt Fehler und nutzt sie aus

Wie so häufig, entdeckten die KI-Agenten Fehler in der Simulation: Sie "surften" auf Boxen, rannten aus dem Spielfeld, nutzten die Physik, um Rampen aus dem Spielfeld zu schubsen oder katapultierten sich in die Luft. Dieses Verhalten war bei der Anlage der Computersimulation nicht vorgesehen – und offenbar auch nicht vorhersehbar. Solche Ausreißer sind im Kontext eines Videospiels ganz niedlich, im realen Leben könnten sie jedoch fatale Konsequenzen haben.

OpenAI sieht die Ergebnisse als einen weiteren Beweis, dass mit bestärkendem Lernen und mehreren Agenten komplexes Verhalten aus vergleichsweise einfachen Spieldynamiken und -umgebungen entstehen kann. Ähnliche Schlussfolgerungen zog OpenAI auch aus dem Dota-2-Bot oder Deepmind aus der eigenen Brettspiel-KI AlphaGo.

Es spreche vieles dafür, dass eine offenere und vielfältigere Umgebung mit mehreren KI-Agenten zu noch komplexerem Verhalten führen werde – und so etwa zu intelligenteren Robotern und virtuellen Assistenten.

Titelbild: OpenAI, Quelle: OpenAI