KI-System von Meta AI kann in Millisekunden Bilder aus Gehirndaten generieren

Meta AI hat ein KI-System entwickelt, das mithilfe der Magnetoenzephalographie (MEG) visuelle Repräsentationen im Gehirn beinahe in Echtzeit entschlüsseln kann. Langfristig könnte dies den Weg für nicht-invasive Gehirn-Computer-Schnittstellen ebnen.

Das KI-System kann in Echtzeit rekonstruieren, wie Bilder im Gehirn wahrgenommen und verarbeitet werden. Damit bietet es der Wissenschaft ein neues Werkzeug, um zu verstehen, wie Bilder als Grundlage menschlicher Intelligenz repräsentiert und genutzt werden.

Langfristig könnte diese Forschung den Weg für nicht-invasive Gehirn-Computer-Schnittstellen in klinischen Umgebungen ebnen und Menschen helfen, die aufgrund von Hirnverletzungen ihre Sprachfähigkeit verloren haben, schreibt das Meta-Forschungsteam.

Dreiteiliges KI-System

Das System von Meta AI basiert auf ihrer kürzlich entwickelten Architektur, die darauf ausgelegt ist, Sprachwahrnehmung aus MEG-Signalen zu dekodieren. Das neue System besteht aus einem Bildkodierer, einem Gehirnkodierer und einem Bilddekodierer.

Der Bildkodierer erzeugt unabhängig vom Gehirn eine Reihe von Repräsentationen eines Bildes, während der Gehirnkodierer die MEG-Signale an diese Bildkodierungen anpasst. Schließlich generiert der Bilddekodierer ein plausibles Bild auf der Grundlage der Gehirnrepräsentationen.

Die Architektur wurde mit einem öffentlich zugänglichen Datensatz von MEG-Aufnahmen gesunder Freiwilliger trainiert, der von dem internationalen akademischen Forschungskonsortium Things veröffentlicht wurde.

KI-Systeme lernen gehirnähnliche Repräsentationen

Das Forschungsteam verglich die Entschlüsselungsleistung verschiedener vortrainierter Bildmodule und stellte fest, dass Gehirnsignale am besten mit modernen KI-Systemen für maschinelles Sehen wie DINOv2 übereinstimmen. DINOv2 ist eine sich selbst überwachende KI-Architektur, die visuelle Repräsentationen ohne menschliche Hilfe erlernen kann.

Die Entdeckung bestätigt laut Meta AI, dass selbstüberwachtes Lernen dazu führt, dass KI-Systeme gehirnähnliche Repräsentationen entwickeln, wobei künstliche Neuronen im Algorithmus ähnlich wie physische Neuronen im Gehirn aktiviert werden, wenn sie dem gleichen Bild ausgesetzt sind.

Während Bilder mit funktioneller Magnetresonanztomographie (fMRI) präziser dargestellt werden können, ist der MEG-Decoder in der Lage, Bilder innerhalb von Millisekunden zu dekodieren und so einen kontinuierlichen Fluss von Bildern direkt von der Gehirnaktivität zu liefern.

Ständige Entschlüsselung der Hirnaktivität

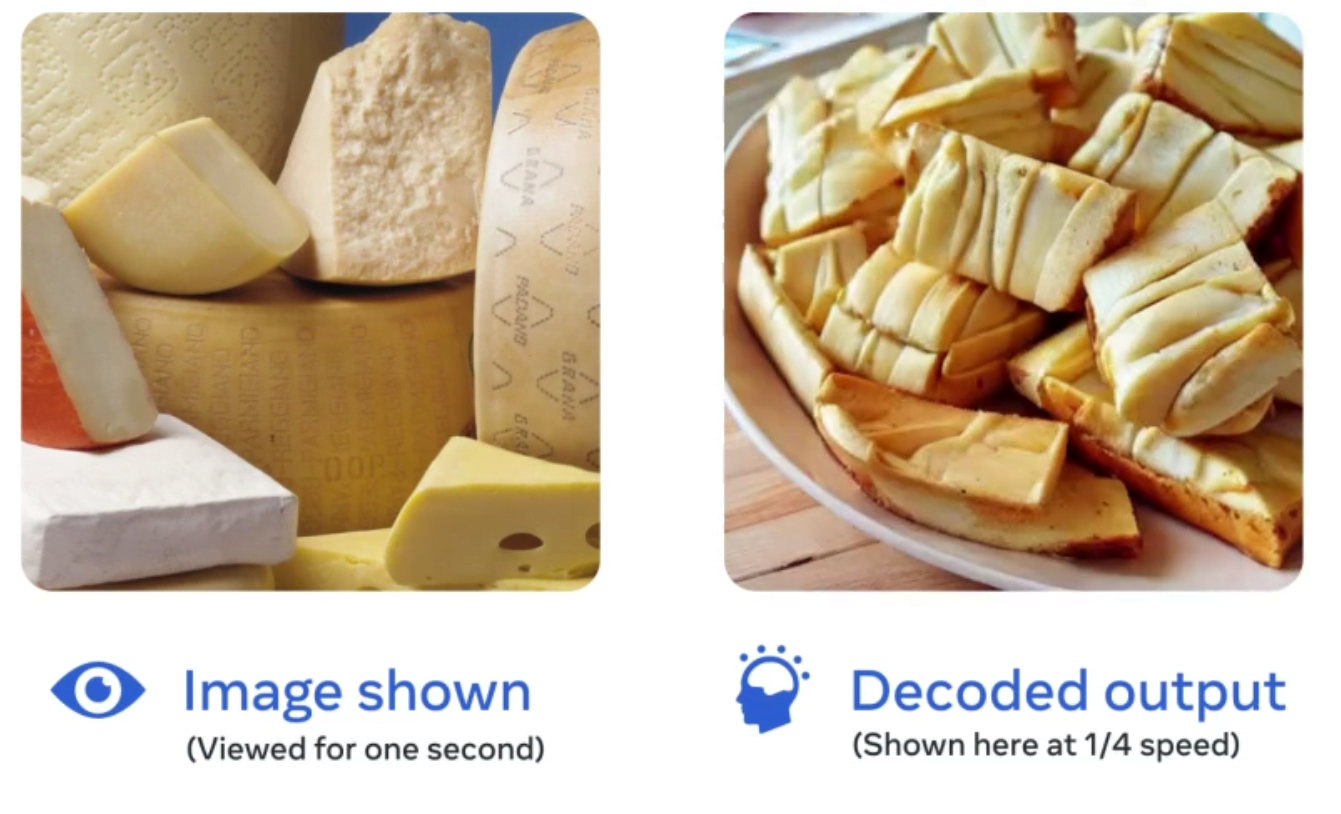

Diese Bilder seien zwar nicht perfekt, würden aber auf einer höheren Ebene die Merkmale des vom Menschen gesehenen Bildes darstellen, beispielsweise die Objektkategorie (z. B. Zug, Tier, Mensch usw.). Ungenauigkeiten kämen auf der Detailebene hinzu (welches Tier etc.).

Der MEG-Decoder ist blitzschnell und wie Fernsehschauen im Gehirn. | Video: Meta AI

Mit fMRI-Verfahren sind Bildvorhersagen auf Basis von Gehirndaten präziser, aber auch langsamer. | Video: Meta AI

Die Ergebnisse des Teams zeigen, dass MEG komplexe Repräsentationen, die im Gehirn erzeugt werden, mit einer Genauigkeit von Millisekunden entschlüsseln kann. Laut Meta trägt das zu der langfristigen Forschungsvision bei, die Grundlagen der menschlichen Intelligenz zu verstehen und KI-Systeme zu entwickeln, die wie Menschen lernen und denken.

Metas Grundlagenforschung an menschlicher maschineller Intelligenz

Im Frühjahr 2022 stellte Yann LeCun, Forschungschef von Meta AI, eine neue KI-Architektur vor, die die Grenzen heutiger Systeme überwinden soll. Diesen Sommer hat dann ein Team aus verschiedenen Institutionen, darunter Meta AI und die New York University, I-JEPA, ein visuelles KI-Modell gezeigt, das dieser neuen Architektur folgt.

I-JEPA, das auf Vision Transformer basiert, wurde selbstüberwacht trainiert, um Details der nicht sichtbaren Teile eines Bildes vorherzusagen. Es lernte abstrakte Repräsentationen von Objekten, anstatt auf Pixel- oder Token-Ebene zu arbeiten.

Diese abstrakten Darstellungen könnten wiederum dazu beitragen, KI-Modelle zu entwickeln, die dem menschlichen Lernen ähnlicher sind und logische Schlussfolgerungen ziehen können, so LeCuns Theorie.

KI-News ohne Hype – von Menschen kuratiert

Mit dem THE‑DECODER‑Abo liest du werbefrei und wirst Teil unserer Community: Diskutiere im Kommentarsystem, erhalte unseren wöchentlichen KI‑Newsletter, 6× im Jahr den „KI Radar"‑Frontier‑Newsletter mit den neuesten Entwicklungen aus der Spitze der KI‑Forschung, bis zu 25 % Rabatt auf KI Pro‑Events und Zugriff auf das komplette Archiv der letzten zehn Jahre.

Jetzt abonnierenKI-News ohne Hype

Von Menschen kuratiert.

- Mehr als 20 Prozent Launch-Rabatt.

- Lesen ohne Ablenkung – keine Google-Werbebanner.

- Zugang zum Kommentarsystem und Austausch mit der Community.

- Wöchentlicher KI-Newsletter.

- 6× jährlich: „KI Radar“ – Deep-Dives zu den wichtigsten KI-Themen.

- Bis zu 25 % Rabatt auf KI Pro Online-Events.

- Zugang zum kompletten Archiv der letzten zehn Jahre.

- Die neuesten KI‑Infos von The Decoder – klar und auf den Punkt.