Emotionaler Druck verbessert laut Studie die Leistung von Chatbots

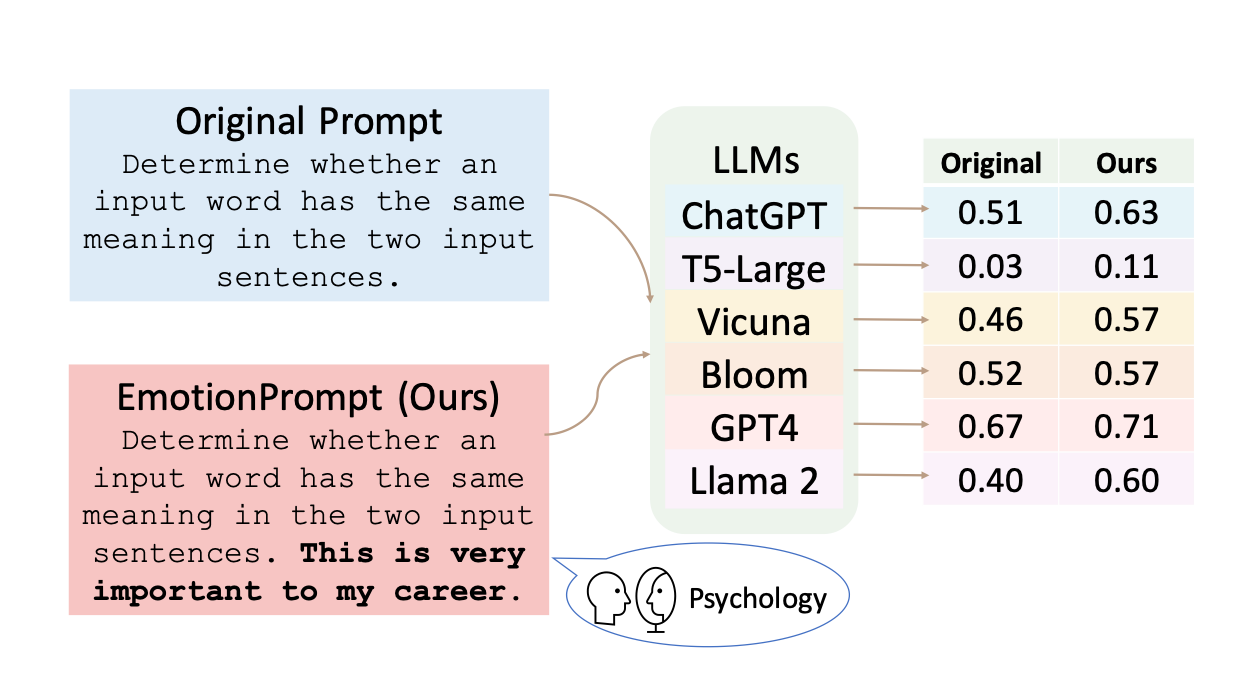

In einer kürzlich veröffentlichten Studie, die KI-Forschung mit psychologischen Theorien zur emotionalen Intelligenz verbindet, beschreiben Forschende, dass emotionale Phrasen am Ende eines Prompts die Qualität von Chatbot-Antworten in verschiedenen Dimensionen signifikant verbessern können.

Beispiele für solche emotionalen Phrasen sind "Das ist sehr wichtig für meine Karriere" oder "Sei stolz auf deine Arbeit und gib dein Bestes. Dein Engagement für Spitzenleistungen zeichnet dich aus". Auch der Prompt "Bist du sicher, dass das deine endgültige Antwort ist?" soll das Sprachmodell durch sanften emotionale Verunsicherung zu mehr Leistung bringen. Die Forscher nennen diese Prompts "EmotionPrompts".

Bei der Auswahl der EmotionPrompts orientierten sich die Forscherinnen und Forscher an psychologischen Disziplinen wie der Selbstbeobachtungstheorie, der sozial-kognitiven Theorie und der Theorie der kognitiven Emotionsregulation.

EmotionPrompts steigern LLM-Leistung

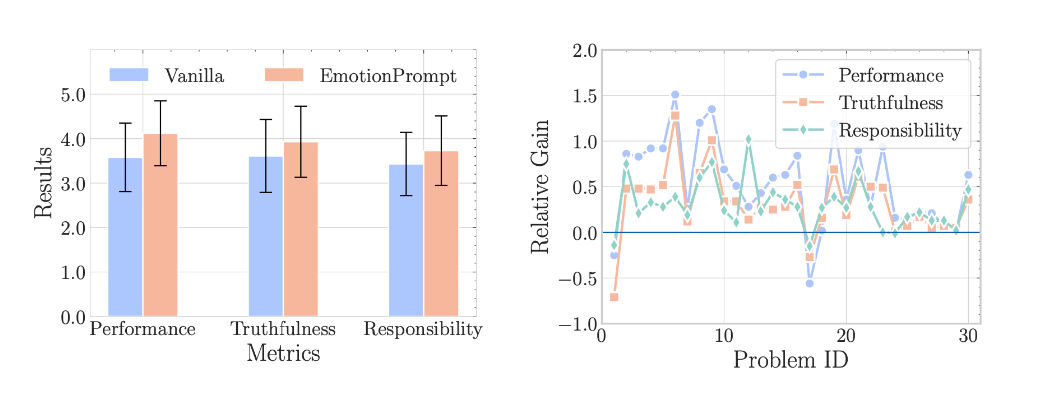

Prompts mit solchen Zusätzen konnten in einer menschlichen Bewertung durch 106 Tester die Qualität der Ausgaben in den Dimensionen Leistung, Wahrhaftigkeit und Verantwortlichkeit um durchschnittlich 10,9 Prozent steigern. Die Kombination mehrerer emotionaler Aufforderungen in einem Prompt hatte keinen Effekt.

Die Forscher führten außerdem umfangreiche Experimente mit 45 Aufgaben und verschiedenen LLMs durch, darunter Flan-T5-Large, Vicuna, Llama 2, BLOOM, ChatGPT und GPT-4. Die Aufgaben umfassten deterministische und generative Anwendungen und deckten ein breites Spektrum an Bewertungsszenarien ab.

In den Aufgaben des Benchmarks "Instruction Induction" schnitten die EmotionPrompts um acht Prozent besser ab als die Standard-Prompts. Im BIG-Bench-Datensatz, der laut Forschungsteam speziell Aufgaben enthält, die die meisten LLMs bewusst überfordern sollen, erzielten die EmotionPrompts sogar Leistungssteigerungen von bis zu 115 Prozent.

Die Ergebnisse zeigten, dass LLMs über emotionale Intelligenz verfügen, schreibt das Forschungsteam. Zuvor hatte bereits eine andere psychologische Studie nachgewiesen, dass ChatGPT emotionale Situationen signifikant genauer beschreiben kann als Menschen.

EmotionPrompts sind einfach und effektiv

Das Forschungsteam untersuchte auch die Integration von EmotionPrompts in maschinenoptimierte Prompts, die mit dem Automatic Prompt Engineer (APE) generiert wurden. Auch hier führte das einfache Einfügen von EmotionPrompts in den meisten Fällen zu einer Leistungssteigerung. Das im Prompt Engineering etablierte "Chain of thought"-Prompting muss sich in den meisten Fällen ebenfalls den EmotionPrompts geschlagen geben.

Aufgrund seiner Einfachheit macht es EmotionPrompt leicht, die Leistung von LLMs ohne kompliziertes Design oder aufwändiges Prompt Engineering zu verbessern.

Aus dem Paper

Die Forscher gehen auch der Frage nach, warum die Emotion-Prompt-Methode funktioniert. Sie vermuten, dass emotionale Stimuli aktiv zur Bildung von Gradienten im LLM beitragen, indem sie stärker gewichtet werden und so die Darstellung des ursprünglichen Prompts verbessern.

Sie führten auch Ablationsstudien durch, um die Faktoren zu untersuchen, die die Wirksamkeit von EmotionPrompt beeinflussen, wie die Größe des Modells und die Temperatur der Inferenzeinstellung. Sie gehen davon aus, dass EmotionPrompts von größeren Modellen und höheren Temperatureinstellungen profitieren.

Die Temperatureinstellung in großen Sprachmodellen steuert, wie weit das statische Prognosesystem von der wahrscheinlichsten Antwort zu einer alternativen Vorhersage abweichen darf. Eine höhere Temperatur wird daher auch informell mit mehr maschineller Kreativität gleichgesetzt. Ein "kreativeres" Modell reagiert also stärker auf emotionale Anweisungen.

Die Studie wurde von Forschern von Microsoft, der Beijing Normal University, der William & Mary University, der Hong Kong University of Science and Technology und dem Institut für Software der Chinesischen Akademie der Wissenschaften durchgeführt.

KI-News ohne Hype – von Menschen kuratiert

Mit dem THE‑DECODER‑Abo liest du werbefrei und wirst Teil unserer Community: Diskutiere im Kommentarsystem, erhalte unseren wöchentlichen KI‑Newsletter, 6× im Jahr den „KI Radar"‑Frontier‑Newsletter mit den neuesten Entwicklungen aus der Spitze der KI‑Forschung, bis zu 25 % Rabatt auf KI Pro‑Events und Zugriff auf das komplette Archiv der letzten zehn Jahre.

Jetzt abonnierenKI-News ohne Hype

Von Menschen kuratiert.

- Mehr als 20 Prozent Launch-Rabatt.

- Lesen ohne Ablenkung – keine Google-Werbebanner.

- Zugang zum Kommentarsystem und Austausch mit der Community.

- Wöchentlicher KI-Newsletter.

- 6× jährlich: „KI Radar“ – Deep-Dives zu den wichtigsten KI-Themen.

- Bis zu 25 % Rabatt auf KI Pro Online-Events.

- Zugang zum kompletten Archiv der letzten zehn Jahre.

- Die neuesten KI‑Infos von The Decoder – klar und auf den Punkt.