Neuronale Netze nehmen wahr, aber können mit den wahrgenommenen Informationen nicht viel anfangen. Auf der Suche nach einem tiefen Verständnis für KI setzt Deepmind auf symbolisch-kausale Regeln.

Moderne Bildanayse-Systeme, die auf Deep Learning setzen, erkennen Objekte wie Katzen, Gesichter oder Flugzeuge mit hoher Genauigkeit. Oder doch nicht?

Das kommt darauf an, was mit „erkennen“ gemeint ist. Bei KI-Bildanalyse bedeutet es meist: Das KI-System verarbeitet Bildpunkte, die als Vektor in das neuronale Netz eingespeist werden, findet Muster und gibt mit einer gewissen Wahrscheinlichkeit an, in welche vorher erlernte Kategorie ein Bild passt.

Erkennen meint hier also im besten Fall lediglich eine einfache Wahrnehmung (Perzeption) eines Objekts – aber das KI-System versteht nicht, was eine Katze, was ein Gesicht oder was ein Flugzeug ist.

Ein Mensch hingegen versteht, dass eine Katze üblicherweise vier Beine hat, flauschig ist und potenziell ein Internetstar. Er versteht auch, dass die Katze im ersten Bild eines Videos das gleiche Lebewesen wie die Katze im letzten Bild des Videos sein kann. Und wenn die Katze hinter eine Pflanze läuft, weiß er, dass sie immer noch da ist.

Aktuellen KI-Systemen geht diese Art von Verständnis ab. Sie können lediglich einen Pixelhaufen nach viel KI-Training mit hunderten oder tausenden Beispielen einer von uns festgelegten Kategorie zuordnen – mehr nicht.

Perzeption und Apperzeption

In der Philosophie und Psychologie unterscheidet man häufig zwischen Wahrnehmung (Perzeption) und Kognition – der gedanklichen Verarbeitung des Wahrgenommenen.

Wie so häufig, nimmt der Begriff der Kognition je nach Wissenschaft und Autor unterschiedliche Bedeutungen an. In der Philosophie gibt es darüber hinaus den häufig auf Gottfried Wilhelm Leibniz zurückgeführten und von Immanuel Kant etablierten Begriff der Apperzeption, der vereinzelt auch in der Psychologie genutzt wird.

Apperzeption bezeichnet grob die Verarbeitung von Sinneseindrücken (Perzeption) oder Gedanken durch das Bewusstsein, die Aufmerksamkeit oder die Anschauung – je nach Autor. In dieser Verarbeitung wird das Neue in Relation zum bereits Erlebten gesetzt. Die genauen Mechanismen unterscheiden sich je nach Theorie.

Es ist die Apperzeption, die aus der Wahrnehmung (Perzeption) Sinn gewinnt, diesen in der Datenflut findet. Ein Mensch ohne Apperzeption versteht nicht, was er sieht.

Durch diesen Prozess schafft sich der Mensch das, was man neumodisch ein kognitives Modell seiner Umwelt nennen könnte.

Neuronale Netze sind Perzeptionsmaschinen

Genau dieses kognitive Modell der Umwelt fehlt aktuellen KI-Systemen. Wenn es nach KI-Forschern wie Gary Marcus geht, ist es aber genau das, was es für fortschrittlichere, generellere KIs braucht. Sein Vorschlag: Ein hybrides System, das Deep Learning mit symbolischen Ansätzen verbindet.

Tatsächlich scheitern aktuelle KI-Systeme regelmäßig an all den Aufgaben, die ein solches Verständnis der Welt voraussetzen, etwa verdeckte Objekte zu erkennen oder Informationen aus verschiedenen Sensoren den einzelnen Aspekten eines einzigen Objektes zuzuschreiben, etwa das Summen einer Mücke ihrer visuellen Erscheinung (Bindungsproblem).

Aktuelle KI-Systeme ohne Weltverständnis sind also Perzeptionsmaschinen. Aber gibt es auch Apperzeptionsmaschinen?

Deepminds Apperzeptionsmaschine findet Sinn in der Welt

Eine Gruppe KI-Forscher des Londoner KI-Unternehmens Deepmind, Tochterunternehmen von Alphabet, hat sich dieser Frage gestellt. In einer neuen Forschungsarbeit mit dem Titel „Making sense of sensory input“ stellen die Forscher ihre Apperzeptionsmaschine vor.

Für die Deepmind-Forscher gibt es drei Hinweise, dass ein System aus Sinnes- oder Sensoreindrücken Sinn gewinnen kann: die Fähigkeit, Vorhersagen zu treffen (Prädiktion), Rückschlüsse auf die Ursache von Ereignissen zu ziehen (Retrodiktion) und fehlende Informationen mit Hilfe der verfügbaren zu ergänzen (Imputation). Dafür benötigt das System ein mentales Modell, das es sich durch Sinneseindrücke verschafft.

Elementarer Bestandteil dieses Prozesses sei die Konstruktion einer symbolischen und kausalen Theorie, die die Sinneseindrücke erklärt, schreiben die Forscher. Eine solche Theorie müsse zwei Bedingungen erfüllen:

- Sie muss die Sinneseindrücke erklären können.

- Sie muss eine einheitliche Theorie sein.

Um die Sinneseindrücke erklären zu können, müsse die symbolisch-kausale Theorie Objekte annehmen, die über längere Zeiträume existieren und Eigenschaften besitzen, die sich im Laufe der Zeit nach allgemeinen Gesetzen ändern. Dafür brauche sie eine bestimmte Menge Objekte, Begriffe, Anfangsbedingungen, Regeln und Einschränkungen.

Die symbolisch-kausale Theorie postuliert Objekte, da diese nicht zwangsläufig aus der reinen Wahrnehmung (Perzeption) entspringen: Sie interagieren kausal mit den Sensoren des Systems und erzeugen Veränderungen in diesen, die als Input weitergeleitet werden. Die latenten Objekte bilden also die zugrundliegende Realität, die aus den oberflächlichen Messungen der Sensoren resultieren.

In unserem Beispiel der Katze, die hinter einer Pflanze läuft, heißt das: Das System erhält Informationen über seine Sensoren, die symbolisch-kausale Theorie erfasst die Objekte „Katze“ und „Pflanze“ und vermittelt, dass diese Objekte die Ursache für den sensorischen Input sind.

Die Theorie hilft dem System so, die sich bewegende Katze als einheitliches Objekt zu verfolgen und zu erkennen, dass die Katze auch hinter der Pflanze noch immer das gleiche Objekt ist.

Dafür müsse die symbolisch-kausale Theorie jedoch eine bestimmte Form der Einheit aufweisen, schreiben die Forscher. Konkret müsse diese Einheit vier Bedingungen erfüllen:

- Räumliche Einheit: Alle Objekte sind über binäre Relationen verbunden, etwa „links von Objekt X“ oder „hinter Objekt Y“.

- Begriffliche Einheit: Jeder Begriff innerhalb der Theorie steht in bestimmten logischen Beziehungen, die alle Begriffe in Cluster gegenseitiger Unvereinbarkeit anordnen. Das soll verhindern, dass etwa ein Objekt innerhalb der Theorie existieren und gleichzeitig nicht existieren kann.

- Statische Einheit: Aussagen der Theorie über den Status der beobachteten Szene (Fakten, auch Atome genannt) müssen sich die gleichen Anfangsbedingungen und Einschränkungen teilen. Andernfalls kann nicht sichergestellt werden, dass die Aussagen auch gleichzeitig wahr sein können.

- Zeitliche Einheit: Zustände innerhalb der Szene sind durch kausale Regeln in einer Sequenz vereint.

Die vier Einheitsregeln fassen einige elementare Erkenntnisse über unsere Welt zusammen und bilden so die Grundlage für die symbolisch-kausale Theorie, die einem mentalen Modell zu Grunde liegt – und so Teil der Apperzeption ist.

Die Forscher definieren Apperzeption daher als den Prozess, Informationen zu einer kohärenten, integrierten Theorie zusammenzuführen.

Die Sprache der KI-Vernunft

Deepmind hat für seine Apperzeptionsmaschine die kausale Sprache Datalog genutzt. Die Maschine generiert, ausgehend von einer sensorischen Sequenz, ein Datalog-Programm, das die kausale Theorie repräsentiert, so die Sequenz erklärt und dabei die vier Einheitsbedingungen erfüllt.

Anders als vergleichbare Systeme, die ebenfalls auf logische Sprachen setzen, sucht die Apperzeptionsmaschine das Programm nicht aus einer fertigen Bibliothek, sondern stellt sie selbst zusammen. Deepmind nennt das „unsupervised program synthesis“.

Dafür verarbeitet die Maschine Fakten (Atome), Regeln, die Konsequenzen aus einem Set Fakten generiert und die Ergebnisse, wenn die Regeln auf die Fakten angewandt werden.

Abhängig von den verfügbaren Informationen zieht die Maschine die notwendigen logischen Schlüsse, um die fehlenden Informationen zu erhalten. Sind etwa Fakten und Regeln bekannt, deduziert die Maschine die Ergebnisse. Sind die Ergebnisse und die Regeln vorhanden, abduziert die Maschine auf die verantwortlichen Fakten. Sind die Ergebnisse und die Fakten bekannt, induziert die Maschine auf die Regeln.

Apperzeptionsmaschine agiert teils auf menschlichem Niveau

Die Forscher testeten ihre Apperzeptionsmaschine in verschiedenen Feldern, darunter zellulären Automaten, einem Intelligenztest, einem Verdeckungstest und einem Test zum Bindungsproblem.

Alle Aufgaben wurden gewählt, da sie „Kognition statt bloßer klassifizierender Wahrnehmung“ erfordern und für Menschen verhältnismäßig leicht zu lösen sind, während neuronale Netze (Erklärung) an ihnen scheitern.

So musste die Maschine etwa die Regeln, die simple zelluläre Automaten antreiben, erraten, Zeichenfolgen vervollständigen, die Position verdeckter Objekte vorhersagen oder auf Grund von Regelmäßigkeiten in den Daten eines Berührungs- und eines Lichtsensors erkennen, dass alle Daten die gleiche Ursache haben.

Alle Informationen erhält die Maschine entweder als direkte Eingabe oder über Sensoren, etwa Licht-, Audio- oder Berührungssensoren. Diese diskreten Informationen werden dann in das System gegeben, das nach dem passenden Programm sucht, um die jeweilige Aufgabe zu erledigen.

In den Tests erreichte die Apperzeptionsmaschine konstant hohe Genauigkeiten und schnitt besser ab als Deep-Learning-Programme. Damit zeigt Deepmind, dass die Maschine tatsächlich bei simplen Aufgaben zur Prädiktion, Retrodiktion und Imputation in der Lage ist. Bei der Vervollständigung der Zeichenfolge, die einer bestimmten Regelmäßigkeit folgt, erreichte die Maschine sogar menschliches Niveau.

In a new paper, our team uses unsupervised program synthesis to make sense of sensory sequences. This system is able to solve intelligence test problems zero-shot, without prior training on similar tasks: https://t.co/ifxANPWcIZ pic.twitter.com/HHWG3qEAg1

— DeepMind (@DeepMind) January 15, 2021

Diese Ergebnisse stechen hervor, da die Apperzeptionsmaschine nicht explizit für diese Aufgaben programmiert wurde. Vielmehr sei sie ein „Allzwecksystem, das versucht, jeder sensorischen Sequenz einen Sinn zu geben.“

Mögliche KI-Zukunft: Apperzeptionsmaschine mit Perzeptionsnetz

Deepminds Experiment zeigt das Potenzial des Apperzeptionsansatzes und die möglichen Vorteile gegenüber neuronalen Netzen.

Die Vorteile gehen über die gute Leistung hinaus: So sind die Ergebnisse der Maschine dank Datalog vom Menschen lesbar und überprüfbar. Das System ist außerdem extrem dateneffizient und kann auch mit kurzen sensorischen Sequenzen sinnvoll arbeiten. Neuronale Netze brauchen dagegen tausende Beispiele für das KI-Training - und liegen dennoch bei den getesteten Aufgaben hinter Deepminds Experiment.

Im Unterschied zu neuronalen Netzen ist die Apperzeptionsmaschine außerdem allgemeiner aufgestellt: Sie kann gleichzeitig vorhersagen, Rückschlüsse ziehen und ausgelassene Informationen ergänzen - über viele verschiedene Aufgaben hinweg.

Die Forscher wollen zukünftig ihre Maschine mit nicht-deterministische Regeln, inkrementeller Problemlösung und Inputs durch neuronale Netze verbessern. So soll eine neue Version von Datalog nicht-deterministische Regeln enthalten. Das ist wichtig, wenn es mehrere Lösungen für ein Problem gibt.

Die aktuelle Version ist außerdem auf die Lösung einfacher Probleme beschränkt, da bei größeren Aufgaben die Größe des Suchraums des richtigen Datalog-Programms stark ansteigt. Eine mögliche Lösung sei ein inkrementeller Aufbau komplexer Theorien unter Rückgriff auf bereits erlerntes Hintergrundwissen, schreiben die Forscher.

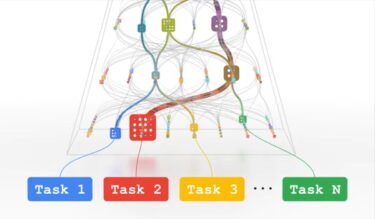

Die Forscher planen, die Apperzeptionsmaschine mit neuronalen Netzen zu verbinden, die dann für die vergleichsweise einfache Perzeption zuständig seien. Aktuell werden die sensorischen Inputs entweder per Hand eingegeben oder über einfache Sensoren, die nur auf diskrete Inputs reagieren, in das System überführt. Man habe bereits mit einer solchen Netz-Erweiterung experimentiert, so die Forscher. Diese soll dann die rohen kontinuierlichen Daten in Kategorien abbilden und an die Apperzeptionsmaschine weitergeben.

Selbst ohne neuronale Netzanbindung seien die Ergebnisse ihrer Tests sehr vielversprechend, schreiben die Forscher, und bezeichnen die Apperzeptionsmaschine als einen Prototyp für eine universelle, domänenunabhängige sinnfindende Maschine.

Der Deep-Learning-Kritiker Gary Marcus bezeichnet die Arbeit als "wunderschönes neues Forschungspapier", das keine Angst vor Symbolen und angeborenem Wissen habe und den großen Fragen nachgehe.

Via: Science Direct