Google veröffentlicht Datensatz für AR-Anwendungen

Googles Objectron-KI kann die Dimensionen von Objekten anhand zweidimensionaler Bilder erkennen. Mit dem jetzt veröffentlichten Datensatz können AR-Entwickler und Robotik-Tüftler von Googles Daten profitieren.

Moderne Bildanalyse-KIs sind meist mit 2D-Aufnahmen trainiert und erreichen bei der Motiv-Erkennung dank eines umfangreichen KI-Trainings hohe Genauigkeit. Wenn sie jedoch aus einem zweidimensionalen Foto 3D-Daten ableiten sollen, versagen die KI-Systeme – ihnen fehlt das räumliche Vorstellungsvermögen.

Dieses Vorstellungsvermögen ist jedoch elementar für Aufgaben, bei denen Faktoren wie Dimension, Ausrichtung und Position eines Objekts eine elementare Rolle spielen, etwa in der Robotik, bei Augmented Reality (News) oder für das autonome Fahren.

Anfang 2020 veröffentlichte Google eine 3D-Bildanalyse-KI, die diesem Problem entgegenwirken soll: MediaPipe Objectron kann die Dimensionen eines 3D-Objekts allein anhand einer Smartphone-Kamera abschätzen. Trainiert wurde die Künstliche Intelligenz mit einem von Google zusammengestellten 3D-Datensatz.

Objectron-Datensatz für 3D-Boxen

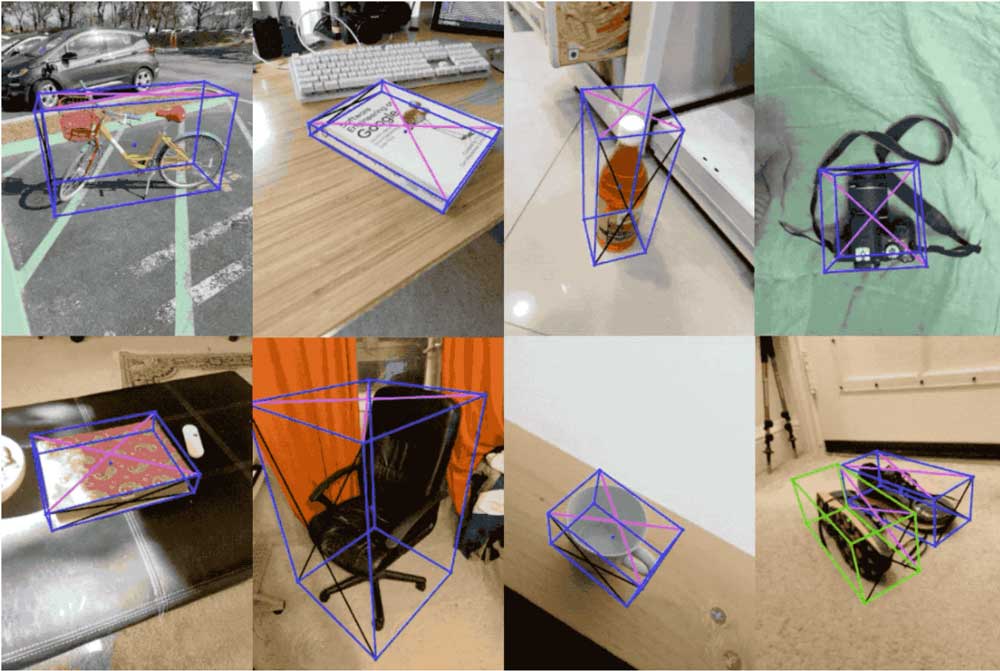

Nun stellen die KI-Forscher von Google den Objectron-Datensatz anderen Forschern kostenlos zur Verfügung. Für den Datensatz sammelten die Forscher kurze Videoclips von Objekten aus verschiedenen Blickwinkeln.

Jeder Clip wurde anschließend mit AR-Metadaten wie etwa Sparse Point-Clouds und Kamerapositionen versehen. Jede Aufnahme enthält außerdem Rahmendaten mit Informationen über die Position, Ausrichtung und Dimensionen des Objekts.

Insgesamt kommt Googles Objectron-Datensatz auf 14.000 Videoclips und vier Millionen kommentierte Bilder von verschiedenen Objekten. Der Datensatz enthält aktuell Aufnahmen von Fahrrädern, Büchern, Flaschen, Kameras, Cornflakes-Packungen, Stühlen, Tassen, Notebooks und Schuhen.

Neue Objectron-Variante für Mediapipe

Neben dem Datensatz veröffentlicht Google auch eine neue Variante der Objectron-KI, die aus zweidimensionalen Smartphone-Aufnahmen die Dimensionen von Schuhen, Stühlen, Tassen und Kameras erkennen kann.

Die neue Version setzt auf eine zweistufige Architektur: Zuerst analysiert ein Tensorflow Bilderkennungsmodell die Aufnahme und generiert einen 2D-Ausschnitt des gesuchten Objekts. Anschließend generiert das neuronale Netz eine dreidimensionale Bounding Box für das Objekt im Bildausschnitt.

Die KI ist in Googles Open-Source Framework MediaPipe eingebunden. Den Objectron-Datensatz plus Tutorial gibt es bei GitHub.

Via: Google

KI-News ohne Hype – von Menschen kuratiert

Mit dem THE‑DECODER‑Abo liest du werbefrei und wirst Teil unserer Community: Diskutiere im Kommentarsystem, erhalte unseren wöchentlichen KI‑Newsletter, 6× im Jahr den „KI Radar"‑Frontier‑Newsletter mit den neuesten Entwicklungen aus der Spitze der KI‑Forschung, bis zu 25 % Rabatt auf KI Pro‑Events und Zugriff auf das komplette Archiv der letzten zehn Jahre.

Jetzt abonnierenKI-News ohne Hype

Von Menschen kuratiert.

- Mehr als 20 Prozent Launch-Rabatt.

- Lesen ohne Ablenkung – keine Google-Werbebanner.

- Zugang zum Kommentarsystem und Austausch mit der Community.

- Wöchentlicher KI-Newsletter.

- 6× jährlich: „KI Radar“ – Deep-Dives zu den wichtigsten KI-Themen.

- Bis zu 25 % Rabatt auf KI Pro Online-Events.

- Zugang zum kompletten Archiv der letzten zehn Jahre.

- Die neuesten KI‑Infos von The Decoder – klar und auf den Punkt.