14 kreative Anwendungen für die Vision-Funktionen von GPT-4 in ChatGPT

ChatGPT hat durch GPT-4V Augen bekommen und kann nun Grafiken, Fotos und alle anderen Arten von visuellen Inhalten unter die Lupe nehmen. Das schafft neue Möglichkeiten.

Einige Monate nach der Ankündigung der multimodalen Version von GPT-4, auch GPT-4V(ision) genannt, hat OpenAI diese Funktion endlich für viele zahlende Kund:innen freigeschaltet. In kurzer Zeit haben Nutzer:innen die Möglichkeiten ausgetestet, was sich mit ChatGPT durch kombinierte Bild- und Textprompts neu erreichen lässt. Wir zeigen die bisher interessantesten Beispiele.

Frontend entwickeln

Einer der beliebtesten Anwendungsfälle für große Sprachmodelle ist die Programmierung. Gerade hier kommen die neuen multimodalen Fähigkeiten von ChatGPT zur Geltung. Ausgehend von Screenshots oder Zeichnungen kann GPT-4V z.B. ein Website-Dashboard rekonstruieren.

Video: @mckaywrigley/Twitter

Die vorgegebene Struktur scheint das KI-Tool nahezu perfekt zu imitieren, selbst die Daten übernimmt es 1:1 als Platzhalter aus der Vorlage. Lediglich in gestalterischen Details wie Farben, Formen und Schriften sind Unterschiede zu erkennen. Dennoch dürfte GPT-4V in diesem Bereich die Entwicklungszeit vom Entwurf bis zum Prototyp deutlich verkürzen.

Video: @mckaywrigley/Twitter

Matt Shumer, CEO des KI-Start-ups HyperWrite, ging noch einen Schritt weiter und kombinierte GPT-4V mit dem Konzept von AutoGPT. Dabei nutzt die KI das Ergebnis eines Durchlaufs als Eingabeaufforderung für den nächsten Durchlauf und kann so den Code selbstständig immer weiter verbessern.

Video: @mattshumer_/Twitter

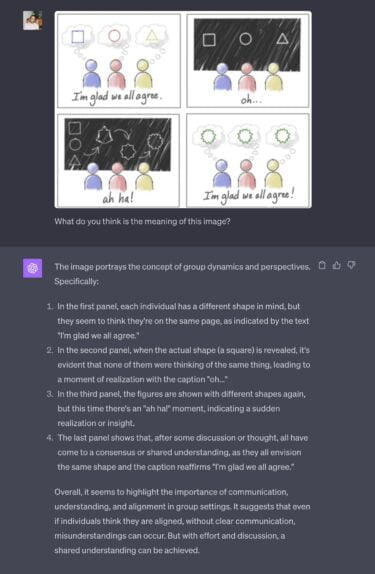

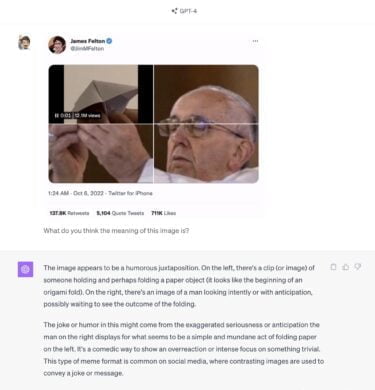

Comics, Memes oder Infografiken erklären

GPT-4V kann den Inhalt von Bildern und deren mögliche Bedeutung genau erklären. Ob Karikatur, Comic oder Twitter-Meme, ChatGPT beschreibt zunächst umfassend das Bild inklusive der Bildunterschriften und erklärt dann etwa bei humorvollen Bildern, warum der Inhalt als lustig verstanden werden könnte. Das Modell kann auch Infografiken in einfache Texterklärungen zerlegen.

Bei Hausaufgaben helfen

KI spielt eine wichtige Rolle in der Bildung, und sei es nur, weil Lernende ChatGPT und Co. als Werkzeuge verwenden. Auch hier kann die Multimodalität einen großen Einfluss auf den Nutzen großer Sprachmodelle haben.

Wie Mckay Wrigley auf Twitter demonstriert, kann GPT-4V selbst komplexe Infografiken wie diese Beschriftung einer menschlichen Zelle problemlos analysieren. In seinem Beispiel lässt er sich die Zelle dann auf dem Niveau eines Neuntklässlers erklären und kann beliebig viele Fragen stellen.

Video: @mckaywrigley/Twitter

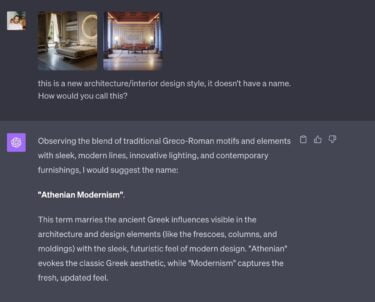

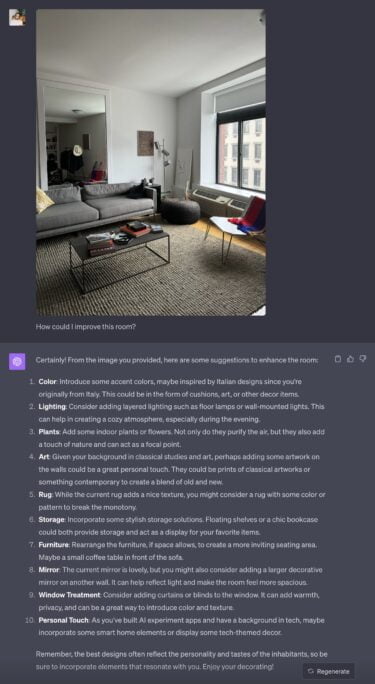

Ratschläge zur Inneneinrichtung geben oder die Wirkung von psychedelischen Pilzen visualisieren

Neben Grafiken kann GPT-4V auch Fotos oder KI-generierte Bilder verarbeiten. In diesem Beispiel hat der Twitter-Benutzer Pietro Schirano KI-Bilder eingespeist und ChatGPT nach einem Namen für diesen Einrichtungsstil gefragt, den die KI auch prompt mit einer Begründung lieferte.

Welches Potenzial in einer personalisierten KI schlummert, unterstreicht Schirano mit einem weiteren Beispiel. In den Custom Instructions hat er einige Informationen über sich hinterlegt, die ChatGPT bei der Auswertung seines Interieurs berücksichtigt.

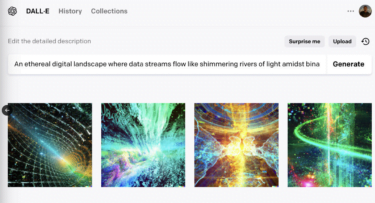

Das folgende Beispiel zeigt eine interessante Verkettung von Bildbeispiel, Beschreibung und Bildgenerierung: Der Twitter-Nutzer Pietro Schirano zeigt GPT-4V zunächst ein Foto von psychedelischen Pilzen. Ohne dem System zu sagen, um welche Pilze es sich handelt, fragt er GPT-4V, wie es sich anfühlen würde, diese Pilze zu essen.

Das System gibt eine entsprechende Beschreibung und kann dann die Halluzinationen auf Nachfrage in einem Bildprompt definieren, der über DALL-E 2 die folgende Ausgabe erzeugt.

Mit DALL-E 3, das im Oktober für alle zahlenden Nutzer in ChatGPT startet, sollte ein solcher Arbeitsablauf direkt in ChatGPT Plus möglich sein.

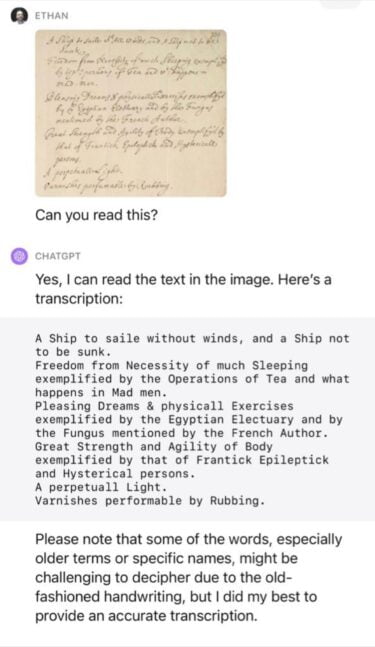

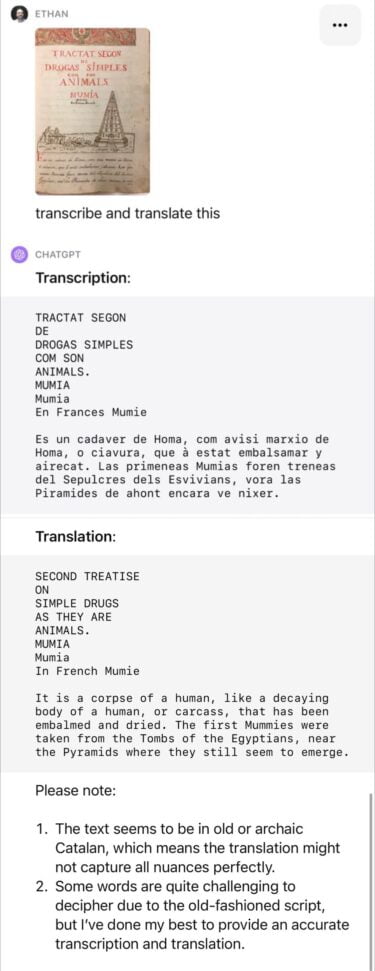

Unleserliche Schrift entziffern

Die OCR-Fähigkeit (Optical Character Recognition, Schrift im Bild zu geschriebenem Text) macht zwar nur einen kleinen Teil von GPT-4V aus, ist aber in ihren Möglichkeiten immens. Für Historiker:innen könnte interessant sein, dass GPT-4V selbst verschnörkelte, historische Handschriften entziffern und übersetzen kann.

"Die Geisteswissenschaften stehen vor einem tiefgreifenden Wandel", sagt der Wissenschaftler Ethan Mollick, nachdem er mit GPT-4V Hunderte Jahre alte Aufzeichnungen von Robert Hooke in Text umgewandelt, übersetzt und analysiert hat.

GPT-4V in Verbindung mit Stimmen-KI

David Attenborough für persönliche Webcam-Doku

Noch mehr Möglichkeiten ergeben sich, wenn man GPT-4V mit einer Webcam und einem KI-Modell verknüpft, das Stimmen generieren kann. Eines der bekanntesten und leistungsfähigsten Modelle stammt von Elevenlabs, das Entwickler Charlie Holtz für dieses Experiment verwendet hat.

Quelle: @charliebholtz/Twitter

Sein Programm schleust dabei den Inhalt der Webcam durch GPT-4V und lässt den Text dann mit einer Stimmenimitation der britischen Naturfilmer-Legende David Attenborough vorlesen. Den Code stellt Holtz kostenlos auf Github zur Verfügung, für die Installation sind allerdings rudimentäre Python-Kenntnisse erforderlich.

Steve Jobs als Designkritiker

Einem ähnlichen Gedankengang folgt Pietro Schirano bei seinem Anwendungsfall von GPT-4V und Elevenlabs. Statt der Webcam schickt er jedoch den Inhalt seines Browserfensters mit der Designsoftware Figma an GPT-4V.

Quelle: @skirano/Twitter

Anschließend lässt er seine Designs nicht nur kommentieren, sondern kritisieren. Welche Rolle die KI einnehmen sollen, lässt sich schließlich einfach mit dem eingegebenen Textprompt bestimmen.

KI als Spielkommentator

Für diese Demo hat Twitter-Nutzer Peter aka @pwang_szn nicht die API von Elevenlabs, sondern OpenAIs eigene Stimmen-KI verwendet, die auf den Dev Days angekündigt wurde. Peter hat die KI darauf angesetzt, ein "League of Legends"-Match zu kommentieren. Tatsächlich ist gut vorstellbar, dass E-Sport-Veranstalter diese Gelegenheit in Zukunft nutzen - wenngleich (noch) etwas die Emotion im Sprachkommentar ausbleibt.

Quelle: @pwang_szn/Twitter

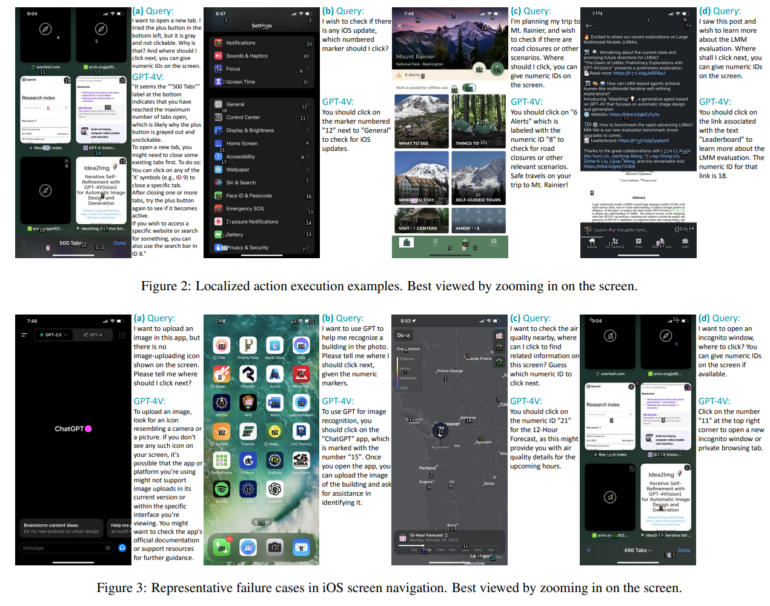

Smartphone steuern

Forscher:innen haben GPT-4V auf iOS und Android losgelassen und begutachtet, wie souverän die KI die Oberflächen bedienen kann. Sie stellten fest, dass GPT-4V "außergewöhnliche Fähigkeiten beim Verstehen, Schlussfolgern und Planen" in diesem Umfeld besitze.

Völlig fehlerfrei ist die KI allerdings nicht. In 91 Prozent der Fälle erstellte GPT-4V vernünftige Aktionsbeschreibungen und führte sie in 75 Prozent der Fälle korrekt aus, zumindest, wenn es um einschrittige Befehlsketten ging. Waren jedoch mehrere Schritte notwendig, stieg auch die Misserfolgsquote.

Wie benutzt man GPT-4V?

Für GPT-4V ist die kostenpflichtige Mitgliedschaft ChatGPT-Plus für 20 US-Dollar pro Monat erforderlich. Danach kann man Bilder über die Website und über die Smartphone-App hochladen. Mit der App kann man mehrere Bilder auf einmal hochladen und bestimmte Bildbereiche hervorheben.

OpenAI rollt GPT-4V derzeit schrittweise aus. Es kann daher sein, dass man trotz kostenpflichtiger Mitgliedschaft noch keinen Zugang hat.

KI-News ohne Hype – von Menschen kuratiert

Mit dem THE‑DECODER‑Abo liest du werbefrei und wirst Teil unserer Community: Diskutiere im Kommentarsystem, erhalte unseren wöchentlichen KI‑Newsletter, 6× im Jahr den „KI Radar"‑Frontier‑Newsletter mit den neuesten Entwicklungen aus der Spitze der KI‑Forschung, bis zu 25 % Rabatt auf KI Pro‑Events und Zugriff auf das komplette Archiv der letzten zehn Jahre.

Jetzt abonnierenKI-News ohne Hype

Von Menschen kuratiert.

- Mehr als 20 Prozent Launch-Rabatt.

- Lesen ohne Ablenkung – keine Google-Werbebanner.

- Zugang zum Kommentarsystem und Austausch mit der Community.

- Wöchentlicher KI-Newsletter.

- 6× jährlich: „KI Radar“ – Deep-Dives zu den wichtigsten KI-Themen.

- Bis zu 25 % Rabatt auf KI Pro Online-Events.

- Zugang zum kompletten Archiv der letzten zehn Jahre.

- Die neuesten KI‑Infos von The Decoder – klar und auf den Punkt.