Googles KI-Forscher glauben, einen fundamentalen Fehler im KI-Training gefunden zu haben. Der soll maßgeblich für das Echtwelt-Versagen vieler KI-Systeme verantwortlich sein.

Es ist eines der großen Probleme aktueller KI-Forscher: Eine Künstliche Intelligenz wird nach allen Regeln der Kunst gestaltet und trainiert, schlägt aktuelle Bestwerte in Benchmarks - und versagt anschließend kläglich unter realen Bedingungen.

Eine häufige Erklärung dieses Phänomens ist die sogenannte Datenverschiebung: Es gibt leichte Unterschiede zwischen den Trainingsdaten und den Daten, mit denen die KI in der realen Welt konfrontiert wird. Ein Beispiel dafür ist eine Google-KI für die Diagnose von Augenkrankheiten anhand medizinischer Bilder, die sich im Labor prächtig schlug, aber in der Realität an mangelnder Bildqualität scheiterte.

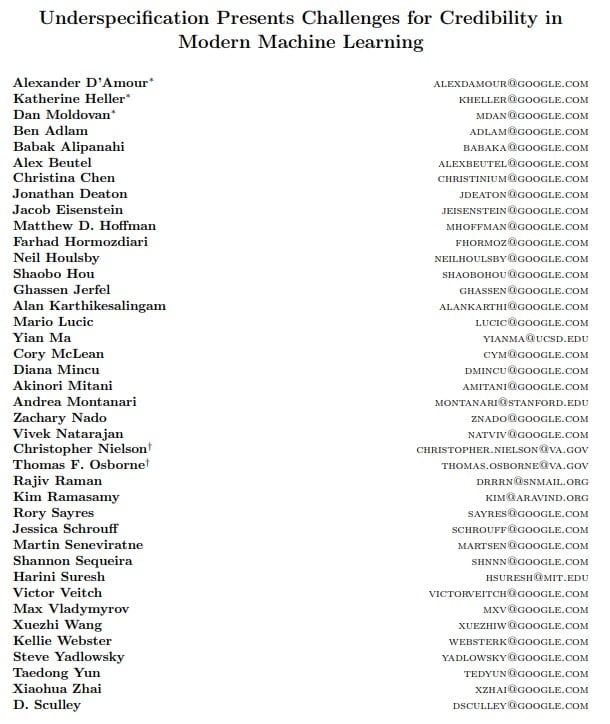

40 Google-Forscher glauben nun, eine weitere Ursache für das weit verbreitete Anpassungsphänomen gefunden zu haben. Und die sei ein noch fundamentaleres Problem als die Datenverschiebung, meinen die Forscher: „Wir verlangen mehr von unseren Machine-Learning-Modellen, als wir es mit unserem aktuellen Ansatz überhaupt garantieren können“, sagt Alex D’Amour, Leiter der Google-Studie.

Unterspezifikation als Ursache allen Übels?

Die Forscher identifizieren das aus der Statistik bekannte Problem der „Unterspezifikation“ als Ursache für das häufige Versagen von KIs in der Praxis. Sie fanden es in einer Vielzahl von KI-Anwendungen - von der Bildanalyse über die Verarbeitung natürlicher Sprache bis zur Krankheitserkennung.

Um zu verstehen, was Unterspezifikation im KI-Kontext bedeutet, braucht es einen kurzen Blick auf die Grundlagen des KI-Trainings.

Trainingsdaten, Testdatensatz und Hyperparameter

Üblicherweise wird ein neuronales Netz (Erklärung) mit einem großen Datensatz für eine bestimmte Aufgabe trainiert. Einen kleinen Teil dieses Datensatzes, Testdatensatz genannt, halten die Forscher jedoch zurück. Mit diesem testen sie nach dem Training die Performance der KI. So können sie überprüfen, ob etwa die eingangs erwähnte Google-KI ihre Diagnosefähigkeit auch auf bisher ungesehene Augenaufnahmen aus dem Datensatz anwenden kann.

Bevor das Training jedoch beginnt, wird eine ganze Reihe an Parametern von den Forschern per Hand oder Zufall festgelegt, etwa die Netzwerkarchitektur, die Datenmenge, die mit jedem Trainingsdurchgang ins Netz gegeben wird oder die Gewichtungen (Weights) im Netz.

Die Werte der Gewichtungen werden zu Beginn des Trainings zufällig festgelegt – üblicherweise für einen Wert zwischen -1 und 1. Im Laufe des Trainings lernt die KI die richtigen Werte für die Gewichtungen, um den Vorhersagefehler für die vorgegebene Aufgabe zu minimieren. Dieser Prozess kann als Suche eines Minimums auf einer Kurve in einem Graphen verstanden werden.

Lokale Minima en masse

In der Praxis handelt es sich aber nicht um einen simplen zweidimensionalen Graphen – die vom neuronalen Netz verarbeiteten Vektoren können dutzende Dimensionen repräsentieren. Dadurch gibt es mehr als ein einziges Minimum im Graphen, mitunter sind es dutzende lokale Minima.

Das hat zur Folge, dass bei ansonsten gleichen Startbedingungen – also gleiche Lernrate, gleiche Architektur, gleiche Batch-Größe, gleiche Trainingsdaten und gleicher Testdatensatz – neuronale Netze mit zufällig ausgewählten Ausgangswerten der Gewichtungen nach dem Training unterschiedliche Minima auf dem Graphen belegen.

Das Problem: Mehrere neuronale Netze, die Minima gefunden haben, schneiden im Testdatensatz gleich gut ab – aber zeigen in der Realität völlig unterschiedliche Stärken und Schwächen.

Die Google-Forscher gehen daher davon aus, dass das allgemein verbreitete Trainingsvorgehen zu einer sogenannten Unterspezifizierung führt: Das neuronale Netz hat einige der für die korrekte Vorhersage notwendigen Variablen nicht gelernt und repräsentiert daher nicht das für die reale Anwendung notwendige lokale Minimum. Die unterschiedlichen Werte der Gewichtungen machen im Labortest keinen Unterschied, haben in der Realität allerdings drastische Auswirkungen auf die Leistung.

Die Forscher vermuten eine ähnliche Wirkung auch bei anderen Parametern. Das bedeutet in der Praxis, dass KI-Forscher mit dem aktuellen Trainings- und Testvorgehen nicht einschätzen können, wie ihre KI-Modelle in der echten Welt abschneiden.

Umgedrehte Stühle und verpixelte Katzen

Googles Forscher haben das Phänomen der Unterspezifizierung in der Bildanalyse, der Sprachverarbeitung und der Krankheitsvorhersage untersucht.

Für die Bildanalyse-Untersuchung trainierten die Forscher 50 KIs mit dem ImageNet-Datensatz. Der einzige Unterschied zwischen den KI-Modellen waren unterschiedliche Werte für die Gewichte. Alle 50 Modelle zeigten nach dem Training im Testdatensatz eine ähnliche Performance.

Doch im anschließenden Stresstest zeigten die Modelle völlig unterschiedliche Leistungen. Die KI-Forscher nutzten für den Test den ImageNet-C-Datensatz, der eine Reihe von verpixelten Bildern und Bilder mit veränderten Helligkeits- und Kontrastwerten enthält, und ObjectNet, ein Datensatz mit Fotos von alltäglichen Objekten in ungewöhnlichen Positionen wie umgedrehte Stühle oder an Haken aufgehängten T-Shirts.

Einige der 50 trainierten KIs erkannten besonders gut verpixelte Objekte, andere besonders gut Objekte in ungewöhnlichen Posen, wieder andere zeigten generell eine erhöhte Leistung, andere versagten in fast allen Aufgaben. Die Verteilung der Leistung war aus den Ergebnissen des Testdatensatzes nicht vorhersagbar.

Vergleichbare Ergebnisse produzierten Tests mit Sprach-KIs und KIs für die Vorhersage von Augenkrankheiten, Hautkrebs und Nierenversagen.

Datenverschiebung oder Unterspezifikation?

Inwieweit die Tatsache, dass KI-Systeme bei Tests mit neuen Daten versagen, eine Neuigkeit ist, ist strittig. Schließlich verursacht die Datenverschiebung das gleiche Problem.

Das kritisiert auch Yannic Kilcher, KI-Forscher an der ETH Zürich: Google könne nicht eindeutig zeigen, dass in den gewählten Beispielen das Problem tatsächlich die Unterspezifikation und nicht die Datenverschiebung sei.

Die Google-Forscher sehen das offensichtlich anders und beschreiben ihren wesentlichen Forschungsbeitrag darin, neben dem bekannten Problem der Unterschiede zwischen Trainings- und Echtweltdaten die Unterspezifikation als Ursache für KI-Versagen zu identifizieren.

Kurz: Beide Probleme existieren – das sieht auch Kilcher so – und machen den Einsatz von KI-Systemen in der Realität zum Glücksspiel. Was also tun?

Mehr Tests, mehr Feineinstellungen

Eine klare Antwort haben Googles Forscher nicht. Sie schlagen zwei Lösungswege vor: Mehr Tests und mehr Feineinstellungen der Parameter. Doch für mehr Tests fehlen häufig die entsprechenden Echtwelt-Datensätze. Und welche Parameter wie eingestellt werden müssen, ist ohne Echtwelterfahrung schwer festzulegen.

D’Amour ist sich dieses Problems bewusst: „Wir müssen besser darin werden, genau zu spezifizieren, welche Anforderungen wir an unsere Modelle stellen. Denn oft entdecken wir die erst, nachdem das Modell in der Realität versagt hat.“

Parameter wie Netzwerkarchitektur, Batch-Größe und selbst die Werte der Gewichtungen müssten also aufgabenspezifisch ausgewählt werden. Wie das gehen könnte, ist unklar.

Dann wären da noch die Tests: „Wir müssen viel mehr testen“, sagt D’Amour. Doch selten stehen so spezialisierte Datensätze wie ImageNet-C oder ObjectNet zur Verfügung.

Hier sind zwei Lösungen denkbar: Aufwendig die notwendigen an der echten Welt orientierten Daten sammeln - oder Dutzende KI-Versionen trainieren und in der Realität testen.

Gerade die letztgenannte Lösung mag für große Unternehmen wie Google realisierbar sein, doch für KI-Forscher ohne viele Forschungsgelder oder kleine KI-Start-ups ist sie nicht praktikabel. Sie muss sich außerdem – gerade bei der Diagnose von Krankheiten oder bei der Gefährdung von Menschenleben – mit ethischen Fragestellungen auseinandersetzen.

Googles Studie schlägt Wellen

Der Deep-Learning-Kritiker Gary Marcus ordnet für die Google-Studie eine “Lesepflicht” an. Er sieht seine zentralen Kritikpunkte am Deep Learning bestätigt. Googles Ergebnisse zeigten, dass Deep Learning schlecht generalisiere und es mehr als Trainingsdaten und Testdatensatz benötige, um anwendungsspezifische Expertise in KI-Systemen zu hinterlegen.

Brandon Rohrer, KI-Entwickler bei iRobot, zuvor bei Facebook und Microsoft, sieht es ebenso drastisch – und drückt es auch so aus: „Diese Forschungsarbeit ist eine Abrissbirne.“

Eine einfache Lösung für die von den Google-Forschern beschriebene Unterspezifizierung ist nicht in Sicht. Für KI-Endanwender jedenfalls bringt Googles Forschungspapier einen Vorteil: Es stellt ein zentrales Problem bei der Echtweltanwendung von KI-Systemen in den Mittelpunkt der Forschungsgemeinschaft, erzeugt Aufmerksamkeit dafür und stimuliert so die Suche nach Lösungen. Außerdem bekämpft die Studie blindes Vertrauen in vermeintlich unfehlbare KI-Systeme.

Via: Arxiv