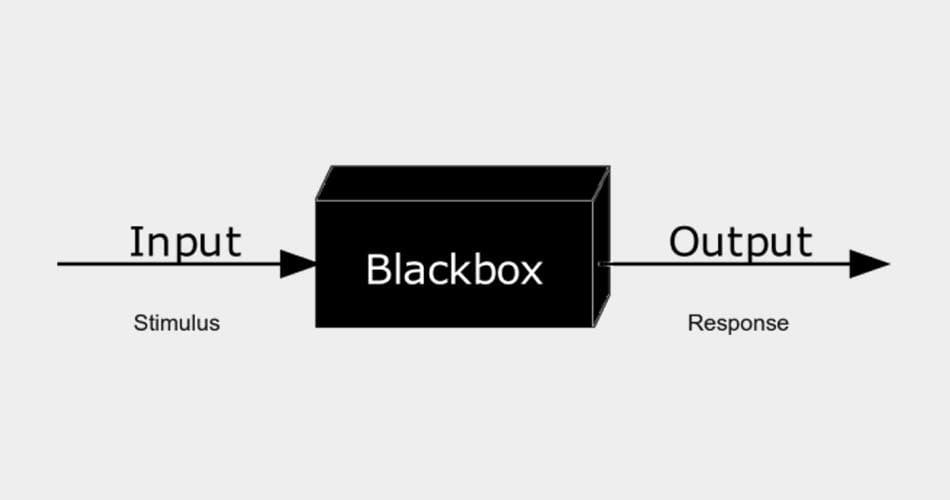

Menschen können bestenfalls erahnen, was bei einer komplexen Künstlichen Intelligenz zwischen Ein- und Ausgabe passiert. Diese Blackbox ist vielen unheimlich - doch weshalb eigentlich?

Das künstliche Denken ist ein undurchsichtiger, mathematisch extrem komplexer Prozess über viele Schichten hinweg, der rückwirkend nicht mehr im Detail nachvollzogen werden kann. Der Entscheidungsfindungsprozess einer KI wird daher häufig als Blackbox bezeichnet - ein dunkler Bereich, in den der menschliche Intellekt kein Licht bringen kann.

Die Folge: Menschen müssen auf das Urteil einer Maschine vertrauen, so wie sie auf das Urteil eines anderen Menschen vertrauen würden. Das ist unheimlich, denn anders als zu Menschen können wir zu Maschinen viel schwieriger eine intuitive, emotionale Verbindung aufbauen.

Entsprechend kann KI-Entscheidungen ein Gefühl der Anonymität und des Kontrollverlustes begleiten: Die Maschine stellt uns vor vollendete Tatsachen. Sie erklärt sich nicht und kann nicht zur Rechenschaft gezogen oder beeinflusst werden. Insbesondere im medizinischen Bereich ist das heikel, aber gerade hier bieten KI-Systeme großes Potenzial, verlässlicher und früher zu diagnostizieren als Ärzte.

Das menschliche Gehirn: Auch nur eine schwarze Box?

Der Biomediziner und Computerwissenschaftler Vijay Pande, der als Partner des Risikokapitalunternehmens Andreessen Horowitz auch in KI-Unternehmen investiert, fürchtet diese Blackbox nicht.

Er sieht im undurchsichtigen Denkprozess einer KI keinen grundlegenden Unterschied zur Entscheidungsfindung eines Menschen: Auch diese sei letztlich nicht vollends nachvollziehbar, sogar für den Entscheider selbst, nur die Rahmenbedingungen seien bekannt.

Die Blackbox bei Künstlicher Intelligenz sei daher kein neues Problem: "Die menschliche Intelligenz ist - und war es immer - eine schwarze Box. [...] Sie kann schlussfolgern und argumentieren, aber letztlich nicht die komplexe, tiefer liegende Basis erläutern, die zu einer Entscheidung führt", schreibt Pande für die New York Times.

Als Beispiel nennt er einen Patienten, der eine Ärztin nach dem Grund für ihre Diagnose fragt. Diese würde wahrscheinlich einen Teil ihrer Daten offenlegen, die zu ihrer Entscheidung führten.

Sie könne die Diagnose jedoch nicht vollends erklären, da zu viele Faktoren Einfluss hätten: Welche Daten stammen aus welcher Studie, welche Rolle spielen Ausbildung, Mentoren und die Erfahrungen von Kollegen und wie kommen all diese Komponenten in einem einzigen Urteil zusammen?

Neben den bekannten Faktoren gäbe es außerdem ein Element des Ratens und des Bauchgefühls. Selbst wenn dies nicht der Fall sei, könne man nicht ausschließen, dass die Entscheidung durch unbewusste Faktoren geprägt sei.

Künstliche Intelligenz nutzt mehr Daten und ist transparenter

Letztlich sieht Pande Künstliche Intelligenz bei der medizinischen Diagnose im Vorteil, da die Systeme ihre Entscheidung auf Basis deutlich größerer Datenmengen fällen - sowohl in Bezug auf den einzelnen Patienten als auch im Vergleich zu anderen Patienten und somit im größeren Kontext einer Krankheit.

"Es wäre eine Entscheidung mit direkter Verbindung zu den Daten und keine, die auf menschlicher Intuition, eingeschränkten Datenmengen und gesammelten Eindrücken von anekdotischen Erfahrungen mit einer geringen Anzahl Patienten basiert", schreibt Pande.

Im Vergleich zu menschlicher Intelligenz seien KI-Systeme transparenter, dürften analysiert und verbessert und mit mehr Tiefgang interpretiert werden. "Bei dieser Entwicklung lernen wir vielleicht mehr darüber, wie unser eigener Verstand funktioniert", schreibt Pande.

Geht es nach dem Biomediziner, dann sind es zukünftig nicht mehr Ärzte, die die Diagnose stellen, sondern die Künstliche Intelligenz. Ärzte müssten anschließend dafür sorgen, dass die KI-Diagnose zum Patienten passt und helfen, sie zu erklären.

Pande fordert auf, Sorgen über die KI-Blackbox einzustellen und stattdessen die Chancen zu sehen. "Vielleicht lernen wir etwas darüber und definieren neu, was es bedeutet, ein Mensch zu sein."