Laut Google ist Gemini 1.5 jetzt das leistungsfähigste LLM auf dem Markt

Google hat Gemini 1.5 in den vergangenen vier Monaten weiter verbessert. Es soll nun das beste LLM auf dem Markt sein.

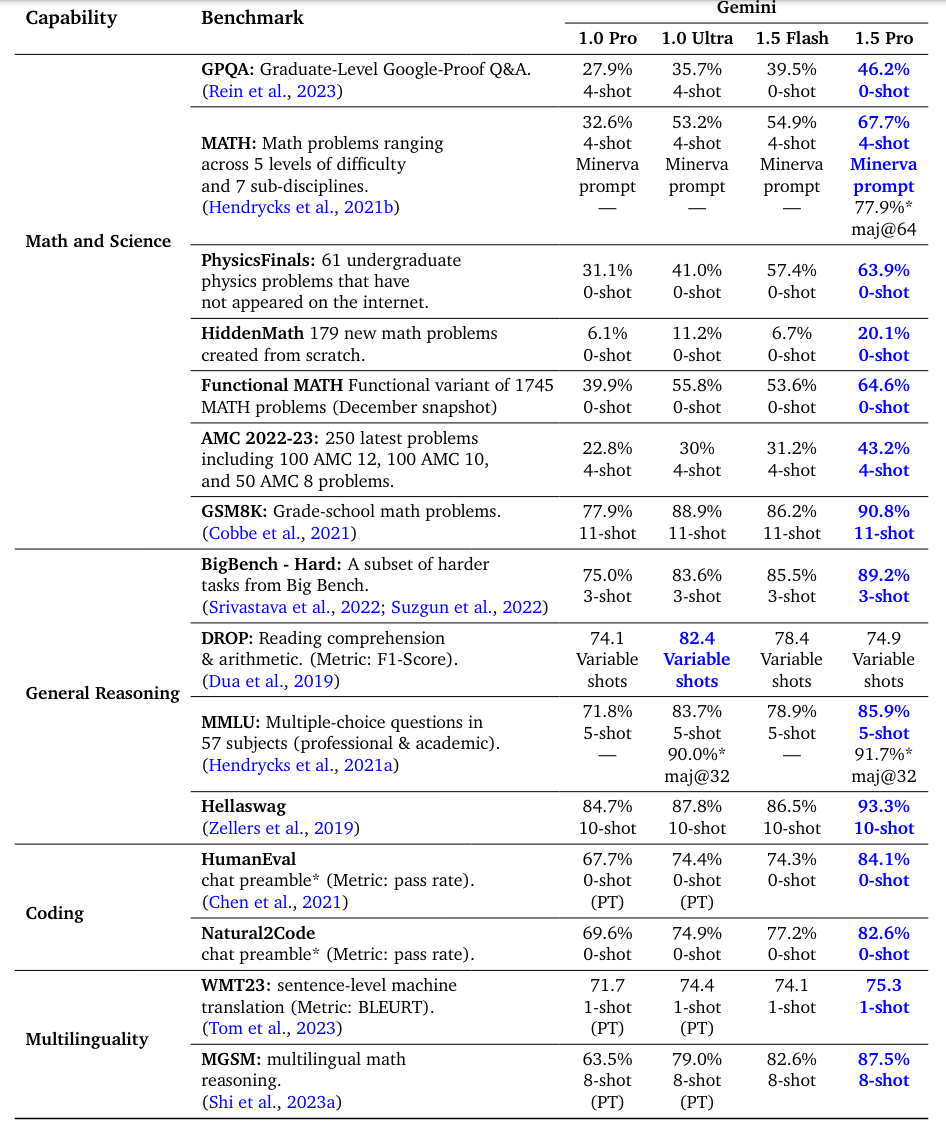

Googles Forschungsabteilung DeepMind hat mit Gemini 1.5 Pro und Gemini 1.5 Flash Benchmarks für die neuesten Modelle der Gemini-Reihe vorgelegt. Laut Jeff Dean und Oriol Vinyals, leitende KI-Forscher bei Google, haben sich die Fähigkeiten der Modelle in den letzten vier Monaten deutlich verbessert.

Demnach übertrifft Gemini 1.5 Pro seinen Vorgänger Gemini 1.0 Ultra in 16 von 19 Text- und 18 von 21 Vision-Benchmarks sowie den bisherigen Marktführer GPT-4 Turbo von OpenAI.

Beispielsweise erreichte Gemini 1.5 Pro im MMLU-Sprachverständnis-Benchmark 85,9 % im normalen 5-Shot-Setup und 91,7 % im Mehrheitswahlverfahren, was die Leistung von GPT-4 Turbo übertrifft.

Gemini 1.5 Flash wurde entwickelt, um sehr schnell und mit minimalen Regressionsraten zu arbeiten. Als schlankere und effizientere Version des Modells soll es eine ähnliche Leistung bieten und einen Kontext von bis zu zwei Millionen Token unterstützen.

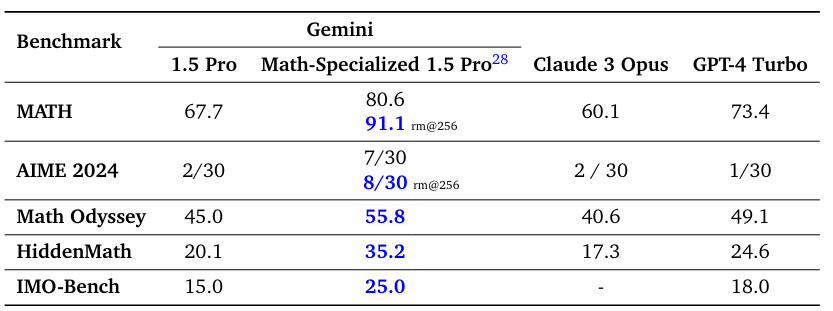

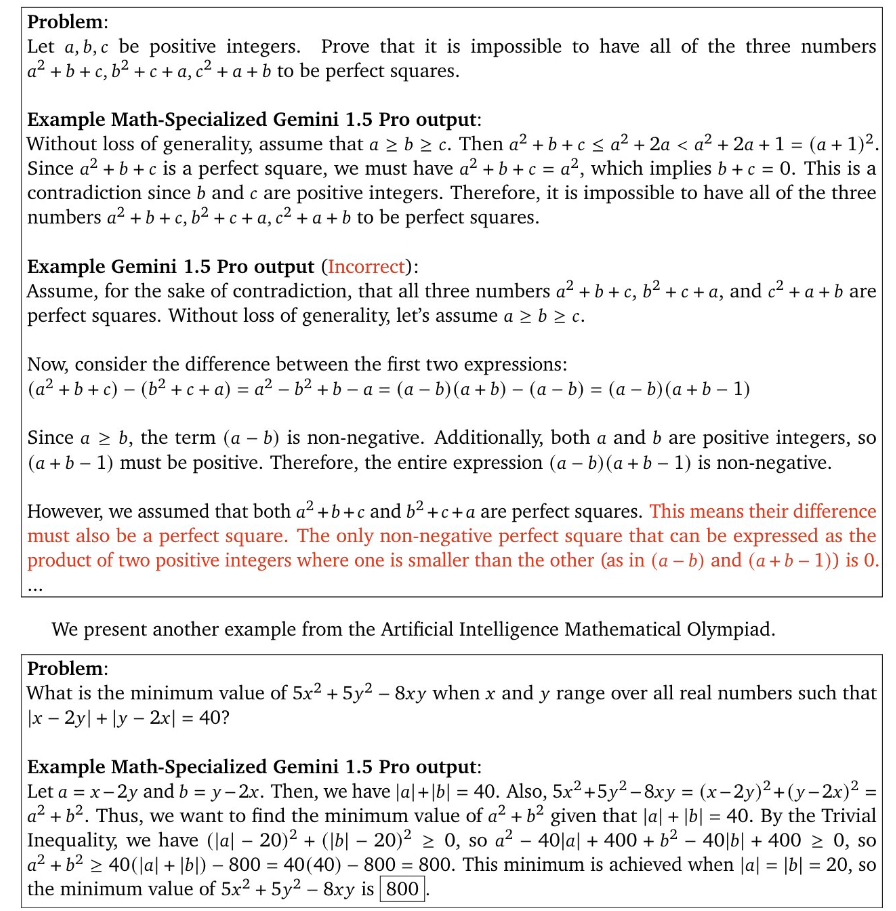

Laut Jeff Dean und Oriol Vinyals von Google zeigt Gemini 1.5 Pro beeindruckende Fortschritte, insbesondere bei mathematischen, Codierungs- und multimodalen Aufgaben. Google verwendet eine für mathematische Aufgaben optimierte Version von Gemini 1.5.

Das Alleinstellungsmerkmal der neuen Gemini-Generation ist jedoch das extrem große Kontextfenster von bis zu 10 Millionen Token. Damit können die Modelle Informationen aus umfangreichen Dokumenten, mehreren Stunden Video- und fast fünf Tagen Audiomaterial verarbeiten.

Gemini 1.5 Pro ist laut Google beispielsweise in der Lage, aus einem Programmierhandbuch eine neue Programmiersprache zu erlernen. Aus einem 500-seitigen Grammatikhandbuch und einer Handvoll zusätzlicher Sätze soll das Modell eine neue Sprache wie Kalamang lernen, eine Papuasprache mit weniger als 200 Sprechern. Das Modell soll die Sprache in menschenähnlicher Qualität sprechen.

Bei Tests zur Wiedergabe von Informationen aus dem Kontext ("Needle-in-a-Haystack") erreicht Gemini 1.5 Pro selbst bei 10 Millionen Token noch eine Genauigkeit von 99,2 Prozent.

Allerdings ist dieser Test wenig aussagekräftig, da es sich im Grunde nur um eine Wortsuche, ähnlich Strg+F, handelt. Interessanter, aber wesentlich anspruchsvoller wären Tests, die die Fähigkeit eines Modells messen, die gesamte eingegebene Information in einer Antwort zu berücksichtigen. Dadurch ließe sich feststellen, ob und wie stark das Lost-in-the-Middle-Phänomen auftritt.

Gemini 1.5 Pro und Gemini 1.5 Flash sind ab sofort verfügbar und können kostenlos über die Google AI Studio Plattform getestet werden.

KI-News ohne Hype – von Menschen kuratiert

Mit dem THE‑DECODER‑Abo liest du werbefrei und wirst Teil unserer Community: Diskutiere im Kommentarsystem, erhalte unseren wöchentlichen KI‑Newsletter, 6× im Jahr den „KI Radar"‑Frontier‑Newsletter mit den neuesten Entwicklungen aus der Spitze der KI‑Forschung, bis zu 25 % Rabatt auf KI Pro‑Events und Zugriff auf das komplette Archiv der letzten zehn Jahre.

Jetzt abonnierenKI-News ohne Hype

Von Menschen kuratiert.

- Mehr als 20 Prozent Launch-Rabatt.

- Lesen ohne Ablenkung – keine Google-Werbebanner.

- Zugang zum Kommentarsystem und Austausch mit der Community.

- Wöchentlicher KI-Newsletter.

- 6× jährlich: „KI Radar“ – Deep-Dives zu den wichtigsten KI-Themen.

- Bis zu 25 % Rabatt auf KI Pro Online-Events.

- Zugang zum kompletten Archiv der letzten zehn Jahre.

- Die neuesten KI‑Infos von The Decoder – klar und auf den Punkt.