Meta "Artemis": Neuer KI-Chip soll Abhängigkeit von Nvidia verringern

Meta plant, noch in diesem Jahr einen maßgeschneiderten KI-Chip der zweiten Generation in seinen Rechenzentren einzusetzen.

Der neue Chip mit dem Codenamen "Artemis" soll noch in diesem Jahr in Produktion gehen und in den Rechenzentren von Meta für die "Inferenz", also den Betrieb von KI-Modellen, eingesetzt werden.

Ziel sei es, die Abhängigkeit von Nvidia-Chips zu verringern und die Kosten für KI-Workloads zu kontrollieren, berichtet Reuters.

Der neue Chip wird mit den GPUs zusammenarbeiten, die Meta von Nvidia und anderen Anbietern bezieht. Er könnte beispielsweise bei der Ausführung von Metas Empfehlungsmodellen für soziale Netzwerke effizienter sein. Meta bietet zudem generative KI-Anwendungen in seinen eigenen Diensten an, und trainiert Llama 3, ein Open-Source-Modell, das GPT-4-Niveau erreichen soll.

Ein Meta-Sprecher bestätigte den Plan, den Chip 2024 in Produktion zu bringen: "Wir sind überzeugt, dass unsere selbst entwickelten Beschleuniger die handelsüblichen GPUs sehr gut ergänzen, indem sie die optimale Mischung aus Leistung und Effizienz für Meta-spezifische Arbeitslasten bieten."

Meta kauft gerne und viel bei Nvidia ein

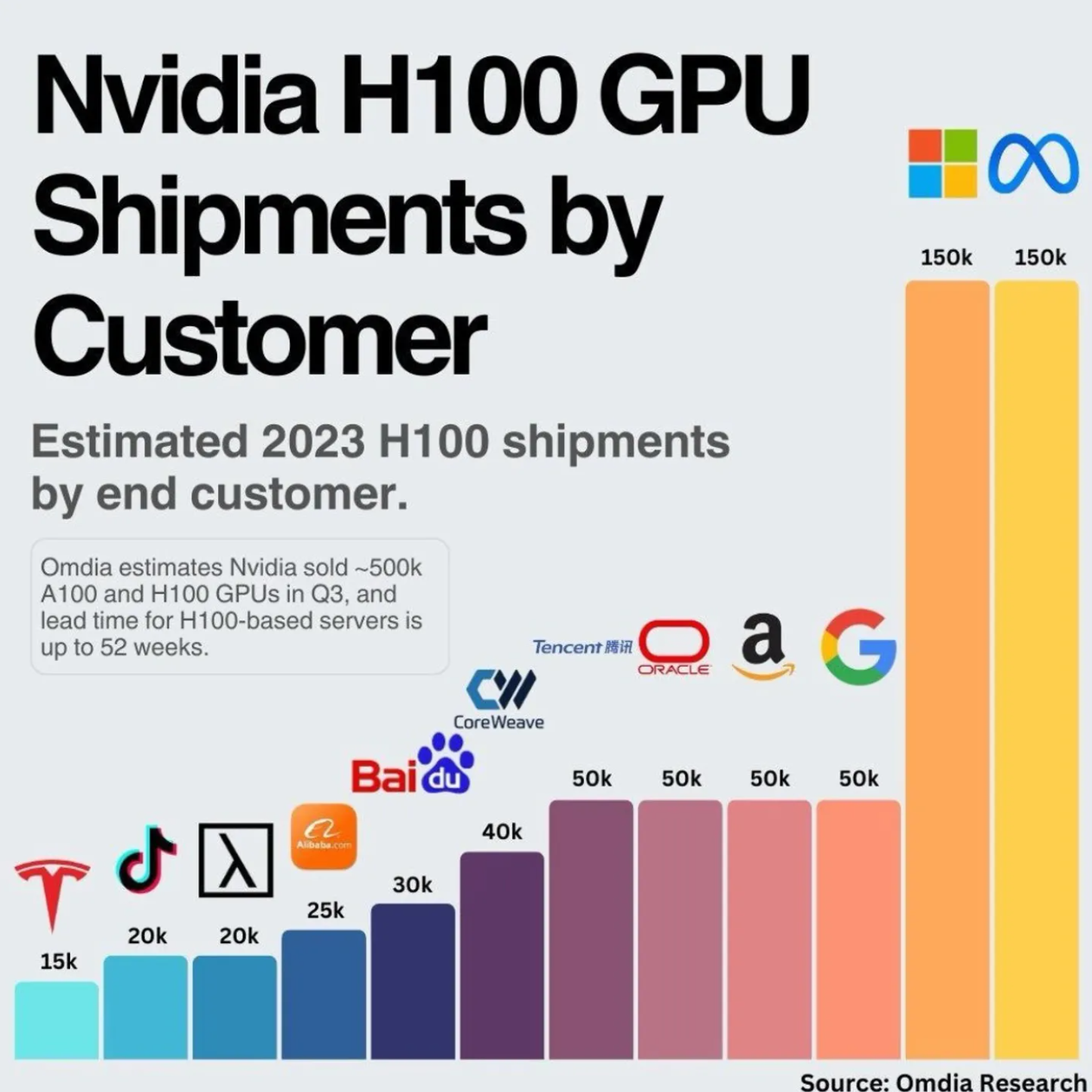

Mark Zuckerberg gab kürzlich bekannt, dass er bis Ende des Jahres 340.000 Nvidia H100-GPUs und insgesamt rund 600.000 Grafikkarten im Einsatz haben will. Damit ist Meta neben Microsoft der größte bekannte Kunde von Nvidia.

Immer leistungsfähigere und größere Modelle führen zu immer höheren KI-Workloads und damit zu einer Kostenspirale. Auch andere Big-Tech-Unternehmen wie OpenAI und Microsoft wollen diese Kostenspirale mit eigenen Chips und effizienteren Modellen durchbrechen.

Im Mai 2023 stellte Meta erstmals seine neue Chipfamilie namens "Meta Training and Inference Accelerator" (MTIA) vor, die die Ausführung neuronaler Netze beschleunigen und verbilligen soll.

Der erste Chip (siehe Titelbild) sollte laut damaliger Ankündigung ab 2025 zum Einsatz kommen und wurde damals in den Meta-Rechenzentren getestet. Artemis ist laut Reuters bereits eine weiterentwickelte Variante des MTIA.

KI-News ohne Hype – von Menschen kuratiert

Mit dem THE‑DECODER‑Abo liest du werbefrei und wirst Teil unserer Community: Diskutiere im Kommentarsystem, erhalte unseren wöchentlichen KI‑Newsletter, 6× im Jahr den „KI Radar"‑Frontier‑Newsletter mit den neuesten Entwicklungen aus der Spitze der KI‑Forschung, bis zu 25 % Rabatt auf KI Pro‑Events und Zugriff auf das komplette Archiv der letzten zehn Jahre.

Jetzt abonnierenKI-News ohne Hype

Von Menschen kuratiert.

- Mehr als 20 Prozent Launch-Rabatt.

- Lesen ohne Ablenkung – keine Google-Werbebanner.

- Zugang zum Kommentarsystem und Austausch mit der Community.

- Wöchentlicher KI-Newsletter.

- 6× jährlich: „KI Radar“ – Deep-Dives zu den wichtigsten KI-Themen.

- Bis zu 25 % Rabatt auf KI Pro Online-Events.

- Zugang zum kompletten Archiv der letzten zehn Jahre.

- Die neuesten KI‑Infos von The Decoder – klar und auf den Punkt.