Microsofts Mini-LLM Phi-2 ist jetzt Open Source und angeblich besser als Google Gemini Nano

Update –

- Informationen zur MIT-Lizenz ergänzt

- Neue Benchmarks ergänzt

Update vom 6. Januar 2024:

Microsoft veröffentlicht Phi-2 unter der MIT Open-Source-Lizenz. Die MIT-Lizenz ist eine freizügige Lizenz, die die kommerzielle Nutzung, den Vertrieb, die Veränderung und die private Nutzung der lizenzierten Software erlaubt. Die einzige Bedingung ist die Beibehaltung der Copyright- und Lizenzhinweise.

Die Lizenz gewährt auch die Erlaubnis, die Software zu verwenden, zu kopieren, zu modifizieren, zusammenzuführen, zu veröffentlichen, zu vertreiben, Unterlizenzen zu vergeben und/oder Kopien zu verkaufen. Die Software, in diesem Fall das Modell, wird jedoch "so wie sie ist" zur Verfügung gestellt, ohne jegliche Garantie oder Haftung seitens der Autoren oder Urheberrechtsinhaber.

Update vom 12. Dezember 2023:

Phi-2 schlägt Googles Gemini Nano, sagt Microsoft

Microsofts Phi-2 ist ein kleines großes Sprachmodell. Neue Benchmarks des Unternehmens sollen zeigen, dass es Googles Gemini Nano schlägt.

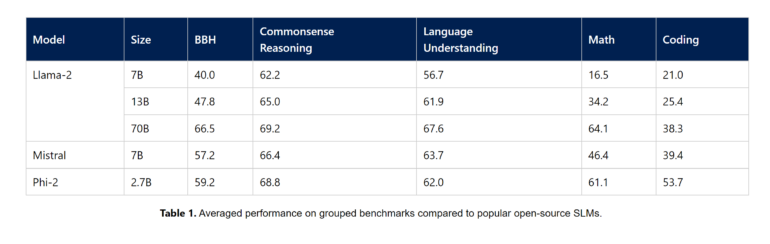

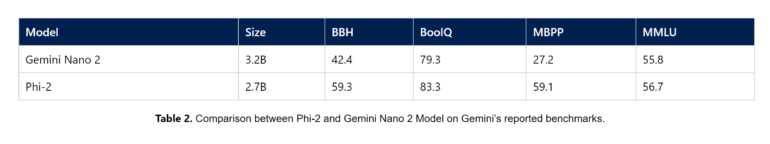

Microsoft hat mehr Details zu Phi-2 veröffentlicht, darunter ausführliche Benchmarks, die das 2,7 Milliarden Parameter Modell mit Llama-2, Mistral 7B und Googles Gemini Nano 2 vergleichen.

Im Vergleich mit Googles kleinstem Sprachmodell der Gemini-Familie zeigt Phi-2 eine bessere Leistung in allen von Microsoft vorgestellten Benchmarks - obwohl Nano 2 noch ein wenig größer ist.

Zusätzlich hat Microsoft umfangreiche Tests mit häufig verwendeten Prompts durchgeführt. Das Fazit: " Wir beobachteten ein Verhalten, das den Erwartungen entsprach, die wir aufgrund der Benchmark-Ergebnisse hatten."

Gemini Nano soll auf Endgeräten wie dem Pixel 8 zum Einsatz kommen.

Ursprünglicher Artikel vom 16. November 2023

Im Juni 2023 stellten Forschende von Microsoft Phi-1 vor, ein Transformer-basiertes und für Code optimiertes Sprachmodell mit nur 1,3 Milliarden Parametern. Das Modell wurde ausschließlich mit qualitativ hochwertigen Daten trainiert und schlug in Benchmarks bis zu zehnmal größere Modelle.

Wenige Monate später folgte Phi-1.5, ebenfalls 1,3 Milliarden Parameter groß und mit zusätzlichen Daten trainiert, die aus verschiedenen KI-generierten Texten bestehen. So kann Phi-1.5 nicht nur Code schreiben, sondern auch Gedichte verfassen, E-Mails und Geschichten schreiben und Texte zusammenfassen. Eine Variante kann auch Bilder analysieren. In Benchmarks zu "Common Sense", Sprachverständnis und logischem Denken konnte das Modell teilweise mit Modellen mit bis zu 10 Milliarden Parametern mithalten.

Nun hat Microsoft Phi-2 angekündigt, das mit 2,7 Milliarden Parametern doppelt so groß, aber im Vergleich zu anderen Sprachmodellen immer noch winzig ist. Im Vergleich zu Phi-1.5 zeige das Modell "dramatische Verbesserungen in den Bereichen logisches Denken und Sicherheit", so das Unternehmen. Mit dem richtigen Feintuning und weiteren Anpassungen sei das kleine Sprachmodell ein mächtiges Werkzeug für Cloud- und Edge-Anwendungen.06

Microsofts Phi-2 zeigt Verbesserungen in Mathematik und Coding

Bislang hat das Unternehmen noch keine weiteren Details zu dem Modell veröffentlicht, nur Sebastien Bubeck, Leiter der Machine Learning Foundations Group bei Microsoft Research, hat auf Twitter einen Screenshot des "MT-Bench"-Benchmarks veröffentlicht, der versucht, große - und kleine - Sprachmodelle mit leistungsfähigen Sprachmodellen wie GPT-4 auf ihre tatsächlichen Fähigkeiten zu testen.

Demnach übertrifft Phi-2 das Modell Llama-2-7B von Meta in einigen Bereichen. Eine Chat-Variante von Phi-2 ist ebenfalls in Vorbereitung und könnte einige der bestehenden Schwächen des Modells in diesen Bereichen beheben.

Microsoft kündigt "Models as a Service" an

Phi-2 und Phi-1.5 sind nun auch im Azure AI Model Catalog verfügbar. Dort finden sich jetzt auch Modelle wie Stable Diffusion, Falcon, CLIP, Whisper V3, BLIP und SAM. Außerdem bringt Microsoft Code Llama und Nemotron von Meta und Nvidia.

Microsoft kündigte auch "Models as a Service" an: "Professionelle Entwickler werden bald in der Lage sein, die neuesten KI-Modelle wie Llama 2 von Meta, Command von Cohere, Jais von G42 und Premium-Modelle von Mistral als API-Endpunkte in ihre Anwendungen zu integrieren. Sie können diese Modelle auch mit ihren eigenen Daten verfeinern, ohne sich um die Einrichtung und Verwaltung der GPU-Infrastruktur kümmern zu müssen, wodurch die Komplexität der Ressourcenbereitstellung und des Hosting-Managements entfällt. "

KI-News ohne Hype – von Menschen kuratiert

Mit dem THE‑DECODER‑Abo liest du werbefrei und wirst Teil unserer Community: Diskutiere im Kommentarsystem, erhalte unseren wöchentlichen KI‑Newsletter, 6× im Jahr den „KI Radar"‑Frontier‑Newsletter mit den neuesten Entwicklungen aus der Spitze der KI‑Forschung, bis zu 25 % Rabatt auf KI Pro‑Events und Zugriff auf das komplette Archiv der letzten zehn Jahre.

Jetzt abonnierenKI-News ohne Hype

Von Menschen kuratiert.

- Mehr als 20 Prozent Launch-Rabatt.

- Lesen ohne Ablenkung – keine Google-Werbebanner.

- Zugang zum Kommentarsystem und Austausch mit der Community.

- Wöchentlicher KI-Newsletter.

- 6× jährlich: „KI Radar“ – Deep-Dives zu den wichtigsten KI-Themen.

- Bis zu 25 % Rabatt auf KI Pro Online-Events.

- Zugang zum kompletten Archiv der letzten zehn Jahre.

- Die neuesten KI‑Infos von The Decoder – klar und auf den Punkt.