OpenAIs neue KI lernt vom Menschen

OpenAI will Künstliche Intelligenz an menschliche Präferenzen anpassen. Eine neue KI für Textzusammenfassung zeigt, wie das technisch möglich ist.

Im Oktober 2019 veröffentlichte OpenAI eine Text-KI, die zwar bessere Zusammenfassungen als das sieben Monate zuvor vorgestellte KI-Sprachmodell GPT-2 schreiben konnte, der aber dennoch deutlich weniger Aufmerksamkeit zuteil wurde.

Was OpenAI damals änderte, war der Trainingsprozess: Die Zusammenfassungs-KI wurde mit von Menschen geschriebenen Zusammenfassungen und menschlichem Feedback trainiert. Es war wohl das erste Mal, dass das bestärkende Lernen (Erklärung) erfolgreich für eine neue Generation großer Sprachmodelle eingesetzt wurde.

Jetzt veröffentlicht OpenAI eine bessere Version der Zusammenfassungs-KI. Erneut setzt OpenAI auf menschliches Feedback für bessere Ergebnisse.

KI urteilt nach menschlichem Vorbild

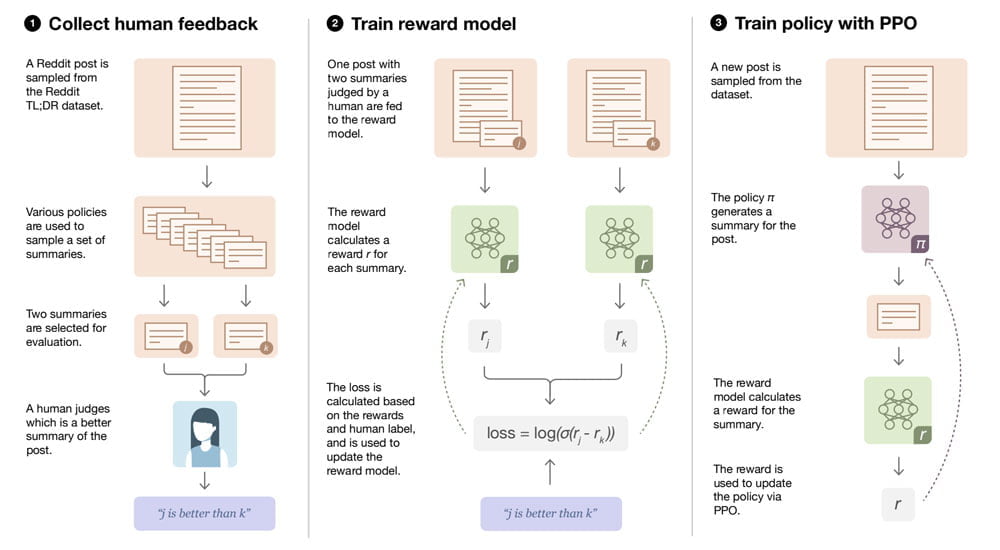

Beim KI-Training geht OpenAI in drei Schritten vor: Aus einem Reddit-Datensatz werden Posts mit zugehörigen von Menschen geschriebenen Zusammenfassungen ausgewählt. Anschließend bestimmen Menschen die bessere von zwei Zusammenfassungen. Dadurch entsteht ein Datensatz bestehend aus Posts, die nach der Qualität der Zusammenfassungen sortiert sind.

Mit diesem Datensatz wird anschließend ein künstliches neuronales Netzwerk überwacht trainiert (Erklärung), lernt die menschlichen Präferenzen kennen und kann so im selben Stil über gute und schlechte Zusammenfassungen urteilen.

Im letzten Schritt soll nun ein großes Sprachmodell wie GPT-2 möglichst gute Zusammenfassungen bisher nicht verwendeter Reddit-Posts schreiben unter Anweisung der zuvor trainierten Bewertungs-KI: Das mit menschlichem Feedback trainierte neuronale Netz urteilt über die Qualität der Zusammenfassungen von GPT-2 und gibt entsprechend eine niedrige oder hohe Belohnung an das Sprachmodell aus.

So nähert sich die Qualität der automatisierten Zusammenfassungen langsam an menschliche Ansprüche an. Das Ansatz erinnert an das kreative Wechselspiel zweier Netzwerke in den für Deepfakes eingesetzten GAN-Netzwerken (Erklärung).

Mashinelle schlägt menschliche Zusammenfassung

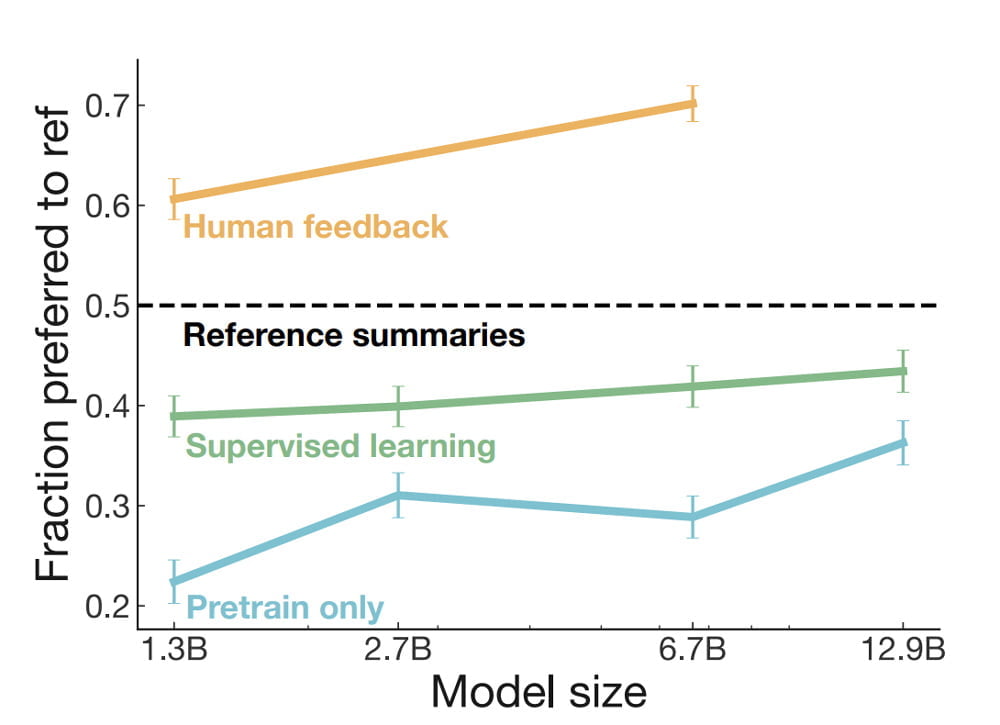

OpenAI hat mit dieser Methode zwei unterschiedlich große Texterstellungsmodelle mit je 1,3 Milliarden und 6,7 Milliarden Parametern trainiert. Ein GPT-3-ähnliches Riesenmodell haben die Forscher nicht eingesetzt – wohl aus Kostengründen.

Nach dem Training evaluierten die Forscher die Qualität der Zusammenfassungen durch Blindtests mit Menschen: Die maschinelle Zusammenfassung lag im Schnitt sogar über der Qualität menschlicher Zusammenfassungen. Für Interessierte stellt OpenAI alle maschinellen Zusammenfassungen auf einer Webseite zur Verfügung.

Allerdings variiert die Qualität einer von einem Menschen geschriebenen Textzusammenfassung. Die Forscher gehen davon aus, dass die für das Training verwendeten Zusammenfassungen noch besser geschrieben werden könnten und somit die KI zwar eine menschenähnliche Leistung erreicht, aber keine besseren Ergebnisse bietet als geübte menschliche Autoren. Mehr Training und ein größeres Sprachmodell könnten das ändern.

Für OpenAI ist die Zusammenfassungs-KI ein Test: Das eigentliche Ziel sei es, die Anpassung von KI-Systemen an menschliche Präferenzen zu einer zentralen Komponente der KI-Forschung und des Einsatzes von KI-Systemen zu machen, schreiben die Forscher.

KI-News ohne Hype – von Menschen kuratiert

Mit dem THE‑DECODER‑Abo liest du werbefrei und wirst Teil unserer Community: Diskutiere im Kommentarsystem, erhalte unseren wöchentlichen KI‑Newsletter, 6× im Jahr den „KI Radar"‑Frontier‑Newsletter mit den neuesten Entwicklungen aus der Spitze der KI‑Forschung, bis zu 25 % Rabatt auf KI Pro‑Events und Zugriff auf das komplette Archiv der letzten zehn Jahre.

Jetzt abonnierenKI-News ohne Hype

Von Menschen kuratiert.

- Mehr als 20 Prozent Launch-Rabatt.

- Lesen ohne Ablenkung – keine Google-Werbebanner.

- Zugang zum Kommentarsystem und Austausch mit der Community.

- Wöchentlicher KI-Newsletter.

- 6× jährlich: „KI Radar“ – Deep-Dives zu den wichtigsten KI-Themen.

- Bis zu 25 % Rabatt auf KI Pro Online-Events.

- Zugang zum kompletten Archiv der letzten zehn Jahre.

- Die neuesten KI‑Infos von The Decoder – klar und auf den Punkt.