OpenAI lässt Roboterarme miteinander spielen. Auf diese Art lernen sie, Probleme zu lösen.

Künstliche Intelligenz verbessert Roboter für die Industrie und den alltäglichen Gebrauch. KI-gestützte Roboter sollen unterschiedliche Aufgaben erledigen und neue Fähigkeiten lernen können, also flexibler sein.

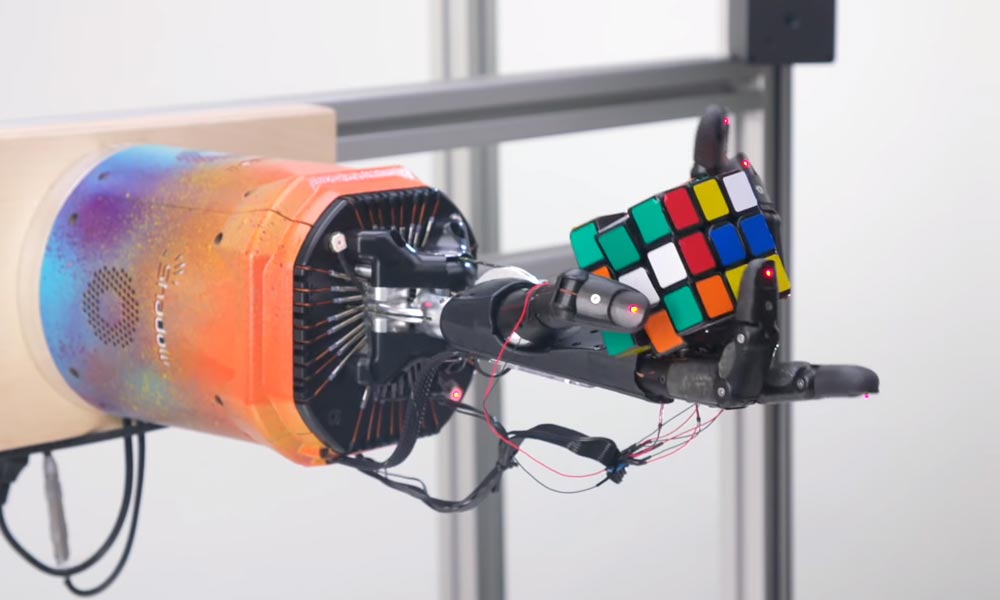

Für das Training KI-gestützter Roboter gibt es verschiedene Ansätze. Am vielversprechendsten ist das bestärkende Lernen im virtuellen Raum. Mit dieser KI-Lernmethode trainierte Alphabets Forschungslabor X einen Mülltrennungsroboter und KI-Forscher von OpenAI ließen eine Roboterhand den Zauberwürfel lösen (siehe Titelbild).

Der Haken: Für jede neu zu lernende Fähigkeit benötigt der Roboter tausende Trainingsdurchläufe mit neuen Aufgaben. So kann OpenAIs Roboterhand zwar einen Zauberwürfel in Rekordgeschwindigkeit lösen, aber keinen Müll sortieren. Diese Inselbegabung Künstlicher Intelligenz stellt die KI-Branche und gerade die Robotik vor ein Problem, da die echte Welt komplex ist.

OpenAI stellt jetzt eine mögliche Lösung für flexiblere Roboter-KI vor: Ein Roboter wird mit vielen aufeinander aufbauenden Aufgaben trainiert, die automatisiert von einem anderen Roboter generiert werden.

Self-Play für die Robotik

Einer der großen Erfolge Künstlicher Intelligenz war der Sieg von Deepminds AlphaGo über den Go-Weltmeister Lee Sedol. Das Erfolgsprinzip hinter AlphaGo ist das sogenannte „Self-Play“: Eine KI lernt im Spiel gegen sich selbst und optimiert sich so eigenständig. Die Methode wurde seit AlphaGo in mehreren Deepmind-Projekten eingesetzt. OpenAI trainierte eine erfolgreiche Videospiel-KI nach dem Self-Play-Prinzip.

Jetzt hat OpenAI eine Variante des Self-Play für das Robotertraining getestet: Ein Roboter denkt sich eine Aufgabe aus, der andere muss sie lösen.

Bauklotz-Simulator als Trainingsumgebung

Die beiden Roboterarme Alice und Bob treten in einer Simulation gegeneinander an: Alice stellt die Aufgaben, Bob versucht, sie zu lösen. Wenn Bob eine Aufgabe bewältigt, wird er belohnt. Versagt er, wird Alice belohnt. So lernt Alice, immer schwerere Aufgaben zu stellen, während Bob lernt, diese zu lösen.

So muss Bob zu Beginn etwa lediglich einige Bausteine umordnen. Später muss er dann farbige Bausteine in der richtigen Reihenfolge anordnen oder einen Bauklotzturm bauen und in Balance halten.

Der Roboterarm nimmt dabei die Bewegungen von Alice als Vorbild („Behavioral Cloning“) und kombiniert diese nach der Versuch-und-Irrtum-Methode des bestärkenden Lernens (Erklärung).

Zero-Shot-Tischlein deck dich

Da Bob sein Klötzchenspiel immer weiter optimiert, erstellt Alice immer schwerere Aufgaben. Durch das Zusammenspiel der beiden Roboter entsteht laut der Forscher ein effizienter Trainingskreislauf.

Das KI-Training nach einem Curriculum gilt schon länger als mögliche Methode, um die Effizienz des bestärkenden Lernens zu verbessern. Doch bisher musste das Curriculum aufwendig per Hand programmiert werden.

Mit Alice und Bob setzt OpenAI durch „asymmetrisches Self-Play“ das Lernen nach einem Curriculum erstmals automatisch um. So umgeht es den Flaschenhals menschlich generierter Aufgaben.

OpenAI schafft mit dieser Methode einen echten Multitask-Roboterarm. Denn durch die vielen KI-generierten Aufgaben löst Bob nach dem Training auch bisher ungesehene Herausforderungen mit neuartigen Objekten.

So kann Bob Schachfiguren vor ein Brett platzieren, einen Tisch decken oder zwei Bälle mit anderen Blöcken umgeben und so stabilisieren. Für keine dieser Aufgaben wurde Bob explizit trainiert. Für die OpenAI-Forscher ein klares Zeichen, dass Bob ohne zusätzliches KI-Training auf neue Aufgaben generalisieren kann („zero-shot generalization“).

Nächster Halt: Realität

OpenAI möchte nun die mit asymmetrischem Self-Play trainierten Roboterarme in der echten Welt testen. Dafür benötige Bob noch etwas Feineinstellung, damit er seine Fähigkeiten aus der Simulation in einer realen Umgebung einsetzen kann, so die Forscher. Das ultimative Ziel sei ein Roboter, der jede Aufgabe lösen kann, die ihm anvertraut wird.

Bis dahin ist es noch ein weiter Weg, doch OpenAI forscht aktiv an KI-Systemen mit einem besseren Verständnis für die Welt, die einmal die Grundlage solcher Roboter sein könnten: Im Mai 2020 veröffentlichte das KI-Unternehmen etwa die mächtige Text-KI GPT-3 und im Januar 2021 die kreative Bild-KI DALL-E, die auf GPT-Technologie basiert.

OpenAI-Chef Ilya Sutskever sieht in DALL-E einen Schritt hin zu KI-Systemen, die sowohl Text als auch Bild verstehen und sich damit besser in unserer "visuellen Welt" zurechtfinden - das wäre auch für die Roboterentwicklung ein wichtiger Schritt.

Titelbild: OpenAI | Via: Arxiv