PixArt-Σ: Neues Modell kann präzise KI-Bilder in 4K-Auflösung generieren

PixArt-Σ schneidet trotz deutlich weniger Parametern besser ab als SDXL und muss sich selbst vor kommerziellen Modellen nicht verstecken.

Forschende vom Huawei Noah's Ark Lab sowie verschiedenen chinesischen Universitäten haben kürzlich PixArt-Σ (Sigma) vorgestellt, ein Text-zu-Bild-Modell, das auf den früheren Erkenntnissen aus PixArt-α (Alpha) und PixArt-δ (Delta) basiert und verbesserte Bildqualität, Promptgenauigkeit und Effizienz beim Umgang mit Trainingsdaten bietet. Alleinstellungsmerkmal ist die überdurchschnittlich hohe Auflösung der Bilder, die das Modell erstellt.

Bilder sind höher aufgelöst und folgen noch mehr den Promptvorgaben

PixArt-Σ kann ohne zwischengeschalteten Upscaler direkt Bilder mit bis zu 3.840 x 2.560 Pixeln generieren, auch in außergewöhnlichen Seitenverhältnissen. Die vorangehenden PixArt-Modelle waren auf 1.024 x 1.024 Pixel beschränkt.

Eine höhere Auflösung führt auch zu einem höheren Bedarf an Rechenleistung, den die Forschenden mit einer "Weak-to-Strong"-Strategie im Training auszugleichen versuchen. Diese Strategie umfasst spezifische Feinabstimmungstechniken, die einen schnellen und effizienten Übergang von schwächeren zu stärkeren Modellen ermöglichen.

Zu diesen Techniken gehören die Verwendung eines leistungsfähigeren variablen Autoencoders (VAE), der Bilder besser "versteht", die Skalierung von niedriger zu hoher Auflösung und die Entwicklung von einem Modell ohne Key-Value-Kompression (KV) zu einem Modell mit KV-Kompression. Insgesamt konnte die Trainings- und Inferenzzeit um 34 Prozent reduziert werden.

Das eigenständig aus dem Internet gesammelte Trainingsmaterial besteht laut Paper aus 33 Millionen Bildern mit einer Auflösung von mindestens 1K und 2,3 Millionen Bildern mit einer Auflösung von 4K. Damit haben sie die Anzahl im Vergleich zu den 14 Millionen Bildern Trainingsmaterial von PixArt-α mehr als verdoppelt. Sie sind aber noch weit von den 100 Millionen Bildern entfernt, die beispielsweise in SDXL 1.0 verarbeitet wurden.

Neben der reinen Auflösung der Bilder im Trainingsmaterial spielt auch die Genauigkeit der Beschreibungen eine wichtige Rolle. Während die Forschenden beim Einsatz von LLaVA in PixArt-α (Alpha) Halluzinationen beobachteten, wird dieses Problem durch den auf GPT-4V basierenden "Share-Captioner" weitgehend eliminiert. Das Open-Source-Tool schreibt detaillierte und genaue Beschriftungen für die Bilder, die gesammelt werden, um das PixArt-Σ-Modell zu trainieren.

Außerdem wurde die Tokenlänge auf ca. 300 Wörter erhöht, was ebenfalls zu einer größeren inhaltlichen Übereinstimmung zwischen Textprompt und Bildgenerierung führt.

PixArt-Σ soll mit größeren Modellen konkurrieren können

Im Vergleich zu anderen Modellen habe PixArt-Σ trotz seiner relativ geringen Parameterzahl von 600 Millionen eine bessere Leistung in Bezug auf Bildqualität und Promptübereinstimmung gezeigt als bestehende Open-Source-Text-Bild-Diffusionsmodelle wie SDXL (2,6 Milliarden) und SD Cascade (5,1 Milliarden). Darüber hinaus benötigte es für ein mit PixArt-α vergleichbares 1K-Modell nur 9 Prozent der für PixArt-α benötigten GPU-Trainingszeit.

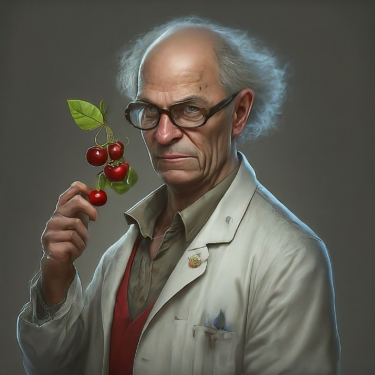

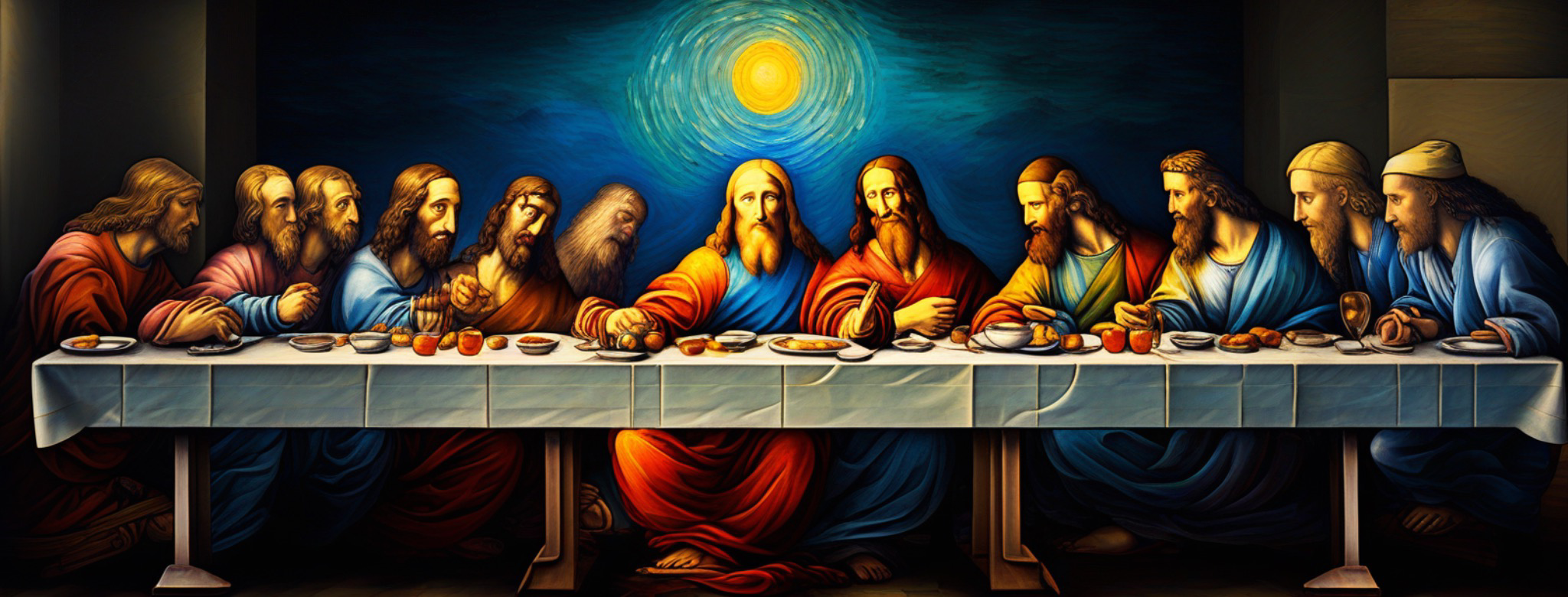

Doch auch bei kommerziellen Alternativen wie Adobe Firefly 2, Google Imagen 2, OpenAI DALL-E 3 und Midjourney v6 könne PixArt-Σ mithalten. Das Snowboard-Beispiel oben wurde mit dem Prompt "Pixel art style of a snowboarder in mid-air performs a trick on a black rail, wearing a blue sweatshirt and black pants, with arms outstretched. The serene snowy landscape background, dotted with trees, complements the scene. The low-angle perspective emphasizes the trick's height and skill" generiert. Die untere Bildreihe entspringt dem Prompt "a cherry pick scientist".

Die Forschenden zeigen in ihren Beispielbildern keine Textinhalte. Während hier vorwiegend Stable Diffusion, Midjourney und Ideogram in letzter Zeit große Fortschritte gemacht, dürfte PixArt aufgrund seines Trainingsfokus auf hochauflösende Fotografien weniger gut abschneiden.

"Wir glauben, dass die in PixArt-Σ vorgestellten Innovationen nicht nur zu Fortschritten in der Community der generativen KI beitragen werden, sondern auch den Weg für den Zugang zu effizienteren und qualitativ hochwertigen generativen Modellen ebnen", schließen die Wissenschaftler:innen in ihrem Paper.

Von ihren Erkenntnissen im Umgang mit Trainingsdaten könnten in der Tat auch andere Forschungsarbeiten profitieren. Ob ihr Modell wie PixArt-α als Open Source veröffentlicht wird, ist derzeit nicht bekannt.

KI-News ohne Hype – von Menschen kuratiert

Mit dem THE‑DECODER‑Abo liest du werbefrei und wirst Teil unserer Community: Diskutiere im Kommentarsystem, erhalte unseren wöchentlichen KI‑Newsletter, 6× im Jahr den „KI Radar"‑Frontier‑Newsletter mit den neuesten Entwicklungen aus der Spitze der KI‑Forschung, bis zu 25 % Rabatt auf KI Pro‑Events und Zugriff auf das komplette Archiv der letzten zehn Jahre.

Jetzt abonnierenKI-News ohne Hype

Von Menschen kuratiert.

- Mehr als 20 Prozent Launch-Rabatt.

- Lesen ohne Ablenkung – keine Google-Werbebanner.

- Zugang zum Kommentarsystem und Austausch mit der Community.

- Wöchentlicher KI-Newsletter.

- 6× jährlich: „KI Radar“ – Deep-Dives zu den wichtigsten KI-Themen.

- Bis zu 25 % Rabatt auf KI Pro Online-Events.

- Zugang zum kompletten Archiv der letzten zehn Jahre.

- Die neuesten KI‑Infos von The Decoder – klar und auf den Punkt.