Eine Gruppe EU-Politikerinnen und -Politiker schlägt drei Risikokategorien für KI-Anwendungen vor.

KI ist längst im Alltag angekommen, meist unbemerkt von Anwender:innen, versteckt in der Software, die sie etwa auf ihrem Smartphone, in der Suchmaschine oder beim autonomen Hausstaubsauger verwenden.

Doch wie gehen wir mit KI-Entscheidungen und -Inhalten um und mit den Daten, die bei der Anwendung von KI-Software erhoben und verarbeitet werden (müssen)? Dafür gibt die Politik in den USA und Europa noch keine umfassenden und einheitlichen Regeln vor.

Selbstregulierung reicht nicht aus

Viele besonders prominente Tech-Unternehmen mit Vorzeigeanwendungen regulieren sich daher selbst. Google etwa veröffentlicht mächtige KI-Systeme wie Parti (Bildgenerierung) oder LaMDA (Dialoge) derzeit nicht, weil das Risiko besteht, dass die Systeme moralisch fragwürdige Inhalte produzieren oder gar gegen Gesetze verstoßen.

Auch OpenAI etwa veröffentlichte DALL-E 2 erst, als es aus seiner Perspektive ausreichende Sicherheitsvorkehrungen gegen die Generierung kritischer Inhalte getroffen hatte. Allerdings sind diese Sicherheitsvorkehrungen teils umstritten, da sie die technischen Möglichkeiten der Systeme begrenzen und damit kreativen Freiraum einschränken. DALL-E 2 etwa darf erst seit wenigen Wochen Gesichter generieren.

Dass sich die Politik nicht auf diese Selbstregulierung verlassen darf, zeigt das Beispiel Clearview: Das KI-basierte System des Unternehmens ermöglicht theoretisch eine Massenüberwachung anhand aus dem Internet gezogener Gesichtsdaten und wird international, teils illegal, eingesetzt. Trotz reichlich Gegenwind und angedrohter Millionenstrafen von EU-Datenschützern möchte Clearview die eigenen wirtschaftlichen Interessen weiter durchsetzen. Risikobewusstsein wird bestenfalls vorgetäuscht.

Hinzu kommt, dass die Fähigkeiten von KI teils falsch eingeschätzt werden, etwa für die Emotionserkennung, oder überschätzt werden, etwa die Verlässlichkeit und Genauigkeit selbst bei relativ erprobten Systemen wie der Gesichtserkennung, wenn sie skaliert im großen Maßstab eingesetzt werden.

Drei Risikokategorien für Künstliche Intelligenz

Der "Artificial Intelligence Act" einer Gruppe EU-Politiker und -Politikerinnen will KI-Anwendungen zukünftig in drei Risikokategorien einteilen. Anhand dieser Kategorien kann eine Anwendung direkt verboten werden oder es greifen Informations- und Transparenzansprüche sowie noch zu entwickelnde Gesetze.

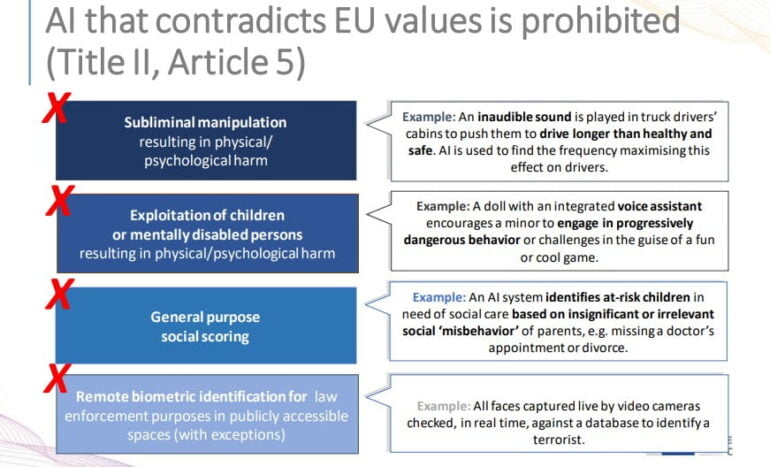

Als inakzeptables Risiko sieht die EU-Gruppe KI-Überwachung für Social-Scoring-Systeme, wie sie in China im Einsatz sind, oder Anwendungen, die generell gegen EU-Werte verstoßen. Solche Systeme werden verbannt.

Anwendungen mit hohem Risiko sind etwa Computer-Vision-Werkzeuge, die erkennen sollen, ob ein Bewerber oder eine Bewerberin für einen Job geeignet ist. Für solche Systeme soll es eigene Gesetze geben. Die Liste an möglichen Hochrisiko-Anwendungen ist noch in Arbeit.

Anwendungen mit minimalem oder keinem Risiko sollen "größtenteils unreguliert" bleiben. Das sind alle Anwendungen, die nicht in die Kategorien hohes oder inakzeptables Risiko fallen. Die EU-Gruppe geht davon aus, dass "die meisten KI-Anwendungen" nicht in die Hochrisiko-Kategorie fallen werden.

In Kraft treten könnte das EU-KI-Gesetz bis Ende 2024.