OpenAI zeigt, dass GPT-4 menschliche Beiträge in sozialen Netzwerken gemäß den Nutzungsbedingungen bewerten kann. Das System soll deutlich schneller und flexibler skalierbar sein als menschliche Mitarbeitende.

Um GPT-4 als zuverlässiges Moderationssystem zu etablieren, führt OpenAI zunächst ein Alignment mit menschlichen Experten durch: Dazu lässt OpenAI die zu moderierenden Inhalte zunächst von menschlichen Content-Policy-Experten bewerten.

Anschließend führt ein mit der Content Policy gepromptetes GPT-4 die gleiche Bewertung durch. Das Modell wird dann mit der Bewertung des menschlichen Experten konfrontiert und muss eine eventuelle Abweichung von dieser begründen.

Auf Basis dieser Begründung kann dann die Content Policy so angepasst werden, dass das Modell in zukünftigen Moderationsfällen zur gleichen Bewertung wie der Mensch kommt. Wenn die menschliche Bewertung und die GPT-4 zuverlässig übereinstimmen, kann das Modell in der Praxis eingesetzt werden.

Video: OpenAI

Policy-Änderungen in Stunden statt in Monaten

Laut OpenAI lernt das Moderationssystem kontinuierlich dazu und hilft gleichzeitig, die Content-Richtlinien zu verfeinern und zu präzisieren.

Insbesondere die Übernahme von Policy-Änderungen soll einen Zeitvorteil bringen: Das Modell könne diese innerhalb weniger Stunden umsetzen. Menschliche Moderator:innen benötigten dafür Training, ein Prozess, der sich über Monate hinziehen könne.

Um den Rechenaufwand überschaubar zu halten, setzt OpenAI auf ein kleineres Modell, das nach einem Feintuning mit den Vorhersagen des größeren Modells die Ausführung der Moderationsaufgaben übernimmt.

Der Einsatz von KI in der Content Moderation ist nicht neu. So setzt Meta seit vielen Jahren maschinelle Lernverfahren ein, um kritische Themen möglichst schnell zu erkennen und zu löschen.

Allerdings sind diese Systeme thematisch spezialisiert und nicht immer zuverlässig. Sprachmodelle wie GPT-4 haben dagegen das Potenzial, über viele Kategorien hinweg differenzierter und fundierter zu urteilen, vielleicht sogar zu antworten oder zumindest Antwortvorschläge zu machen, die dann nur noch freigeschaltet werden müssen. Eine Studie hat kürzlich gezeigt, dass ChatGPT emotionale Szenarien viel genauer und umfassender beschreiben kann als der durchschnittliche Mensch.

Laut OpenAI könnte GPT-4 daher dazu beitragen, "die psychische Belastung einer großen Anzahl menschlicher Moderatoren zu reduzieren". OpenAI beschreibt ein Szenario, in dem diese Arbeitskraft dann auf "komplexe Randfälle" konzentriert werden könnte, aber natürlich könnte es auch zum Abbau von Arbeitsplätzen kommen.

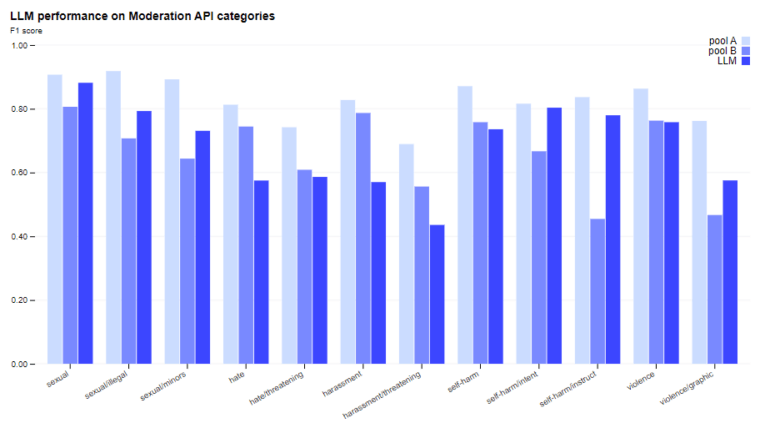

OpenAI will sich mit konstitutioneller KI befassen

Laut OpenAI erreicht das Sprachmodell Moderationsergebnisse, die mit denen wenig trainierter Menschen vergleichbar sind. Gut trainierte menschliche Moderatoren übertreffen die Vorhersagequalität von GPT-4 in allen getesteten Bereichen, wobei der Abstand in den meisten Fällen nicht groß ist. Zudem sieht OpenAI weitere Verbesserungsmöglichkeiten, etwa durch den Einsatz von Gedankenketten-Prompting und die Integration von Selbstkritik.

OpenAI sucht auch nach Möglichkeiten, unbekannte Risiken zu erkennen, die nicht in den Beispielen oder der Policy auftauchen, und will sich in diesem Zusammenhang mit konstituierender KI beschäftigen, die Risiken anhand von High-Level-Beschreibungen identifiziert. Ein möglicher Verweis auf den Wettbewerber Anthropic, der im Gegensatz zu OpenAI seine KI-Modelle nicht auf menschliches Feedback, sondern auf eine Konstitution in Kombination mit KI-Analyse ausrichtet.

Video: OpenAI

OpenAI weist auf die üblichen Risiken beim Einsatz von KI hin: KI-Modelle enthielten soziale Verzerrungen, die sich in den Bewertungen widerspiegeln könnten. Zudem müssten Menschen im Prozess die KI-Anwendung überwachen, schreibt die Firma.

Laut OpenAI kann das vorgeschlagene Verfahren zur Verwendung von GPT-4 für die Moderation von jedem, der Zugang zur Programmierschnittstelle hat, reproduziert werden.