Nvidias neues Cloud-Geschäft konkurriert mit AWS

Nvidia verwendet seine dominante Rolle bei KI-Hardware, um im Cloud-Software-Geschäft Fuß zu fassen.

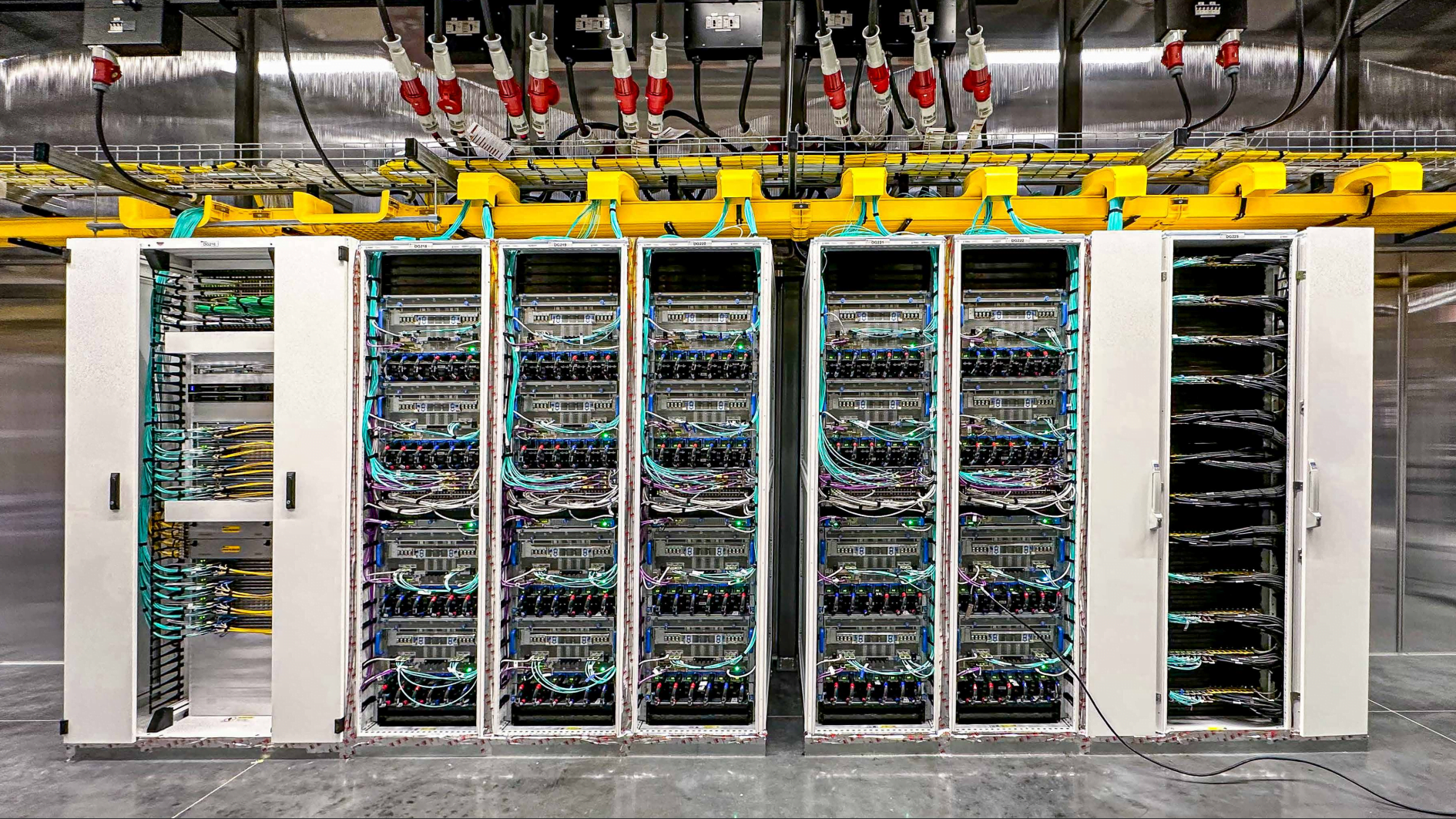

Nvidia stellt mit der H100-GPU nicht nur wohl heiß begehrtesten KI-Chip her, das Unternehmen bietet seit März auch den eigenen Cloud-Dienst DGX Cloud an. Damit erschließt Nvidia ein neues Geschäftsfeld: den Verkauf von Cloud-Software und den direkten Kontakt zu den Geschäftskunden seiner GPUs.

Die Server für DGX Cloud stehen bei großen Cloud-Anbietern: Laut The Information hat Nvidia letztes Jahr mehreren Anbietern angeboten, die eigenen Nvidia-Server bei diesen Cloud-Anbietern zu mieten und den Zugriff darauf direkt an KI-Entwickler zu vermieten.

Amazons AWS lehnte den Vorschlag ab, während Microsoft, Google und Oracle zustimmten.

Nvidia gewinnt direkten Kundenkontakt

Streng genommen verlieren die Cloud-Anbieter durch den Deal keine Einnahmen - Nvidia bezahlt für die Server und vermietet sie teurer weiter. Aber die Kunden, die Nvidias DGX-Cloud nutzen, sind Kunden, die keine KI-Dienste von AWS, Microsoft, Google oder Oracle kaufen.

"Ich kann gut verstehen, warum Amazon nicht mitmacht, denn letztendlich hat Nvidia die Kundenbeziehung", sagt Stacy Rasgon, Analystin bei Bernstein. Die Cloud-Anbieter, die sich auf den Deal eingelassen hätten, seien kleiner als AWS, sodass sie theoretisch durch DGX Cloud Marktanteile von AWS gewinnen könnten, so Rasgon.

Nvidia konzentriert sich auf die Bereitstellung der Rechen- und Softwareinfrastruktur, die es Unternehmen ermöglicht, ihre eigenen KI-Modelle zu trainieren - und dann überall auf der DGX Cloud laufen zu lassen. So sind Unternehmen nicht an einen bestimmten Cloud-Anbieter gebunden, sondern nur an die Hardware von Nvidia.

Zu den Kunden von Nvidias DGX Cloud-Dienst zählen neben Adobe, Getty Images und Shutterstock, die Nvidias Service nutzen, um generative KI-Modelle zu trainieren, bereits einige der größten Kunden von Cloud-Diensten, darunter der IT-Softwaregigant ServiceNow, das Biopharmaunternehmen Amgen und das Versicherungsunternehmen CCC Intelligent Solutions. Letzten Monat erklärte Nvidias CEO Jensen Huang gegenüber Analysten, dass DGX Cloud "ein großer Erfolg" sei.

Nvidia unterstützt kleine Cloud-Anbieter

Ziel von DGX Cloud ist es laut Nvidia hingegen vor allem, das Wissen über die eigene Hardware zu nutzen, um Cloud-Anbietern zu zeigen, wie sie die GPU-Server in ihren Rechenzentren konfigurieren können. Diese könnten dann die optimalen Konfigurationen hochskalieren.

So profitiert Nvidia auch außerhalb des direkten Kundenkontakts von DGX Cloud, denn eine bessere Performance macht die eigene Hardware attraktiver und sichert so die eigene Vormachtstellung auf dem Markt für KI-Hardware.

Darüber hinaus hat das Unternehmen viele seiner wertvollen H100-GPUs an kleinere Anbieter wie CoreWeave, Lambda Labs und Crusoe Energy verkauft, um ihnen zu helfen, mit den großen Anbietern zu konkurrieren. Aus Sicht von Nvidia macht dieser Schritt Sinn, da AWS, Microsoft und Google ihre eigenen KI-Chips entwickeln, um ihre Abhängigkeit von Nvidia zu reduzieren.

KI-News ohne Hype – von Menschen kuratiert

Mit dem THE‑DECODER‑Abo liest du werbefrei und wirst Teil unserer Community: Diskutiere im Kommentarsystem, erhalte unseren wöchentlichen KI‑Newsletter, 6× im Jahr den „KI Radar"‑Frontier‑Newsletter mit den neuesten Entwicklungen aus der Spitze der KI‑Forschung, bis zu 25 % Rabatt auf KI Pro‑Events und Zugriff auf das komplette Archiv der letzten zehn Jahre.

Jetzt abonnierenKI-News ohne Hype

Von Menschen kuratiert.

- Mehr als 20 Prozent Launch-Rabatt.

- Lesen ohne Ablenkung – keine Google-Werbebanner.

- Zugang zum Kommentarsystem und Austausch mit der Community.

- Wöchentlicher KI-Newsletter.

- 6× jährlich: „KI Radar“ – Deep-Dives zu den wichtigsten KI-Themen.

- Bis zu 25 % Rabatt auf KI Pro Online-Events.

- Zugang zum kompletten Archiv der letzten zehn Jahre.

- Die neuesten KI‑Infos von The Decoder – klar und auf den Punkt.