Meta wappnet sich gegen KI-Manipulation während der nächsten EU-Wahl

Meta hat ausführlich dargelegt, wie sich der Social-Riese auf die zu erwartende Wahlmanipulation durch generative KI bei den diesjährigen Europawahlen vorbereitet.

In dem ausführlichen Blogbeitrag skizziert Meta seinen Ansatz zur Wahrung der Wahlintegrität, der auf Erfahrungen aus mehr als 200 Wahlen weltweit seit 2016 beruhe.

Das Unternehmen habe mehr als 20 Milliarden US-Dollar in Sicherheitsmaßnahmen investiert und verfüge über ein Team von 40.000 Mitarbeitern in diesem Bereich, darunter 15.000 Inhaltsprüfer, die mehr als 70 Sprachen beherrschten, darunter alle 24 EU-Sprachen.

Das US-Unternehmen arbeitet mit 26 Faktenprüfungsorganisationen in der gesamten EU zusammen und erweitert sein Programm um drei weitere Partner in Bulgarien, Frankreich und der Slowakei.

Metas Strategie umfasst drei Schwerpunkte: Falschinformationen zu bekämpfen, gezielte Einflussnahme durch Außenstehende einzudämmen und Maßnahmen gegen den Missbrauch generativer KI-Technologien zu ergreifen.

Mit immer fotorealistischeren Bildern aus KI-Generatoren wie der neusten Version von Midjourney dürfte es aber auch geschultem Personal schwer fallen, KI-Inhalte verlässlich als solche zu erkennen.

Um das Risiko zu minimieren, baut Meta auf Standards wie C2PA und IPTC, die KI-Bilder aus dem eigenen Generator und von Drittanbietern wie OpenAIs DALL-E 3, Midjourney, Adobe Firefly, Google Imagen und Shutterstock zu kennzeichnen.

Allerdings gelten diese Wasserzeichen bislang nicht als besonders zuverlässig. Haben menschliche Prüfer:innen KI-Bilder dennoch als solche erkannt, können sie die Bilder der Kategorie "verändert" zuordnen, was sich negativ auf das Ranking der Beiträge auswirkt.

Werbung mit widerlegten Falschinformationen ist ebenfalls verboten. Es gibt bereits zahlreiche Beispiele, in denen KI-Bilder zu Propagandazwecken missbraucht wurden, selbst wenn diese nicht fotorealistisch sind.

Meta will Nutzer bestrafen, die KI-Inhalte nicht als solche kennzeichnen

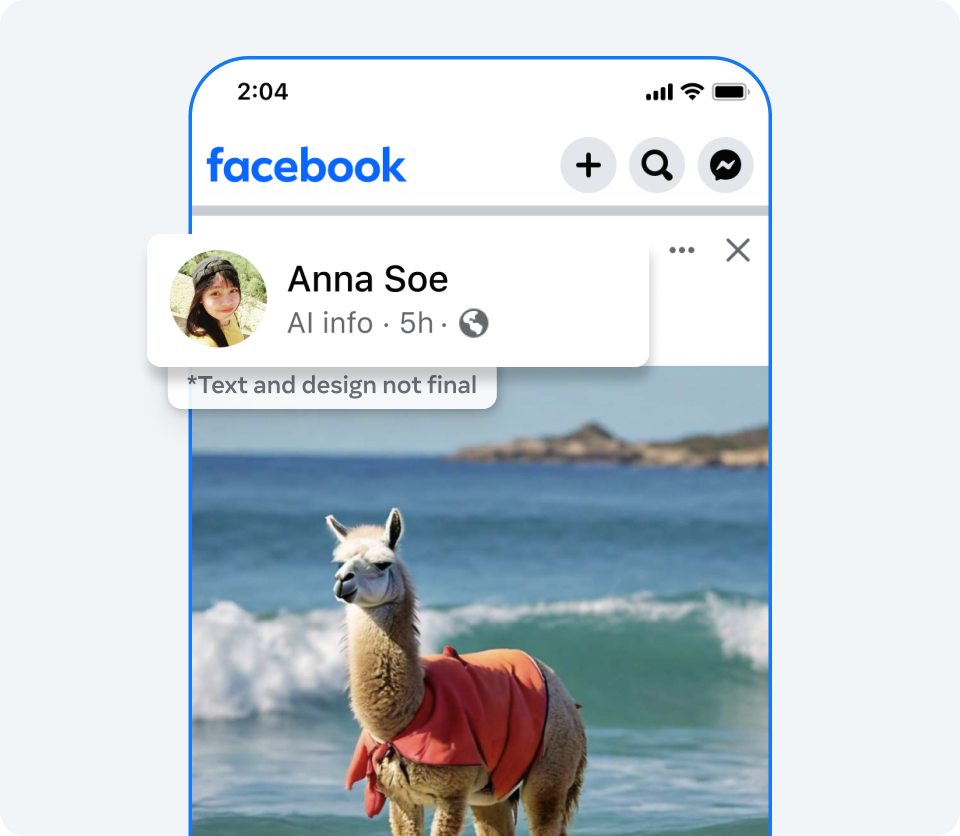

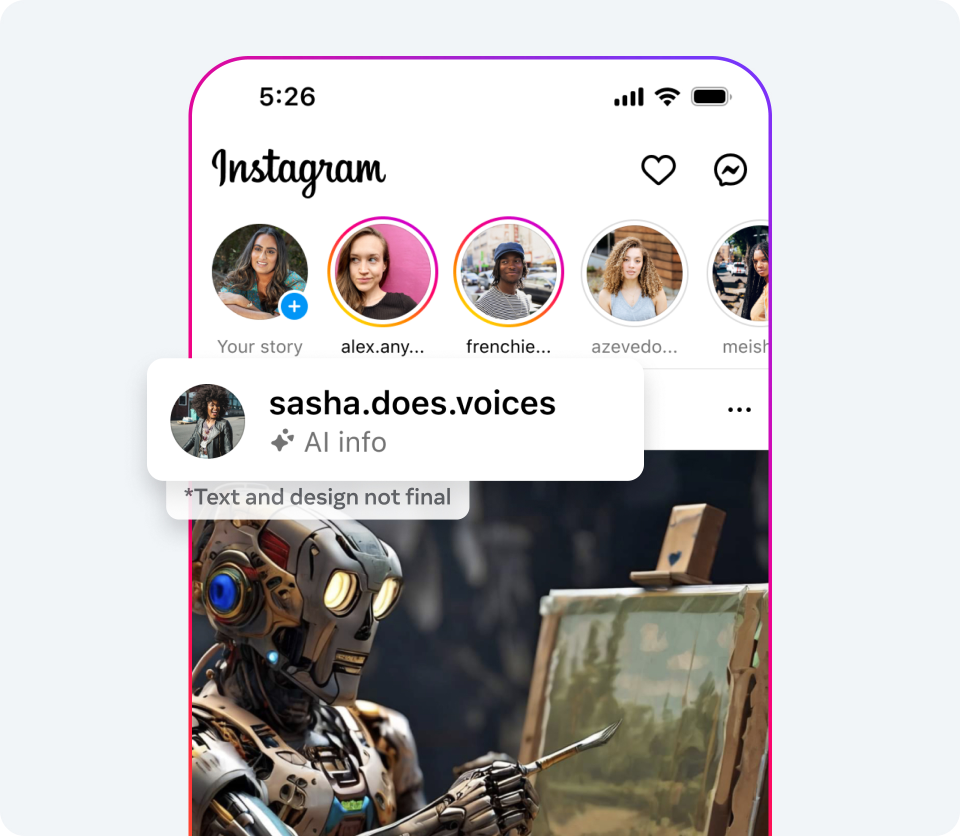

Meta will Nutzer:innen erlauben, ihre Inhalte freiwillig als KI-generiert zu kennzeichnen, und erwägt Bestrafungen, wenn das nicht geschieht. TikTok hat bereits vor einigen Monaten eine solche Funktion eingeführt, wobei nicht bekannt ist, ob Strafen für das Auslassen des KI-Kennzeichens erfolgen.

"Wenn wir feststellen, dass digital erstellte oder veränderte Bild-, Video- oder Audioinhalte ein besonders hohes Risiko bergen, die Öffentlichkeit in einer wichtigen Angelegenheit irrezuführen, können wir eine auffälligere Kennzeichnung hinzufügen, um den Menschen mehr Informationen und Kontext zu bieten", heißt es im Beitrag.

KI-Fake-News zu bekämpfen bleibt Gruppenarbeit

Meta weist außerdem auf Allianzen wie den "Tech Accord to Combat Deceptive Use of AI in 2024 Elections" hin, in dem sich Soziale Netzwerke wie Meta, TikTok und X, aber auch andere wichtige Branchentreiber wie OpenAI, Google und Amazon dem gemeinsamen Kampf gegen Falschinformationen im Zusammenhang mit diesjährigen Wahlen verschrieben haben. Neben der EU-Wahl spielt auch die US-Präsidentschaftswahl in diesem Jahr eine große Rolle in der globalen Politik.

Wie akut die Gefahr durch Deepfakes ist, betont ein offener Brief von führenden KI-Forschenden, die Regierungen dazu aufrufen, Unternehmen gesetzlich zu Gegenmaßnahmen zu verpflichten.

Weiteres Futter für KI-Risiken liefert eine kürzlich veröffentlichte Studie, laut der Menschen nicht zwischen menschlich und KI-erstellten Fake News unterscheiden können.

KI-News ohne Hype – von Menschen kuratiert

Mit dem THE‑DECODER‑Abo liest du werbefrei und wirst Teil unserer Community: Diskutiere im Kommentarsystem, erhalte unseren wöchentlichen KI‑Newsletter, 6× im Jahr den „KI Radar"‑Frontier‑Newsletter mit den neuesten Entwicklungen aus der Spitze der KI‑Forschung, bis zu 25 % Rabatt auf KI Pro‑Events und Zugriff auf das komplette Archiv der letzten zehn Jahre.

Jetzt abonnierenKI-News ohne Hype

Von Menschen kuratiert.

- Mehr als 20 Prozent Launch-Rabatt.

- Lesen ohne Ablenkung – keine Google-Werbebanner.

- Zugang zum Kommentarsystem und Austausch mit der Community.

- Wöchentlicher KI-Newsletter.

- 6× jährlich: „KI Radar“ – Deep-Dives zu den wichtigsten KI-Themen.

- Bis zu 25 % Rabatt auf KI Pro Online-Events.

- Zugang zum kompletten Archiv der letzten zehn Jahre.

- Die neuesten KI‑Infos von The Decoder – klar und auf den Punkt.