Mit ihrem Buch "Atlas of AI" will Kate Crawford, Kommunikations- und Sozialwissenschaftlerin an der University of Southern California und führende Microsoft-Forscherin, zur Aufklärung über Künstliche Intelligenz beitragen - und der Technologie so letztlich in engeren Bahnen den Weg bereiten.

In "Atlas of AI" (Link am Ende des Artikels) will Crawford die gesamte Wertschöpfungskette hinter künstlicher Intelligenz zeigen - und dass diese eben nicht so künstlich ist, wie viele annehmen mögen. Das gängige Konzept von KI sei abstrakt und immateriell, so Crawfords These, dabei wirke sich die Technologie deutlich auf Umwelt und Menschen aus.

Für ihr Buch besuchte sie unter anderem Minen, um ein Gefühl für die Umweltkosten riesiger Cloud-Rechensysteme zu erhalten. In einem Amazon-Fulfillment-Center beobachtete sie, wie ein algorithmisches Managementsystem die Arbeiter physisch und psychisch fordert.

"KI ist weder künstlich noch intelligent. Sie wird aus natürlichen Materialien geschaffen und Menschen machen die Aufgaben, die KI autonom erscheinen lassen", sagt Crawford zu The Guardian. Sie bezieht sich unter anderem auf Lohnarbeiter, die für wenig Geld in mühevoller Kleinarbeit große Datensätze für das KI-Training aufbereiten.

Indem Crawford diese Strukturen freilegt, will sie die Aufmerksamkeit von mehr Menschen auf die Implementierung und Regulierung von KI lenken. "Diese Systeme werden in einer Vielzahl von Sektoren ohne starke Regulierung, Zustimmung oder demokratische Debatte eingeführt", sagt Crawford.

KI-Vorurteil: Lösen mehr Daten das Problem?

Ein bekanntes Problem Künstlicher Intelligenz sind in den Trainingsdatensätzen verborgene Vorurteile. Mit diesen haben selbst fortschrittliche KI-Systeme wie OpenAIs GPT-3 zu kämpfen. Noch gibt es aus der Wissenschaft keine Antwort auf die Frage, ob und wie dieses Problem in den Griff zu bekommen ist. KI-Vorurteile in GPT-3 diskutieren wir im MIXED.de Podcast #246.

Geht es nach Crawford, sind KI-Vorurteile ein Problem grundlegender Natur, das allein durch immer größere Datensätze nicht gelöst werden könne. Das Problem sei, wie die Datensätze entstünden - klassifiziert durch Menschen.

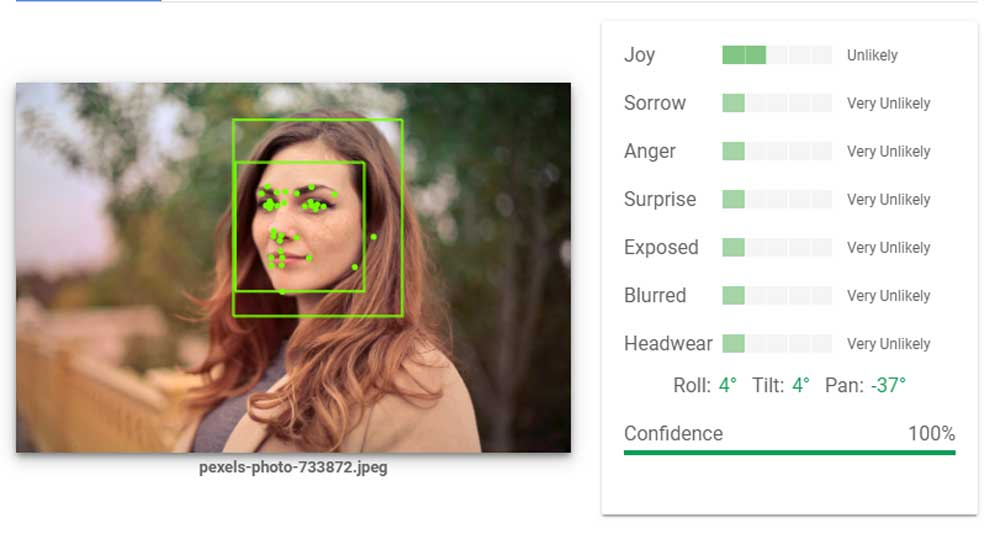

Unter anderem habe sie 2017 mit dem Künstler Revor Paglen den bekanntesten Computer-Vision-Datensatz "ImageNet" analysiert und dabei Kategorien gefunden, die "frauenfeindlich, rassistisch, ableistisch und in höchstem Maße wertend waren." Menschen seien allein ob ihres äußeren Erscheinungsbildes beispielsweise als "Alkoholiker" oder "Schlampe" eingestuft worden.

"Ich habe die tieferen Logiken der Klassifizierung betrachtet, und man erkennt Formen der Diskriminierung, nicht nur bei der Anwendung der Systeme, sondern auch bei der Art und Weise, wie sie gebaut und trainiert werden, um die Welt zu sehen", sagt Crawford. "[Es gibt] Trainingsdatensätze, die für maschinelle Lernprogramme verwendet werden, die Menschen beiläufig in nur eines von zwei Geschlechtern kategorisieren; die Menschen entsprechend ihrer Hautfarbe in eine von fünf Rassenkategorien einordnen und die versuchen, basierend auf dem Aussehen von Menschen, moralischen oder ethischen Charakter zuzuordnen."

Mehr und härtere KI-Regeln

ImageNet habe sie als öffentlichen Datensatz untersuchen können und das Team hinter dem Datensatz habe reagiert und viele problematische Kategorien entfernt, erklärt Crawford. Allerdings würden die ursprünglichen Bildersets noch immer im Internet zirkulieren und potenziell für das KI-Training verwendet. Außerdem hätten Konzerne geheime Trainingsdatensätze im Einsatz basierend auf den Fotos, die Menschen ins Internet hochladen.

Wie viele Wissenschaftler fordert Crawford "viel stärkere Regulierungsvorschriften und größere Strenge und Verantwortung bei der Erstellung von Trainingsdatensätzen" sowie ein diverseres Meinungsbild in Abstimmungsprozessen. Gerade benachteiligte Personen müssten in die Debatte um KI-Regulierungen integriert werden.

Crawford fordert zusätzlich "eine neue Politik der Verweigerung, die das Narrativ infrage stellt, dass eine Technologie, nur weil sie gebaut werden kann, auch eingesetzt werden sollte." Zuversichtlich stimmten sie die Regulierungsansätze der EU und der australischen Regierung sowie Proteste von Aktivisten.

Quelle: The Guardian; Titelbild: Google, Image-Klassifizierung