Künstliche Intelligenz: Was 2020 war und 2021 wird

2020 ist der Beginn einer neuen Dekade für Künstliche Intelligenz und das Jahr, in dem KI beginnt, ihr Potenzial zu realisieren.

Letztes Jahr zeichnete das Ende der Dekade, in der Künstliche Intelligenz sich zu einer transformativen Technologie entwickelte, deren mögliche Auswirkungen auf Wirtschaft und Gesellschaft mit denen des Internets und der Elektrizität vergleichbar sind.

2020 ist der Beginn einer neuen Dekade, in der sich endgültig zeigen wird, ob die Technologie ihr transformatives Potenzial verwirklichen kann.

Die Kurzfassung meines KI-Jahresrückblicks 2020: Es sieht ganz danach aus. Die ausführliche Fassung folgt jetzt.

Riesige Sprachmodelle zeigen die Macht des Datentrainings

2019 demonstrierte die beeindruckende Schreibfähigkeit von OpenAIs GPT-2 das Potenzial großer Sprachmodelle, die mit viel Text trainiert wurden. Im Mai 2020 stellte OpenAI den Nachfolger vor: GPT-3 ist hundertmal größer und mit 570 Gigabyte statt 40 Gigabyte Internet-Text trainiert.

GPT-3 schreibt noch glaubwürdigere Texte als GPT-2 und ist so sicher in der Textgenerierung, dass die KI sogar Geschichten erzählen oder berühmte Personen wie John Carmack imitieren kann.

Dazu kann GPT-3 nach wenigen Datenbeispielen neue Aufgaben neben der Textgenerierung meistern, etwa HTML-Code generieren oder Zahlen addieren.

Auf Reddit fällt GPT-3 anderen Nutzern nicht als Bot auf und ein komplett von GPT-3 geschriebener Blog hat tausende Besucher. Die Grenze zwischen mensch- und maschinengeschriebenem Text verschwimmt. Den umstrittenen Turing-Test besteht GPT-3 allerdings nicht.

GPT-3 ist so fähig, dass die Text-KI OpenAIs erstes kommerzielles Produkt wird: Über eine API können sich Bewerber den Zugang zur Text-KI kaufen und für eigene Produkte nutzen. Microsoft kauft sich Exklusivrechte am Code und darf GPT-3 in eigenen Produkten verwenden und anpassen.

Deutsche Experten zeigen sich beeindruckt von GPT-3, warnen aber auch vor allzu viel Optimismus, dass die Text-KI mehr sein könnte als Autovervollständigung auf Steroiden. Diese Position teilen sie sich mit Facebooks KI-Chef Yann LeCun, und auch OpenAI Mitgründer Sam Altman warnt vor zu viel Hype um GPT-3.

Unabhängig dieser mahnenden Worte: GPT-3 zeigt das Potenzial von mit vielen Daten trainierten neuronalen Netzen.

Dieses Potenzial haben auch andere erkannt: Google und Facebook stellen ihre riesigen Sprachmodelle M4 und M2M-100 für die Übersetzung vor. Für die Tech-Riesen sind die Modelle vor allem ein Ingenieurstraining für die Konstruktion riesiger neuronaler Netze auf Basis der Transformer-Architektur, die auch bei GPT-3 grundlegend ist.

Transformative Transformer

Transformer haben in den letzten zwei Jahren die Computerlinguistik revolutioniert und mächtige Sprach-KIs wie OpenAIs GPT-3, Googles BERT und Facebooks RoBERTa ermöglicht.

Transformer arbeiten mit einem Mechanismus, den KI-Forscher "Aufmerksamkeit" nennen: Sie verarbeiten ihre Eingabedaten im Kontext der gesamten Umgebungsdaten, etwa Wörter im Kontext eines Paragrafen.

Transformer sind eine Variante klassischer Feed-Forward-Netze. Im Unterschied zu diesen können sie ihre Gewichtungen (Erklärung) aber nach dem Training weiter anpassen. Eine ausführliche Erklärung zu Transformern gibt es in unserem KI-Jahresrückblick-Podcast mit Gast Yannic Kilcher.

Transformer beweisen 2020 auch abseits der Computerlinguistik ihren Nutzen. Vor allem in der Bildanalyse erzielen auf Transformer basierende KI-Systeme große Fortschritte. Facebooks DETR kombinierte gefaltete neuronale Netze mit einem Transformer, um die Leistung der Bildanalyse Faster R-CNN zu erreichen, dem bisherigen Spitzenreiter.

Googles KI-Modell Vision Transformer (ViT) hingegen verwendet ausschließlich Transformer und schickt sich an, zum neuen Standard in der Bildanalyse zu werden. OpenAI zeigt mit iGPT, dass Transformer auch Bilder vervollständigen können.

Die Fortschritte durch Transformer in der Bildanalyse zeigen das Potenzial des Aufmerksamkeitsmechanismus. Die Technik legt durch eine vereinheitlichte Architektur für Text- und Bildaufgaben außerdem den Grundstein für flexiblere Künstliche Intelligenz.

KI kommt in anderen Wissenschaften an

Anfang des Jahres veröffentlicht Deepmind sechs zuvor unbekannte Proteinstrukturen des SARS-CoV-2-Virus. Zwei dieser sechs Vorhersagen sind mittlerweile empirisch bestätigt. Berechnet hatte die Strukturen Deepminds AlphaFold, die proteinfaltende KI, wegen der Deepmind Ende 2019 viel Aufmerksamkeit zuteil wurde.

Es ist der Beginn eines Wandels des Londoner KI-Labors: Die Algorithmen der Forscher bewegen sich langsam vom Brett- und Computerspiel in die echte Welt. Das macht das Unternehmen - trotz der Milliardenverluste - zum Star in Alphabets Unternehmens-ABC. Deepminds neues Motto: Weniger Hype, mehr Wissenschaft.

Vorläufiger Höhepunkt in Deepminds junger Unternehmensgeschichte ist der Triumph von AlphaFold 2 im Herbst 2020: Im CASP-Wettbewerb für die Vorhersage von Proteinfaltung deklassiert die KI die Konkurrenz.

Von den knapp 100 im Wettbewerb zu lösenden Proteinsequenzen sagt sie die Struktur von 70 Sequenzen ebenso präzise wie experimentelle Verfahren vorher. Das ist ein historischer Durchbruch bei der Vorhersage von Proteinfaltungen und könnte die Proteinforschung um Jahre beschleunigen. Auch AlphaFold 2 verwendet wohl Transformer-Technik.

Künstliche Intelligenz findet ihren Weg in weitere wissenschaftliche Felder: Googles Fabricius hilft Ägyptologen, Hieroglyphen zu übersetzen. Eine Mathematik-KI hilft, die Bewegung von drei Körpern im Raum mit hoher Genauigkeit vorherzusagen, und Astrophysiker Miles Cranmer zeigt, dass sich mit Künstlicher Intelligenz Naturgesetze aus Daten gewinnen lassen – der Beginn einer möglichen Wissenschaftsrevolution.

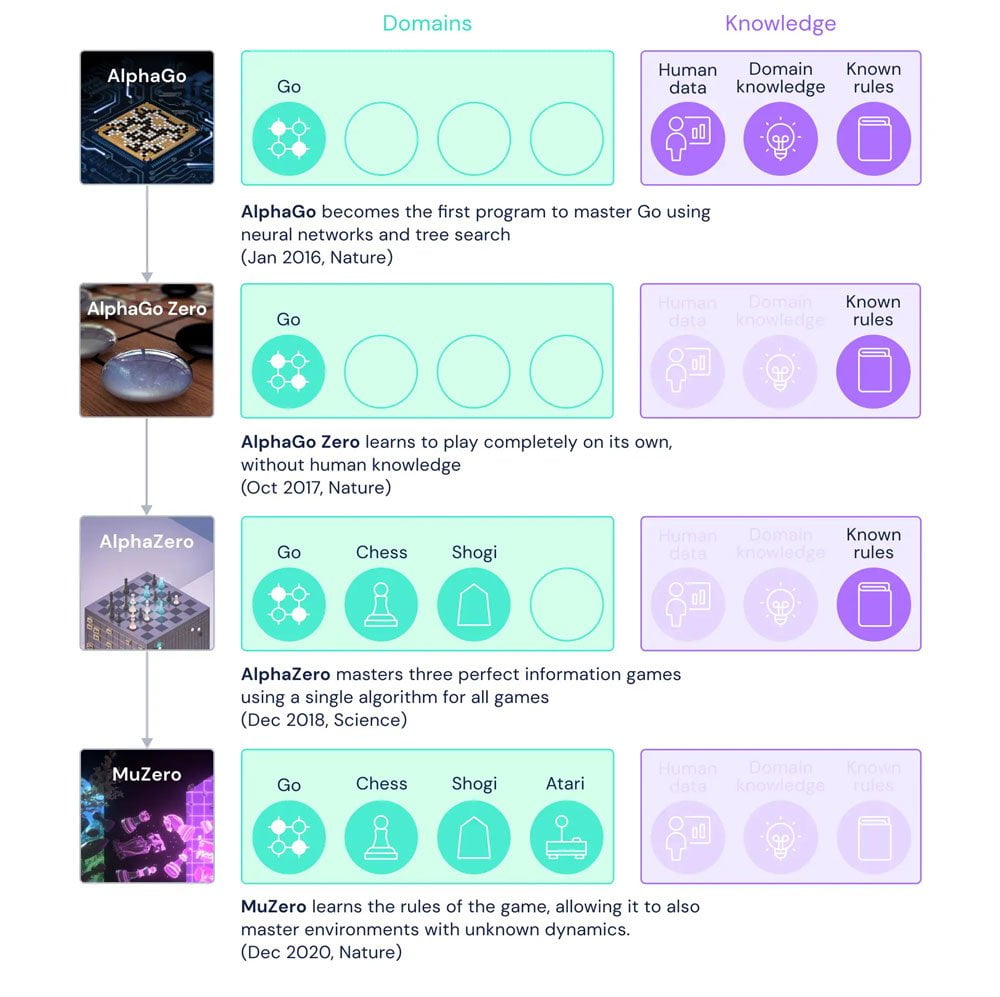

Deepmind macht KI flexibler

Für Deepmind endet das Jahr mit einer weiteren Schlagzeile: MuZero, der Nachfolger der Brettspiele-KIs AlphaGo, AlphaGo Zero und AlphaZero, könnte ein wichtiger Schritt auf dem Weg zum universellen Algorithmus sein.

Die KI schlägt ihre Vorgängeralgorithmen in sämtlichen Spielarten und kann noch dazu einfache Computerspiele für den Atari meistern. Besonders beeindruckend ist dabei, dass die KI die jeweiligen Spielregeln selbstständig lernt.

"Die echte Welt ist chaotisch und kompliziert, niemand verrät uns die Regeln, nach denen sie funktioniert", sagt David Silver, leitender Deepmind-Forscher gegenüber der BBC. "Zum ersten Mal haben wir ein System, das in der Lage ist, ein eigenes Verständnis davon zu entwickeln, wie die Welt funktioniert."

MuZero könnte daher in einer Reihe stehen mit Deepminds AlphaFold: ein KI-Algorithmus, der Probleme in der realen Welt löst.

George Hotz, Gründer des KI-Start-ups für autonomes Fahren Comma AI, sieht in MuZero gar die Lösung für selbstfahrende Autos. Bis dahin müssen sich autonom fahren wollende Autofahrer mit Teslas im Herbst veröffentlichter Full Self-Driving-Beta zufriedengeben.

Wie kommt MuZero in unserem Alltag an? Deepmind entwickelt mit der KI neue Kompressionsalgorithmen für Videos, während das US-Militär MuZero Ziele auf dem Radar eines Aufklärungsflugzeugs auswählen lässt. Bei einem Testflug gibt ein menschlicher Pilot das erste Mal die Kontrolle militärischer Systeme während eines Fluges an eine KI ab.

Deepfakes: Entertainment statt Wahlmanipulation

Social-Media-Plattformen wie YouTube, Twitter, Facebook und TikTok verabschieden Anfang 2020 Anti-Deepfake-Richtlinien, doch die befürchtete Deepfake-Schwemme zur US-Wahl bleibt aus. Vor dieser hatte unter anderem der US-Kongress eindringlich gewarnt.

Stattdessen setzt sich der Trend aus 2019 fort, dass die vermeintlich gefährliche Technologie zum Kreativspringbrunnen für Techies wird.

Abseits von YouTubes Deepfake-Szene arbeitet Disney an Megapixel-Deepfakes, die die KI-Pixeltechnik auf die große Leinwand bringen sollen. Beim Serienhit The Mandalorian setzt der Entertainment-Konzern noch auf CGI-Handarbeit - und wurde prompt nach nur drei Tagen nach Ausstrahlung der letzten Folge von einem Deepfake-YouTuber übertrumpft. Beispiele dieser Art gibt es mittlerweile viele.

Nvidia baut seinen Vorsprung beim KI-Grafik-Upscaling für Computerspiele aus. Die RTX-30-Grafikkarten bringen, wie schon die Vorgängerkarten, für KI-Berechnungen spezialisierte Tensor-Kerne in viele Privathaushalte.

Die Spezialchips werden für das KI-Upscaling DLSS benötigt: Spiele wie Control, Death Stranding und Cyberpunk 2077 zeigen, wie stark sich Computergrafik durch Künstliche Intelligenz ändert. Die neuste Version DLSS 2.1 unterstützt VR-Anwendungen. AMD hat noch keine Antwort parat – ein eigener KI-Upscaler soll wohl 2021 kommen.

Spezialisierte KI-Hardware auf dem Vormarsch

Auch abseits des Spielemarkts verstärkt Nvidia seine Investitionen in Künstliche Intelligenz und stellt die neue Ampere A100 GPU vor, die je nach KI-Berechnung bis zu 2.000 Prozent schneller als die Vorgängerkarte ist.

Nvidia baut außerdem KI-Supercomputer in den USA und Europa, verbessert Videokonferenzen mit KI und arbeitet an KI-generierten virtuellen Umgebungen. Konzernchef Jensen Huang glaubt an die KI-Revolution und sagt: "Alles wird KI sein."

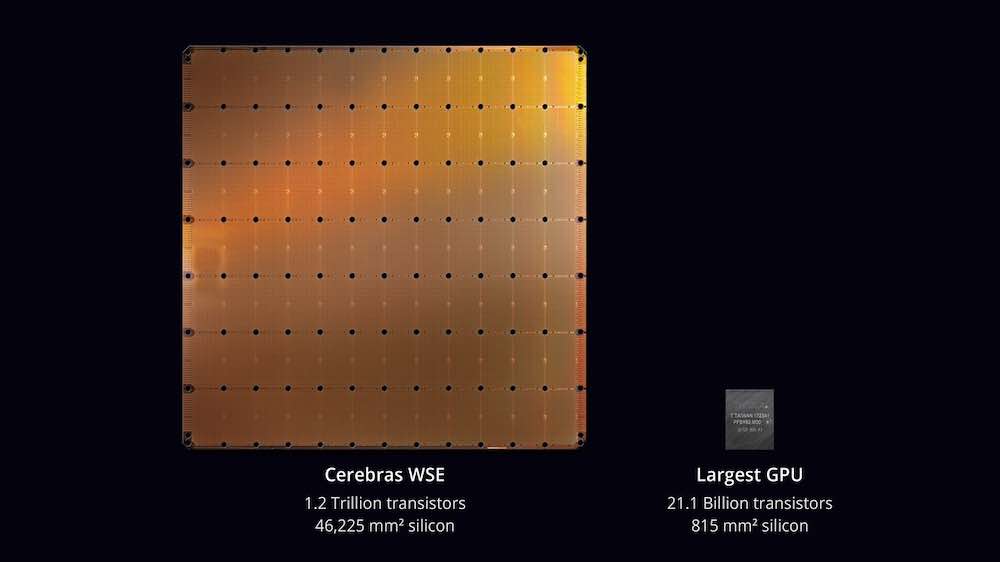

KI-Chip-Konkurrenz bekommt Nvidia von Halbleiter-Startups wie Cerebras oder Graphcore. Cerebras baut riesige Chips mit 2,6 Billionen Transistoren, die die KI-Performance explodieren lassen könnten.

Halbleiter-Produzent TSMC will die für den Cerebras-Chip entwickelte Technologie in den nächsten zwei Jahren kommerzialisieren und damit die Chip-Architekturen anderer Unternehmen fertigen.

Graphcore übertrumpft Ende 2020 Nvidia in neuen KI-Performance-Benchmarks, deren Validierung allerdings noch aussteht. Seit der Gründung 2016 konnte sich das Unternehmen bereits 710 Millionen US-Dollar an Investorengeldern sichern.

Die schnelleren Chips könnten langfristig riesige KI-Netzwerke trainieren, die GPT-3 wie einen Zwerg aussehen lassen. Das würde OpenAIs Analyse bestätigen, dass der Rechenaufwand für das KI-Training stetig sinkt.

KI-Überwachung breitet sich aus

KI-Überwachung und der Einsatz von Gesichtserkennungsalgorithmen in der Öffentlichkeit sowie in privaten Geräten nimmt weiter zu.

Die Londoner Polizei führt Gesichtserkennung offiziell ein, in Moskau werden Gesichtserkennungsdaten bei Telegram verschachert, US-Polizisten nutzen die umstrittene Gesichtserkennungs-App Clearview trotz eines Verbots weiter, China stellt Schlafanzugübeltäter mit Hilfe von Gesichtserkennung an den digitalen Pranger und die Bundespolizei behauptet wohl fälschlicherweise, ihr Test von KI-Gesichtskontrollen am Südkreuz Berlin sei ein voller Erfolg gewesen.

Doch es regt sich Widerstand gegen Gesichtserkennung: Es kommen Zweifel auf an den Behauptungen der Hersteller, die Software arbeite zuverlässig.

Industrie und Politik reagieren: Amazon und Microsoft verkünden einen vorläufigen Verkaufstopp von Gesichtserkennungsalgorithmen an die US-Polizei. Die EU denkt über ein Gesichtsscan-Verbot nach und Google und Microsoft fordern politische Regeln für den Einsatz der Technik.

Die Stadt Portland verbietet Gesichtserkennung für Behörden und Unternehmen und setzt sich gegen Amazon-Lobbyismus durch. Das bisher strengste Verbot der Technologie in Portland könnte wegweisend für andere Gesetzgeber werden und eine stärkere Regulierung der Systeme nach sich ziehen, die persönliche Daten für unternehmerische Zwecke sammeln.

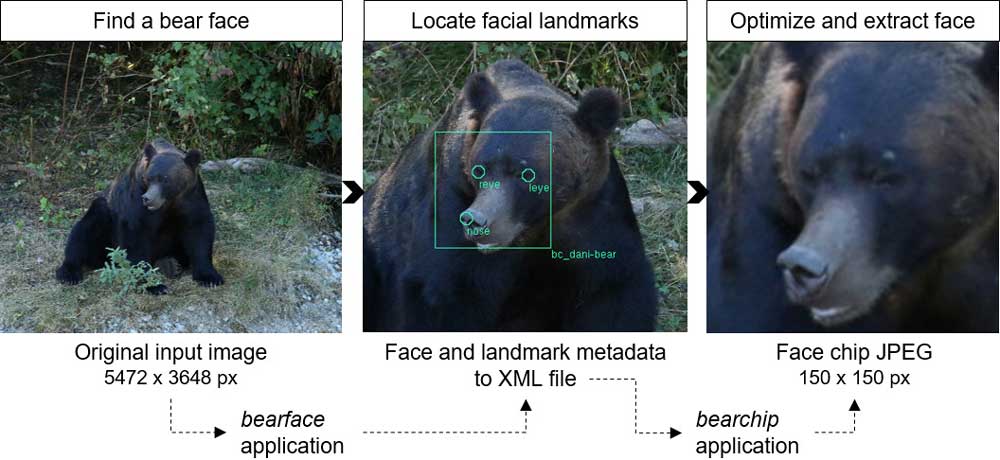

Nicht nur Menschen können per KI überwacht werden: Forscher verwenden Gesichtserkennung für Bären, um sie besser zu schützen.

Den Sinneswandel der US-Behörden beim Thema Datenschutz bekommt Facebook zu spüren: Das Unternehmen wird von der US-Handelsaufsicht und 48 Bundestaaten wegen rechtswidrigen Wettbewerbs verklagt. Dabei geht es unter anderem um die umfangreiche Datensammelei des Konzerns über viele Anwendungen hinweg.

Das gleiche Thema beschäftigt auch deutsche Behörden: Das Bundeskartellamt leitet ein Missbrauchsverfahren gegen Facebook ein, dass sich gegen die Account-Kopplung von Facebook- und Oculus-Konto richtet. Mit den VR-Verhaltensdaten erhält Facebook Zugriff auf eine neue Datenklasse, die auch dem KI-Training dienen könnte. Gegen die Zusammenführung von Daten aus verschiedenen Facebook-Quellen gibt es bereits ein Verfahren von Anfang 2019.

Ethische Bedenken zu KI-Anwendungen für die Überwachung bringen die Veranstalter der größten KI-Konferenz NeurIPS dazu, in allen Forschungspapieren einen Abschnitt über mögliche soziale Auswirkungen Künstlicher Intelligenz zu fordern. Der Entwickler der verbreiteten Bildanalyse-KI YOLO hört mit der Weiterentwicklung seiner KI auf, weil er keinen Beitrag zur Massenüberwachung leisten will.

Mehr als 1.000 KI-Forscher stellen sich gegen die geplante Publikation eines Forschungspapiers, das behauptet, kriminelles Potenzial aus Gesichtszügen mit KI ableiten zu können. Diese KI-Physiognomie zeigt deutlich, dass moderne Technologie nicht vor altem Irrglauben gefeit ist.

KI: 2021 wird interdisziplinär und vielseitiger

Interdisziplinäre Projekte wie AlphaFold 2 könnten 2021 für noch mehr KI-Einsatz in der Wissenschaft sorgen. Algorithmen für das bestärkende Lernen wie MuZero werden weiter Höchstwerte in KI-Benchmarks erzielen und sich der Lösung komplexer Herausforderungen wie dem autonomen Fahren annähern.

Hier sind auch Neuigkeiten von Tesla zu erwarten, da 2021 der für das Fahrtraining gedachte Tesla-Supercomputer Dojo in Betrieb genommen werden soll. Roboter wie Boston Dynamics Spot Mini könnten ebenfalls von flexiblerer KI wie MuZero profitieren.

Die Transformer-Architektur wird sich vorerst als KI-Standard für Sprach- und Bildaufgaben etablieren und in neuen Anwendungsfeldern eingesetzt. Stärkere KI-Hardware könnte zu besseren Sprachmodellen wie GPT-4 und zu ersten multimodal trainierten Transformer-basierten KIs führen, die Sprach- mit Bildanalyse kombinieren und Wissen aus beiden Domänen repräsentieren.

Womöglich zeigt sich anhand von Deepminds MuZero, ob für weiteren KI-Fortschritt der daten- und leistungsgetriebene Deep-Learning-Ansatz ausreicht oder symbolische KI-Systeme die bessere Alternative sind, wie sie Robust.AI-Gründer Gary Marcus fordert. Ein aktuelles Forschungspapier von Deepmind widerspricht dieser These bereits: Dort heißt es, dass neuronale Netze logische Schlüsse ziehen können, für die bisher von Hand programmierte symbolische Systeme nötig waren.

Mit der weiteren Verbreitung von KI wird der Anspruch an die Erklärbarkeit (Explainability) der Entscheidungen maschineller Lernsysteme steigen, etwa beim Einsatz Künstlicher Intelligenz in der Medizin. In die KI-Diagnostik wurden in den letzten zwei Jahren hunderte Millionen US-Dollar investiert. Dazu wird es 2021 weitere Regulierungen und Investitionen seitens staatlicher Akteure geben, so wie sie etwa von der Enquete-Kommission für Künstliche Intelligenz des deutschen Bundestags empfohlen wurden.

Welche KI-Fortschritte dieses Jahr im Detail bringen mag: Künstliche Intelligenz überspringt den Winter und startet direkt in den nächsten Frühling. Derzeit sieht es nicht so aus, als könnten politische Entscheidungen und gesellschaftliche Entwicklungen mit dem Tempo der KI-Branche Schritt halten.

KI-News ohne Hype – von Menschen kuratiert

Mit dem THE‑DECODER‑Abo liest du werbefrei und wirst Teil unserer Community: Diskutiere im Kommentarsystem, erhalte unseren wöchentlichen KI‑Newsletter, 6× im Jahr den „KI Radar"‑Frontier‑Newsletter mit den neuesten Entwicklungen aus der Spitze der KI‑Forschung, bis zu 25 % Rabatt auf KI Pro‑Events und Zugriff auf das komplette Archiv der letzten zehn Jahre.

Jetzt abonnierenKI-News ohne Hype

Von Menschen kuratiert.

- Mehr als 20 Prozent Launch-Rabatt.

- Lesen ohne Ablenkung – keine Google-Werbebanner.

- Zugang zum Kommentarsystem und Austausch mit der Community.

- Wöchentlicher KI-Newsletter.

- 6× jährlich: „KI Radar“ – Deep-Dives zu den wichtigsten KI-Themen.

- Bis zu 25 % Rabatt auf KI Pro Online-Events.

- Zugang zum kompletten Archiv der letzten zehn Jahre.

- Die neuesten KI‑Infos von The Decoder – klar und auf den Punkt.